古諺道:“熟讀唐詩三百首,不會作詩也會吟。” 這句話放在目前的人工智能語言模型中也非常適用。

此前,OpenAI 的研究人員開發出 “GPT-3”,這是一個由 1750 億個參數組成的 AI 語言模型,堪稱有史以來訓練過的最大的語言模型,可以進行原始類比、生成配方、甚至完成基本代碼編寫。

如今,這一記錄被打破了。近日,谷歌研究人員開發出一個新的語言模型,它包含了超過 1.6 萬億個參數,這是迄今為止最大規模的人工智能語言模型,比之前谷歌開發的語言模型 T5-XXL 的規模大了 4 倍。

參數是機器學習算法的關鍵所在,它們是從歷史訓練數據中學習到的模型的一部分。一般而言,在語言領域中參數的數量和復雜度之間的相關性非常好。這一點類似于 GPU 中晶體管的數量,在同樣的制程工藝下,晶體管越多其算力便越強,而語言模型包含的參數愈多就愈接近人類自然語言。

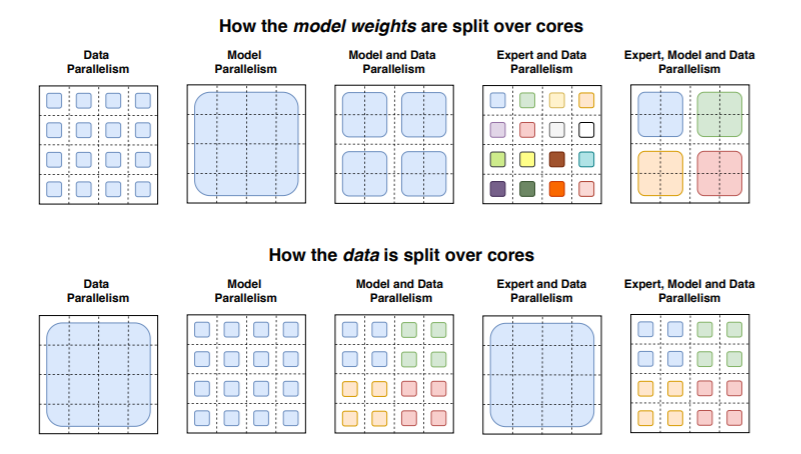

正如研究人員在一篇論文中指出的那樣,大規模的訓練是通向強大模型的有效途徑,在大數據集和參數計數的支持下,簡單的體系結構遠遠超過了更復雜的算法。但是,有效的大規模培訓在計算上非常密集。這就是為什么研究人員熱衷于他們所說的 “開關變壓器”,這是一種 “稀疏激活” 技術,它只使用模型權重的一個子集或者在模型中轉換輸入數據的參數。

“開關變壓器” 是早在 90 年代初首次提出的一種人工智能模型范例,大體意思是將多個專家或專門處理不同任務的模型放在一個更大的模型中,并有一個 “門控網絡” 來選擇為任何給定數據咨詢哪些專家。

在一項實驗中,研究人員使用 32 個 TPU 內核對幾個不同的 “開關變壓器” 模型進行了預訓練,這些 TPU 內核位于一個從 Reddit、Wikipedia 和其他網絡資源中搜集的 750GB 大小的文本數據語料庫中,任務則是讓這些模型預測段落中 15% 的單詞被遮住的缺失單詞,以及其他挑戰,比如檢索文本來回答一系列越來越難的問題。

研究人員稱,包含了 1.6 萬億參數和 2048 名專家的模型 Switch-C 顯示 “完全沒有訓練不穩定性”。然而,在桑福德問答數據集的基準測試中,Switch-C 的得分居然比僅包含 3950 億個參數和 64 名專家的模型 Switch-XXL 還要低一點,對此,研究人員認為是因為微調質量、計算要求和參數數量之間的不透明關系所致。

在這種情況下,“開關變壓器” 導致了一些下游任務的收益。例如,研究人員稱在使用相同數量的計算資源的情況下,它可以使訓練前的加速速度提高 7 倍以上。他們還證明 “稀疏激活” 技術可以用來創建更小、更密集的模型,這些模型可以對任務進行微調,其質量增益為大型模型的 30%。

對此他們表示:雖然這項工作主要集中在超大模型上,但我們也發現只有兩名專家的模型可以提高性能,同時很容易適應通用 GPU 或 TPU 的內存限制。另外,通過將稀疏模型提取為稠密模型,可以實現 10 到 100 倍的壓縮率,同時獲得專家模型約 30% 的質量增益。

在另一個測試中,“開關變壓器” 模型被訓練在 100 多種不同語言之間進行翻譯,研究人員觀察到 101 種語言的 “普遍改善”,91% 的語言受益于比基線模型快 4 倍以上的速度。未來,研究人員還計劃將 “開關變壓器” 應用于新的領域,比如圖像和文本。他們認為,模型稀疏性可以賦予優勢,在一系列不同的媒體以及多模態模型。

美中不足的是,研究人員的工作沒有考慮到這些語言模型在現實世界中的影響,比如模型通常會放大一些公開數據中的偏見。對此,OpenAI 公司指出,這可能導致在女性代詞附近放置 “淘氣”;而在 “恐怖主義” 等詞附近放置 “伊斯蘭” 等。根據米德爾伯里國際研究所的說法,這種偏見可能被惡意行為者利用,通過散布錯誤信息、造謠和謊言來煽動不和。

而路透社也曾報道稱,谷歌的研究人員現在被要求在研究人臉和情緒分析以及種族分類等話題之前,先咨詢法律、政策和公關團隊,性別或政治派別。

綜上所述,盡管谷歌訓練的 1.6 萬億參數的人工智能語言模型還沒辦法做到真正意義上的人工智能,存在一些不足之處需要完善和優化,但隨著在摩爾定律下電子設備算力的不斷提升,近些年 AI 語言模型參數量級呈指數倍發展,相信在不久的將來,或許真的會出現一個無限接近熟讀人類歷史所有文明記錄的超級模型,能夠和人類完全實現自然語言交流,不妨讓我們好好期待一下吧!

原文標題:GPT-3記錄被打破!谷歌推出1.6萬億參數的人工智能語言模型

文章出處:【微信公眾號:DeepTech深科技】歡迎添加關注!文章轉載請注明出處。

責任編輯:haq

-

谷歌

+關注

關注

27文章

6195瀏覽量

106016 -

人工智能

+關注

關注

1796文章

47674瀏覽量

240294

原文標題:GPT-3記錄被打破!谷歌推出1.6萬億參數的人工智能語言模型

文章出處:【微信號:deeptechchina,微信公眾號:deeptechchina】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

谷歌推出1.6萬億參數的人工智能語言模型,打破GPT-3記錄

谷歌推出1.6萬億參數的人工智能語言模型,打破GPT-3記錄

評論