本周的重要論文包括來自谷歌大腦的研究團隊提出了一種舍棄卷積和自注意力且完全使用多層感知機(MLP)的視覺網絡架構,在 ImageNet 數據集上實現了媲美 CNN 和 ViT 的性能表現;清華大學圖形學實驗室 Jittor 團隊提出了一種新的注意機制,通過控制記憶單元的大小,External-attention 可以輕松實現線性的復雜度等研究。

論文 1:MLP-Mixer: An all-MLP Architecture for Vision

摘要:計算機視覺的發展史證明,規模更大的數據集加上更強的計算能力往往能夠促成范式轉變。雖然卷積神經網絡已經成為計算機視覺領域的標準,但最近一段時間,基于自注意力層的替代方法 Vision Transformer(ViT)實現新的 SOTA 性能。從技術上講,ViT 模型延續了長久以來去除模型中手工構建特征和歸納偏置的趨勢,并進一步依賴基于原始數據的學習。

近日,原 ViT 團隊提出了一種不使用卷積或自注意力的 MLP-Mixer 架構(簡稱 Mixer),這是一種頗具競爭力并且在概念和技術上都非常簡單的替代方案。Mixer 架構完全基于在空間位置或特征通道重復利用的多層感知機(MLP),并且僅依賴于基礎矩陣乘法運算、數據布局變換(如 reshape 和 transposition)和非線性層。

JAX/Flax 編寫的 MLP-Mixer 代碼。

推薦:CV 領域網絡架構的演變從 MLP 到 CNN 到 Transformer 再回到 MLP,真是太有意思了。

論文 2:Beyond Self-attention: External Attention using Two Linear Layers for Visual Tasks

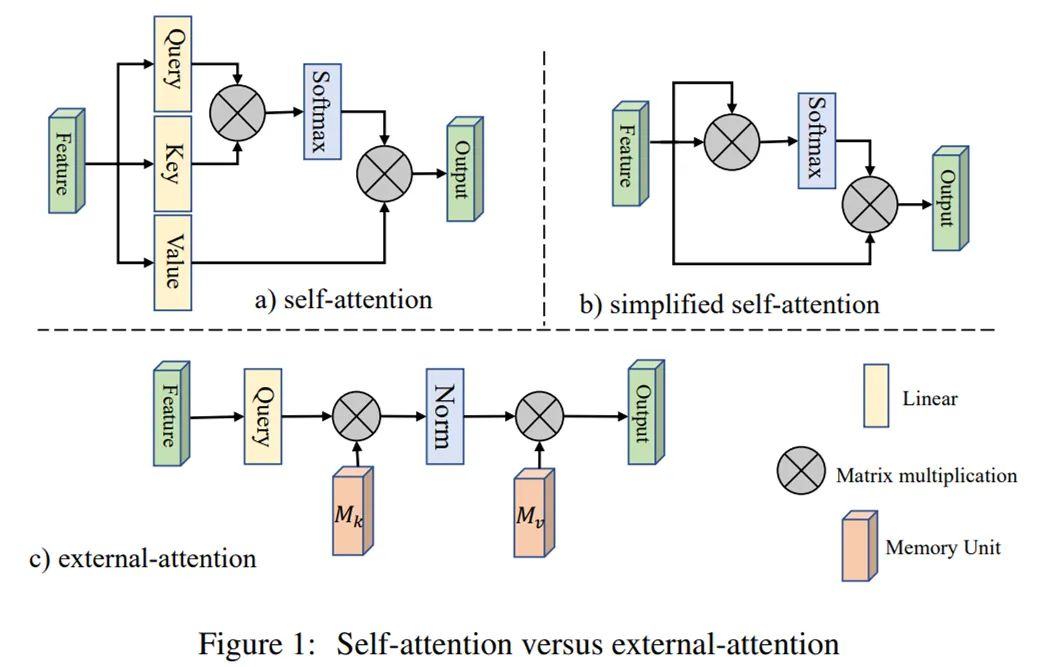

摘要:清華大學圖形學實驗室 Jittor 團隊提出了一種新的注意機制,稱之為「External Attention」,基于兩個外部的、小的、可學習的和共享的存儲器,只用兩個級聯的線性層和歸一化層就可以取代了現有流行的學習架構中的「Self-attention」,揭示了線性層和注意力機制之間的關系。自注意力機制一個明顯的缺陷在于計算量非常大,存在一定的計算冗余。通過控制記憶單元的大小,External-attention 可以輕松實現線性的復雜度。

Self Attention 和 External Attention 的區別。

推薦:External Attention 的部分計圖代碼已經在 Github 開源,后續將盡快開源全部計圖代碼。

論文 3:Learning Skeletal Articulations with Neural Blend Shapes

摘要:該論文由北京大學陳寶權教授研究團隊、北京電影學院未來影像高精尖創新中心、Google Research、特拉維夫大學以及蘇黎世聯邦理工學院合作,針對骨骼驅動的模型動畫的高質量自動化生成進行改進,提出了神經融合形狀技術。實驗證明,該方法顯著減少了已有方法中需要的人工干預,大大提升了生成動畫的質量。

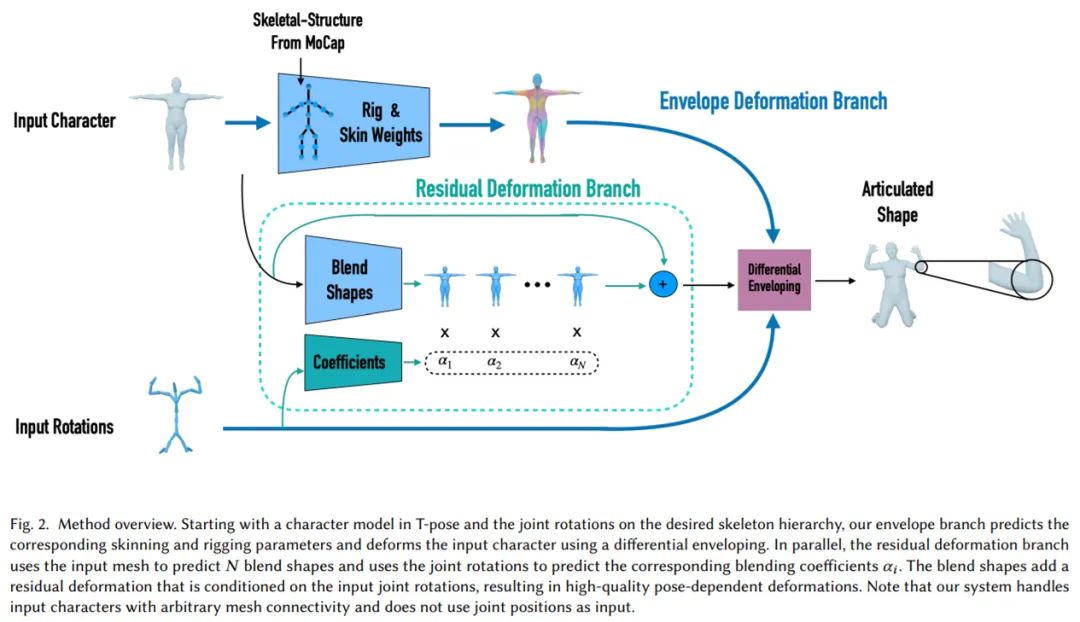

具體而言,為了簡化骨骼搭建和蒙皮權重綁定的過程、高效利用動作捕捉數據以及生成高質量的動畫,研究者開發了一套能生成具有指定結構的骨骼以及精準綁定權重的神經網絡。加以他們提出的神經融合形狀(neural blend shapes)技術,研究者實現了實時高質量三維人物模型動畫的端到端自動生成。

框架概覽。

推薦:該論文已被計算機圖形學頂級會議 SIGGRAPH 2021 接收。

論文 4:A Survey of Modern Deep Learning based Object Detection Models

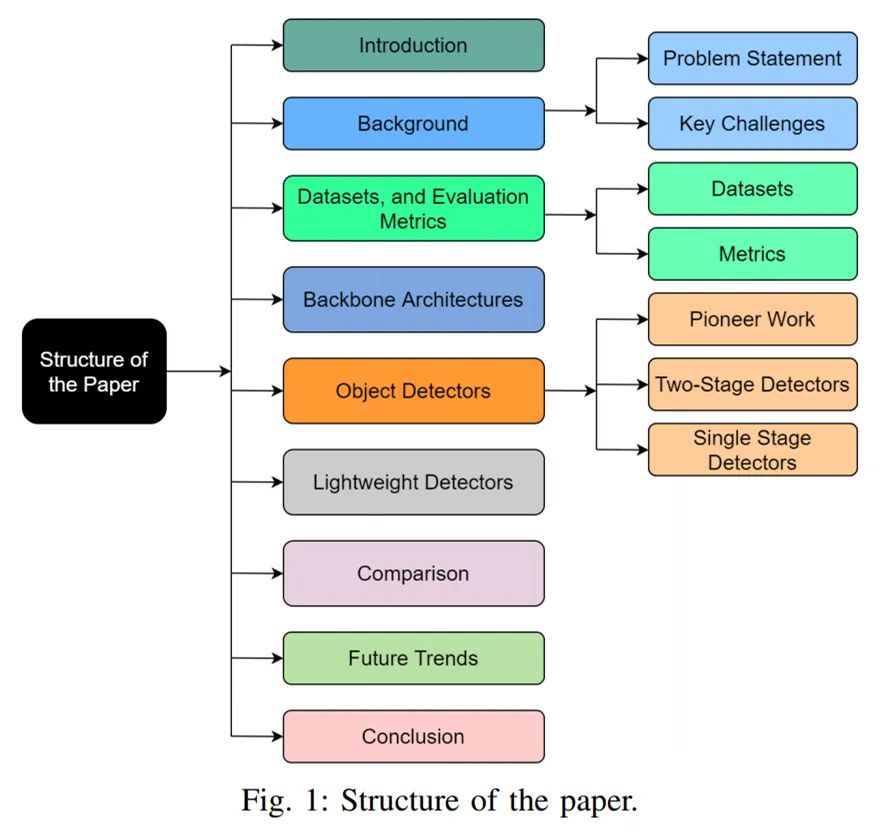

摘要:在本文中,來自阿斯隆理工學院的研究者概述了基于深度學習的目標檢測器的最新發展,提供了用于檢測的基準數據集和評估指標的簡要概述以及用于識別任務的主要主干架構。

文章結構。

推薦:基于現代深度學習的目標檢測模型綜述。

論文 5:Total Relighting: Learning to Relight Portraits for Background Replacement

摘要:在人像摳圖中,前景預測背景替換是至關重要的組成部分,此前也出現過各種效果不錯的摳圖方法,如商湯等提出的只需單張圖像、單個模型的方法 MODNet、華盛頓大學單塊 GPU 實現 4K 分辨率每秒 30 幀的 Background Matting 2.0 等。這些方法或多或少都有其局限性。

近日,來自谷歌的幾位研究者提出了一種全新的人像重照明(portrait relighting)和背景替換系統,該系統不僅保留了高頻邊界細節,并精確地合成了目標人像在新照明下的外觀,從而為任何所需場景生成逼真的合成圖像。該研究的亮點是通過前景蒙版(alpha matting)、重照明(relighting)和合成(compositing)進行前景估計。

推薦:該論文已被 SIGGRAPH 2021 會議接收。

論文 6:Graph Learning: A Survey

摘要:本文是對圖學習的最全面綜述,重點關注四類已有的圖學習方法,包括圖信號處理、矩陣分解、隨機游走和深度學習,回顧了采用這四類方法的主要模型和算法。此外,研究者探討了文本、圖像、科學、知識圖譜和組合優化等領域的圖學習應用。本文作者來自澳大利亞聯邦大學、大連理工、莫納什大學和亞利桑那州立大學。

推薦:最新圖機器學習論文綜述。

論文 7:Locate then Segment: A Strong Pipeline for Referring Image Segmentation

摘要:如何通過自然語言定位并分割出場景中的目標物體?比如給定一張圖片,語言指示 「分割出穿白色襯衫的人」。這個任務在學術界叫做指代性物體分割(Referring Image Segmentation)。目前指代性分割的工作通常著重于設計一種隱式的遞歸特征交互機制用于融合視覺 - 語言特征來直接生成最終的分割結果,而沒有顯式建模被指代物體的位置。

為了強調語言描述的指代作用,來自中科院自動化所、字節跳動的研究者將該任務解耦為先定位再分割的方案(LTS, Locate then Segment),它在直觀上也與人類的視覺感知機制相同。比如給定一句語言描述,人們通常首先會注意相應的目標圖像區域,然后根據對象的環境信息生成關于對象的精細分割結果。該方法雖然很簡單但效果較好。在三個流行的基準數據集上,該方法大幅度優于所有以前的方法。這個框架很有希望作為指代性分割的通用框架。

編輯:jq

-

gpu

+關注

關注

28文章

4775瀏覽量

129357 -

機器學習

+關注

關注

66文章

8438瀏覽量

133086 -

視覺感知

+關注

關注

0文章

44瀏覽量

3219

原文標題:7 Papers & Radios | CV架構回歸多層感知機;自動生成模型動畫

文章出處:【微信號:tyutcsplab,微信公眾號:智能感知與物聯網技術研究所】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

基于移動自回歸的時序擴散預測模型

大語言模型優化生成管理方法

多層感知器的基本原理

如何構建多層神經網絡

多層感知機是什么?它有哪些作用?

多層感知機與神經網絡的區別

不同類型神經網絡在回歸任務中的應用

人工神經網絡模型包含哪些層次

人工智能神經網絡模型有哪些

進一步解讀英偉達 Blackwell 架構、NVlink及GB200 超級芯片

【大語言模型:原理與工程實踐】大語言模型的基礎技術

如何提高自動駕駛汽車感知模型的訓練效率和GPU利用率

未來已來,多傳感器融合感知是自動駕駛破局的關鍵

生成式 AI 制作動畫:周期短、成本低!

解讀CV架構回歸多層感知機;自動生成模型動畫

解讀CV架構回歸多層感知機;自動生成模型動畫

評論