阿里云震旦異構計算加速平臺基于NVIDIA Tensor Core GPU,通過機器學習模型的自動優化技術,大幅提升了算子的執行效率,刷新了NVIDIA A100、A10、T4的GPU單卡性能。并基于8張NVIDIA A100 GPU和開放規則,以離線場景下每秒處理107.8萬張圖片的成績,打破MLPerf 1.0推理性能測試紀錄。

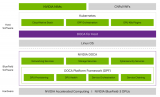

阿里云自研震旦異構計算加速平臺,適配GPU、ASIC等多種異構AI芯片,優化編譯代碼,深挖和釋放異構芯片算力,支持TensorFlow、Caffe、PAI等多種深度學習框架,可實現AI框架及算法的無縫遷移適配,支持云變端多場景快速部署,大幅提升AI應用開發效率。

在MLPerf推理性能測試結果1.0版中,震旦異構計算加速平臺,基于8卡NVIDIA A100 GPU配置上性能奪魁,在開放規則的離線場景下取得每秒處理107.8萬張圖片的成績。

首先在頂層算法模型上,使用基于自動機器學習(AutoML)的模型設計方式,這種方式可以獲得比人工設計更高效的模型。震旦基于MIT的先進的神經網絡架構搜索算法Once-For-All。

使用了基于強化學習的自研搜索算法獲得了高性能子網絡;之后通過INT8量化獲得硬件加速繼續提高性能,并在量化前進行深度重訓練,以保證量化后的精度能夠達到測試的精度要求。

IRB即反轉殘差塊(Inverted Residual Block),是用于網絡架構搜索的基本模塊。每個反轉殘差塊包括三層卷積算子,圖上反轉殘差塊的長度代表了該塊的輸出channel數量。

一般機器學習框架的算子實現專注于優化主流的神經網絡架構,而對于NAS的反轉殘差塊則效率不佳,震旦使用了基于自動調優的大規模算子融合技術,大幅提高了推理時算子對GPU的利用率,并且可根據不同的架構自動調優到最佳算子實現。

因此能快速發掘全新GPU架構的潛力,例如對于A100上通過MIG(多實例GPU)技術產生的具有不同計算資源的GPU實例,震旦算子優化技術可以通過自動調優來進一步提升計算資源利用率。

打破紀錄的背后,在硬件平臺上也得益于NVIDIA A100 GPU 強大的算力支持,近5倍于上一代的INT8性能使得超越百萬級性能成為可能。另外,NVIDIA GPU的通用性,即通過CUDA直接對硬件編程,使得用戶可以針對其特有的神經網絡模型進行定制優化,這讓震旦基于GPU的自動算子調優技術成為了現實。

最終獲得的調優算子可以更高效地利用A100最新的Tensor Core硬件指令以及更大的共享內存,從而交出了軟硬件協同優化的滿意答卷。

在MLPerf推理性能測試結果1.0版本圖像分類性能測試中,阿里云震旦異構計算加速平臺,基于NVIDIA A100 GPU平臺和開放規則,在離線場景下以每秒處理107.8萬張圖片的成績,打破了此前谷歌保持的絕對性能榜單的世界紀錄。這也是阿里在通用GPU平臺第一次取得100萬+這樣的成績。

此次阿里云震旦異構計算加速平臺基于NVIDIA通用GPU硬件,通過機器學習模型的自動優化技術,大幅提升了算子的執行效率,刷新了NVIDIA GPU單卡性能。無論是新推出的A100和A10,還是已面市3年的T4,都帶來了單卡性能的大幅提升。

編輯:jq

-

asic

+關注

關注

34文章

1206瀏覽量

120761 -

gpu

+關注

關注

28文章

4775瀏覽量

129357 -

AI芯片

+關注

關注

17文章

1906瀏覽量

35216

原文標題:NVIDIA A100 GPU助力阿里云打破MLPerf推理性能測試紀錄

文章出處:【微信號:murata-eetrend,微信公眾號:murata-eetrend】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

異構計算的概念、核心、優勢、挑戰及考慮因素

《CST Studio Suite 2024 GPU加速計算指南》

【一文看懂】什么是異構計算?

詳解Arm計算平臺的優勢

《算力芯片 高性能 CPUGPUNPU 微架構分析》第3篇閱讀心得:GPU革命:從圖形引擎到AI加速器的蛻變

NVIDIA加速計算如何推動醫療健康

打造異構計算新標桿!國數集聯發布首款CXL混合資源池參考設計

AvaotaA1全志T527開發板AMP異構計算簡介

NVIDIA 通過 CUDA-Q 平臺為全球各地的量子計算中心提供加速

基于NVIDIA Megatron Core的MOE LLM實現和訓練優化

阿里云震旦異構計算加速平臺基于NVIDIA Tensor Core GPU

阿里云震旦異構計算加速平臺基于NVIDIA Tensor Core GPU

評論