AMD祭出殺手锏,首個百億億級GPU

在不久前結束的 “加速數據中心”發布會上,AMD正式公開了下一代服務器CPU Milan-X和GPU加速卡Instinct MI200。這兩大產品系列不僅面向數據中心,也將面向一系列HPC和超算應用,把通用計算和AI性能推向極致。Instinct MI200作為GPU加速卡,更是成為超級計算機百億億級(Exascale)的算力的基本構成單元。

在市場合作上,AMD更是開始了新一輪的攻城略地,前不久剛和騰訊聯合發布了星星海服務器產品后,如今Azure等一眾公有云廠商也開始部署基于Milan-X的服務器,甚至將剛改名為Meta的Facebook也被拉攏至AMD陣營,宣布將在其數據中心部署AMD的服務器產品。

Milan-X:6nm的大緩存怪獸

繼上一代Milan處理器推出后不到一年,AMD就發布了該芯片的6nm改進版Milan-X。今年上半年通過融合Chiplet和Die堆疊兩大技術,在Ryzen桌面處理器上做了3D Chiplet架構的演示。如今第三代Epyc處理器Milan-X,將成為首個使用該技術的服務器產品。通過在Chiplet上堆疊緩存,Milan-X的L3緩存是Milan的三倍,達到了可怕的768MB。

MilanX / AMD

與英特爾一樣,AMD在正式發售前并沒有公布Milan-X的具體性能細節,而是通過合作伙伴的測試來展示了Milan-X在EDA和公有云應用中表現。在新思的VCS功能驗證中,Milan-X在1小時內完成了40.6項任務,而同樣核心數的Milan僅完成了24.4項。微軟在基于Milan-X的Azure服務器中進行了早期測試,無論是在航天模擬,還是在汽車碰撞測試建模中,Milan-X都做到了50%以上的性能提升。

除此之外,AMD CEO蘇資豐博士還透露了下一代5nm Epyc處理器Genoa的情報。基于Zen 4架構的Genoa將具備2倍的晶體管密度和2倍的能效,性能可以達到上一代的1.25倍以上。Genoa最高支持96個Zen 4核心,同時也將加入一系列新標準的支持,比如DDR5、PCIe 5.0和CXL。AMD還將推出基于5nm的Zen 4C核心的處理器Bergamo,專門針對要求多核多線程的云原生計算,最高核心數將達到128核,晚于Genoa發布。

Genoa計劃在2022年量產和發布,屆時很可能就是英特爾的Sapphire Rapids和AMD的Genoa在通用計算領域爭雄了。

Instinct MI200:GPU終于迎來MCM時代了?

除了Milan-X之外,發布會的最大亮點其實是全球首個MCM GPU,Instinct MI200。同樣基于臺積電的6nm工藝,Instinct MI200系列單芯片的晶體管數目達到580億,最高集成了220個計算單元。作為首個采用AMD CDNA2架構的服務器GPU,Instinct MI200的目標很明確,那就是將計算能力推向ExaScale級。

在CDN2架構和第二代HPC&AI專用矩陣核心的支持下,Instinct MI200實現了遠超競品的性能表現。數據對比環節,AMD選擇拿Nvidia目前最強的A100加速卡開刀。MI250X的FP64向量計算能力達到47.9TF,FP64矩陣計算能力達到95.7TF,均為A100的4.9倍。而在AI領域常用的FP16和BF16矩陣計算中,MI250X的算力也達到了383TF,是A100的1.2倍。即便兩者都用上了HBM2E,MI200的內存帶寬也達到了3.2TB/s,遠超A100的2TB/s。不過MI250X的功耗確實要高出不少,峰值狀態下的功耗可以達到560W,而A100的峰值功耗為300W。

與英特爾這種IDM廠商不同,AMD在封裝上基本吃透了與臺積電合作帶來的技術紅利,尤其是臺積電的3D Fabric封裝技術集合,而Instinct MI200則是這些技術的集大成之作。作為首個采用多Die設計的GPU,Instinct MI200選用了兩個SoC+8個HBM2E的方案,AMD在發布會上宣稱這一設計的實現要歸功于2.5D的Elevated Fanout Bridge(EFB)架構。

從圖解上來看,AMD的EFB與臺積電的InFO-L 2.5D封裝技術可以說是從一個模子里刻出來的。在專門用于HBM集成的方案,目前可以做到這種規模的異構似乎也只有臺積電的InFO-L和CoWoS-L,利用LSI(本地硅互聯)芯片,為SoC到SoC與SoC到HBM提供高布線密度的互聯。

其實英特爾也有類似的2.5D封裝方案EMIB,只不過該方案是在基板內放入一個硅橋die。而反觀AMD的EFB和臺積電的LSI方案則是將其至于基板的模具中,模具內分布著一系列銅柱。相較之下,EMIB雖然可以做到更低的寄生電感,卻也對于基板的加工提出了很高的要求,這也是為何只有英特爾這個基板大廠才使用EMIB的原因之一。不過隨著IDM 2..0模式的展開,英特爾也將公開提供自己的制程、IP和封裝技術,未來也許會有其他廠商的芯片開始用上EMIB。但目前來看,雖然增加了高度控制的挑戰,但為了使用標準的基板降低成本,EFB和LSI明顯是最優解。

在外觀尺寸上,AMD選擇了OAM和PCIe兩種形式。OAM為開放計算項目(OCP)定下的通用加速器模組標準,對于想要規模化部署GPU或其他加速器來說,OAM可以提供更大的帶寬。作為Facebook和微軟共同推行的公開標準,OAM已經在服務器領域有了不小的規模,不僅是英特爾、AMD和英偉達這些半導體廠商,浪潮、聯想、百度和阿里巴巴等其他服務器與公有云廠商也開始支持這一標準。

目前OAM的MI250和MI250X已經進入可交付階段,從今年第三季度起,AMD就已經在為美國能源部的橡樹嶺國家實驗室持續交付MI250X GPU了,用于組成美國首個ExaScale級別的超級計算機Frontier。除了OAM模組外,AMD也將在不久提供PCIe版本的MI210,用于非密集運算的場景。

結語

隨著英特爾、三星和臺積電在2.5D/3D封裝技術上的逐漸成熟,服務器芯片將成為受益最大的產品,未來2+8甚至3+8的MCM GPU可能更加常見。英偉達、AMD與英特爾三家在服務器/數據中心市場上的動向,也側面體現了IDM與Fabless廠商之間在技術選擇上的差異。英特爾如果不能盡快在制程和封裝上超越臺積電這樣的晶圓代工廠,在服務器市場的優勢可能會越來越小。

在不久前結束的 “加速數據中心”發布會上,AMD正式公開了下一代服務器CPU Milan-X和GPU加速卡Instinct MI200。這兩大產品系列不僅面向數據中心,也將面向一系列HPC和超算應用,把通用計算和AI性能推向極致。Instinct MI200作為GPU加速卡,更是成為超級計算機百億億級(Exascale)的算力的基本構成單元。

在市場合作上,AMD更是開始了新一輪的攻城略地,前不久剛和騰訊聯合發布了星星海服務器產品后,如今Azure等一眾公有云廠商也開始部署基于Milan-X的服務器,甚至將剛改名為Meta的Facebook也被拉攏至AMD陣營,宣布將在其數據中心部署AMD的服務器產品。

Milan-X:6nm的大緩存怪獸

繼上一代Milan處理器推出后不到一年,AMD就發布了該芯片的6nm改進版Milan-X。今年上半年通過融合Chiplet和Die堆疊兩大技術,在Ryzen桌面處理器上做了3D Chiplet架構的演示。如今第三代Epyc處理器Milan-X,將成為首個使用該技術的服務器產品。通過在Chiplet上堆疊緩存,Milan-X的L3緩存是Milan的三倍,達到了可怕的768MB。

MilanX / AMD

與英特爾一樣,AMD在正式發售前并沒有公布Milan-X的具體性能細節,而是通過合作伙伴的測試來展示了Milan-X在EDA和公有云應用中表現。在新思的VCS功能驗證中,Milan-X在1小時內完成了40.6項任務,而同樣核心數的Milan僅完成了24.4項。微軟在基于Milan-X的Azure服務器中進行了早期測試,無論是在航天模擬,還是在汽車碰撞測試建模中,Milan-X都做到了50%以上的性能提升。

除此之外,AMD CEO蘇資豐博士還透露了下一代5nm Epyc處理器Genoa的情報。基于Zen 4架構的Genoa將具備2倍的晶體管密度和2倍的能效,性能可以達到上一代的1.25倍以上。Genoa最高支持96個Zen 4核心,同時也將加入一系列新標準的支持,比如DDR5、PCIe 5.0和CXL。AMD還將推出基于5nm的Zen 4C核心的處理器Bergamo,專門針對要求多核多線程的云原生計算,最高核心數將達到128核,晚于Genoa發布。

Genoa計劃在2022年量產和發布,屆時很可能就是英特爾的Sapphire Rapids和AMD的Genoa在通用計算領域爭雄了。

Instinct MI200:GPU終于迎來MCM時代了?

除了Milan-X之外,發布會的最大亮點其實是全球首個MCM GPU,Instinct MI200。同樣基于臺積電的6nm工藝,Instinct MI200系列單芯片的晶體管數目達到580億,最高集成了220個計算單元。作為首個采用AMD CDNA2架構的服務器GPU,Instinct MI200的目標很明確,那就是將計算能力推向ExaScale級。

在CDN2架構和第二代HPC&AI專用矩陣核心的支持下,Instinct MI200實現了遠超競品的性能表現。數據對比環節,AMD選擇拿Nvidia目前最強的A100加速卡開刀。MI250X的FP64向量計算能力達到47.9TF,FP64矩陣計算能力達到95.7TF,均為A100的4.9倍。而在AI領域常用的FP16和BF16矩陣計算中,MI250X的算力也達到了383TF,是A100的1.2倍。即便兩者都用上了HBM2E,MI200的內存帶寬也達到了3.2TB/s,遠超A100的2TB/s。不過MI250X的功耗確實要高出不少,峰值狀態下的功耗可以達到560W,而A100的峰值功耗為300W。

與英特爾這種IDM廠商不同,AMD在封裝上基本吃透了與臺積電合作帶來的技術紅利,尤其是臺積電的3D Fabric封裝技術集合,而Instinct MI200則是這些技術的集大成之作。作為首個采用多Die設計的GPU,Instinct MI200選用了兩個SoC+8個HBM2E的方案,AMD在發布會上宣稱這一設計的實現要歸功于2.5D的Elevated Fanout Bridge(EFB)架構。

從圖解上來看,AMD的EFB與臺積電的InFO-L 2.5D封裝技術可以說是從一個模子里刻出來的。在專門用于HBM集成的方案,目前可以做到這種規模的異構似乎也只有臺積電的InFO-L和CoWoS-L,利用LSI(本地硅互聯)芯片,為SoC到SoC與SoC到HBM提供高布線密度的互聯。

其實英特爾也有類似的2.5D封裝方案EMIB,只不過該方案是在基板內放入一個硅橋die。而反觀AMD的EFB和臺積電的LSI方案則是將其至于基板的模具中,模具內分布著一系列銅柱。相較之下,EMIB雖然可以做到更低的寄生電感,卻也對于基板的加工提出了很高的要求,這也是為何只有英特爾這個基板大廠才使用EMIB的原因之一。不過隨著IDM 2..0模式的展開,英特爾也將公開提供自己的制程、IP和封裝技術,未來也許會有其他廠商的芯片開始用上EMIB。但目前來看,雖然增加了高度控制的挑戰,但為了使用標準的基板降低成本,EFB和LSI明顯是最優解。

在外觀尺寸上,AMD選擇了OAM和PCIe兩種形式。OAM為開放計算項目(OCP)定下的通用加速器模組標準,對于想要規模化部署GPU或其他加速器來說,OAM可以提供更大的帶寬。作為Facebook和微軟共同推行的公開標準,OAM已經在服務器領域有了不小的規模,不僅是英特爾、AMD和英偉達這些半導體廠商,浪潮、聯想、百度和阿里巴巴等其他服務器與公有云廠商也開始支持這一標準。

目前OAM的MI250和MI250X已經進入可交付階段,從今年第三季度起,AMD就已經在為美國能源部的橡樹嶺國家實驗室持續交付MI250X GPU了,用于組成美國首個ExaScale級別的超級計算機Frontier。除了OAM模組外,AMD也將在不久提供PCIe版本的MI210,用于非密集運算的場景。

結語

隨著英特爾、三星和臺積電在2.5D/3D封裝技術上的逐漸成熟,服務器芯片將成為受益最大的產品,未來2+8甚至3+8的MCM GPU可能更加常見。英偉達、AMD與英特爾三家在服務器/數據中心市場上的動向,也側面體現了IDM與Fabless廠商之間在技術選擇上的差異。英特爾如果不能盡快在制程和封裝上超越臺積電這樣的晶圓代工廠,在服務器市場的優勢可能會越來越小。

聲明:本文內容及配圖由入駐作者撰寫或者入駐合作網站授權轉載。文章觀點僅代表作者本人,不代表電子發燒友網立場。文章及其配圖僅供工程師學習之用,如有內容侵權或者其他違規問題,請聯系本站處理。

舉報投訴

-

amd

+關注

關注

25文章

5496瀏覽量

134637 -

cpu

+關注

關注

68文章

10902瀏覽量

213013 -

gpu

+關注

關注

28文章

4774瀏覽量

129353

發布評論請先 登錄

相關推薦

AMD集成DeepSeek-V3模型至Instinct MI300X GPU

AMD近日宣布了一項重要的技術進展,即將全新的DeepSeek-V3模型成功集成到其旗艦級GPU產品——Instinct MI300X上。這一舉措標志著AMD在人工智能推理領域邁出了堅

《CST Studio Suite 2024 GPU加速計算指南》

的各個方面,包括硬件支持、操作系統支持、許可證、GPU計算的啟用、NVIDIA和AMD GPU的詳細信息以及相關的使用指南和故障排除等內容。

1. 硬件支持

- NVIDIA GPU

發表于 12-16 14:25

基站和雷達知識介紹

前文說到5G-A相比5G初期版本最大的殺手锏是新增的通感一體(ISAC,integrated sensing and communication)能力。

之所以被稱為殺手锏,是因為通感一體第一次在通信基站上,實現了非通信的能力——感知,通感一體的感字即來源于此。

AMD發布10億參數開源AI模型OLMo

AMD公司近日宣布了一項重大進展,推出了首個完全開放的10億參數語言模型系列——AMD OLMo。這一舉措為開發者和研究人員提供了強大的AI研究工具,有助于推動AI技術的進一步發展。

軟銀升級人工智能計算平臺,安裝4000顆英偉達Hopper GPU

達Ampere GPU。通過新增的4000顆Hopper GPU,該平臺的總計算性能已躍升至每秒約4.7百億億次。

AMD與NVIDIA GPU優缺點

在圖形處理單元(GPU)市場,AMD和NVIDIA是兩大主要的競爭者,它們各自推出的產品在性能、功耗、價格等方面都有著不同的特點和優勢。 一、性能 GPU的性能是用戶最關心的指標之一。在高端市場

三星首度引入AMD MI300X,緩解AI GPU短缺

三星電子近日斥資約270億韓元(約合1.42億元人民幣),購買了AMD Instinct MI300X加速器。這一舉措標志著三星電子首次引入非英偉達品牌的AI GPU,以應對企業內部算

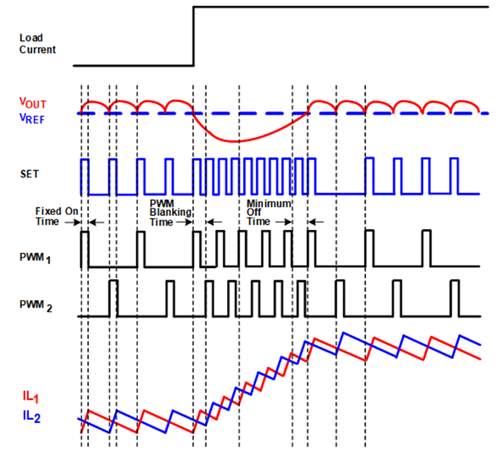

下一代GPU的預測瞬態仿真分析

圖形處理單元(GPU)不斷迭代更新,其中的晶體管數目也不斷增加以提高處理器性能。如今這個數目已達到數百億的級別,與此同時,功率需求也相應呈指數級增長,這讓滿足瞬態響應規范變得極為困難。

英國公司實現英偉達CUDA軟件在AMD GPU上的無縫運行

7月18日最新資訊,英國創新科技企業Spectral Compute震撼發布了其革命性GPGPU編程工具包——“SCALE”,該工具包實現了英偉達CUDA軟件在AMD GPU上的無縫遷移與運行,標志著在GPU計算領域,NVIDI

AMD雄心勃勃:計劃構建百萬級GPU超級計算機集群

在全球科技競賽的舞臺上,AMD近日宣布了一項令人矚目的計劃——打造一個包含多達120萬顆GPU的超級計算機集群。這一宏大的舉措立即引發了業界的廣泛關注,許多人認為,這是AMD為了與英偉達等競爭對手一較高下而邁出的重要一步。

AMD發布ROCm更新,新增RX 8000系列GPU的Navi 44命名

首款Navi 48芯片以Gfx1201之名現身,而Navi 44則以Gfx1200之名亮相。這兩款GPU的出現,至少暗示了AMD正在逐步完善RDNA 4 GPU的研發工作。

AMD計劃在臺投資設立研發中心

近日證實,繼英偉達在臺設立亞洲首個AI研發中心后,全球知名的半導體公司超威半導體(AMD)也將緊隨其后,在臺灣投資設立研發中心。據悉,AMD計劃投資高達50億元新臺幣,這一決策無疑將為

英偉達、AMD、英特爾GPU產品及優勢匯總

主導地位,其銷售額預計將達到400億美元,遠超過競爭對手AMD和英特爾。那么這三家公司都有哪些GPU產品,各自的產品有何優勢呢? ? 英偉達????????????????????????????????????????????

AMD市值首次突破3000億美元

AMD的市值首次突破了3000億美元,這一里程碑式的成就得益于該公司股價的大幅上漲。上周四,AMD的股價上漲了9.1%,使得其市值首次突破了3000億美元。相較于去年10月的低點,

AMD收盤市值站上3100億美元

AMD收盤市值站上3100億美元 受益人工智能的熱炒,相關的科技股股價大幅上漲,周四晚間美股AMD股價大幅上漲9%,AMD收盤時市值站上3100億

AMD祭出殺手锏,首個百億億級GPU

AMD祭出殺手锏,首個百億億級GPU

評論