關于Cache的其它內容

上面我們所描述情況,在訪問cache前,已經將虛擬地址轉換成了物理地址,其實,不一定,也可是是虛擬地址直接訪問cache,倒底是使用物理地址還是虛擬地址,這就是翻譯方式的選擇。

(1)虛緩存

一個簡單的方案就是緩存的標簽和索引均使用虛擬地址。這種緩存稱為虛緩存(virtualcache)。這種緩存的優點是僅在緩存失效時才需要進行頁面翻譯。由于緩存命中率很高,需要翻譯的次數也相對較少。

但是這種技術也存在嚴重的問題。

第一,引入虛擬地址的一個重要原因是在軟件(操作系統)級進行頁面保護,以防止進程間相互侵犯地址空間。由于這種保護是通過頁表和翻譯旁視緩沖器(TLB)中的保護位(protectionbit)實現的,直接使用虛擬地址來訪問數據等于繞過了頁面保護。一個解決辦法是在緩存失效時查看TLB對應表項的保護位以確定是否可以加載缺失的數據。

第二,由于不同進程使用相同的虛擬地址空間,在切換進程后會出現整個緩存都不再對應新進程的有效數據。如果前后兩個進程使用了相同的地址區間,就可能會造成緩存命中,確訪問了錯誤的地址,導致程序錯誤。有兩個解決辦法:其一,進程切換后清空緩存。代價過高。其二,使用進程標識符(PID)作為緩存標簽的一部分,以區分不同進程的地址空間。

第三,別名問題(Alias)。由于操作系統可能允許頁面別名,即多個虛擬頁面映射至同一物理頁面,使用虛擬地址做標簽將可能導致一份數據在緩存中出現多份拷貝的情形。這種情況下如果對其中一份拷貝作出修改,而其他拷貝沒有同步更新,則數據喪失整合性,導致程序錯誤。有兩個解決辦法:其一,硬件級反別名。當緩存載入目標數據時,確認緩存內沒有緩存塊的標簽是此地址的別名。如果有則不載入,而直接返回別名緩存塊內的數據。其二,頁面著色(PageColoring)。這種技術是由操作系統對頁面別名作出限制,使指向同一頁面的別名頁面具有相同的低端地址。這樣,只要緩存的索引范圍足夠小,就能保證在緩存中決不會出現來自不同別名頁面的數據。

第四,輸入輸出問題。由于輸入輸出系統通常只使用物理地址,虛緩存必須引入一種逆映射技術來實現虛擬地址到物理地址的轉換。

(2)實緩存

實緩存(physicalcache)完全使用物理地址做緩存塊的標簽和索引,故地址翻譯必須在訪問緩存之前進行。這種傳統方法所以可行的一個重要原因是TLB的訪問周期非常短(因為本質上TLB也是一個緩存),因而可以被納入流水線。

但是,由于地址翻譯發生在緩存訪問之前,會比虛緩存更加頻繁地造成TLB。(相比之下,虛緩存僅在本身失效的前提下才會訪問TLB,進而有可能引發TLB失效)實緩存在運行中存在這樣一種可能:首先觸發了一個TLB失效,然后從頁表中更換TLB表項(假定頁表中能找到)。然后再重新訪問TLB,翻譯地址,最后發現數據不在緩存中。

(3)虛索引、實標簽緩存

一個折中方案是同時使用虛索引和實標簽(virtuallyindexed, physically tagged)。這種緩存利用了頁面技術的一個特征,即虛擬地址和物理地址享有相同的頁內偏移值(pageoffset)。這樣,可以使用頁內偏移作為緩存索引,同時使用物理頁面號作為標簽。這種混合方式的好處在于,其既能有效消除諸如別名引用等純虛緩存的固有問題,又可以通過對TLB和緩存的并行訪問來縮短流水線延遲。

這種技術的一個缺點是,在使用直接匹配緩存的前提下,緩存大小不能超過頁面大小,否則頁面偏移范圍就不足以覆蓋緩存索引范圍。這個弊端可以通過提高組相聯路數來改善。

(4)多級cache

介于處理器和內存二者之間的緩存有兩個天然沖突的性能指標:速度和容量。如果只向處理器看齊而追求速度,則必然要靠減少容量來換取訪問時間;如果只向內存看齊而追求容量,則必然以增加處理器的訪問時間為犧牲。這種矛盾促使人們考慮使用多級緩存。

在一個兩級緩存體系中,一級緩存靠近處理器一側,二級緩存靠近內存一側。當一級緩存發生失效時,它向二級緩存發出請求。如果請求在二級緩存上命中,則數據交還給一級緩存;如失效,二級緩存進一步向內存發出請求。對于三級緩存可依此類推。

通常,更接近內存的緩存有著更大容量,但是速度也更慢。

值得注意的是,無論如何,低級緩存的局部命中率總是低于高級緩存。這是因為數據的時空局部性在一級緩存上基本上已經利用殆盡。

對于各級cache,雖然功能類似,但不同級別的緩存在設計和實現上也有不同之處。

一般而言,在存儲體系結構中低級存儲總是包含高級存儲的全部數據,但對于多級緩存則未必。相反地,存在一種多級排他性(Multilevelexclusion)的設計。此種設計意指高級緩存中的內容和低級緩存的內容完全不相交。這樣,如果一個高級緩存請求失效,并在次級緩存中命中的話,次級緩存會將命中數據和高級緩存中的一項進行交換,以保證排他性。

多級排他性的好處是在存儲預算有限的前提下可以讓低級緩存更多地存儲數據。否則低級緩存的大量空間將不得不用于覆蓋高級緩存中的數據,這無益于提高低級緩存的命中率。

當然,也可以如內存對緩存般,使用多級包容性(Multilevelinclusion)設計。這種設計的優點是比較容易方便查看緩存和內存間的數據一致性,因為僅檢查最低一級緩存即可。對于多級排他性緩存這種檢查必須在各級上分別進行。這種設計的一個主要缺點是,一旦低級緩存由于失效而被更新,就必須相應更新在高級緩存上所有對應的數據。因此,通常令各級緩存的緩存塊大小一致,從而減少低級對高級的不必要更新。

此外,各級緩存的寫策略也不相同。對于一個兩級緩存系統,一級緩存可能會使用寫通來簡化實現,而二級緩存使用寫回確保數據一致性。orpsoc正是這樣設計的。

(5)關于cache的優化

優化緩存可從三個方面入手:減少命中時間,降低失效率,減輕失效代價。此外,增加緩存訪問帶寬也能有效較低AMAT(平均內存訪問時間,AverageMemory Access Time)。

理論上,完全使用虛擬地址可以獲得更快的緩存訪問速度,因為這樣僅在緩存失效時才會進行地址翻譯。但是,如前所述,這種純虛地址緩存由于繞開了操作系統對進程訪問地址的軟件控制,會存在不少問題。

為了能接近虛緩存的訪問速度,又能避開虛緩存帶來的種種問題,引入了所謂虛索引、實標簽緩存(virtuallyindexed, physically tagged)。這種結構的緩存可以令地址翻譯和緩存查詢并發進行,大大加快了緩存的訪問速度。

由于電路延遲很大程度上取決于存儲芯片的大小,所以可考慮使用較小容量的緩存以保證最短的訪問周期。這么做的另一個好處是,由于一級緩存足夠小,可以把二級緩存的全部或部分也集成到CPU芯片上,從而減少了二級緩存的命中時間。

AMD從K6到Opteron連續三代CPU的一級緩存容量都沒有任何增長(均為64KB)正是基于這個原因。

另一方面,考慮使用簡單的緩存,如直接匹配緩存,也可較組相聯緩存減少命中時間。

路預測:

所謂路預測(Wayprediction),是指在組相聯緩存中,跟蹤同一組內不同緩存塊的使用情況,然后在訪問到來時,不經比較直接返回預測的緩存塊。當然,標簽比較仍然會進行,并且如果發現比較結果不同于預測結果,就會重新送出正確的緩存塊。也就是說,錯誤預測會造成一個緩存塊長度的延遲。

模擬表明路預測的準確率超過85%[6]。這種技術非常適合于投機執行(SpeculativeExecution)處理器,因為這種處理器有完善的機制來保證在投機失敗之后取消已經派發的指令。

追蹤緩存:

與一般的指令緩存存儲靜態連續地址不同,追蹤緩存(TraceCache)存儲的是基于執行歷史的動態地址序列。這實際上是把分支預測的結果用在了緩存上。由于只存儲沿某一特定分支路徑才會遇到的指令,這種緩存可比傳統緩存更節省空間。

追蹤緩存的缺點是實現復雜,因為必須設法連續存儲的數據并不會按照2的冪次字長對齊。此外,對于不同執行路徑要分開存儲。如果這些執行路徑中存在相同地址的指令,這些指令就只好被分別存到兩個地方。這反而造成了低效的空間利用。

Intel的Pentium4處理器使用了這一復雜技術。值得一提的是,Pentium4追蹤緩存存儲的不是從內存抓取的原始指令,而是已經過解碼的微操作,從而進一步節省掉了指令解碼上要花的時間。

增加訪問帶寬。

緩存流水線化:

將一級緩存并入流水線是一般做法。這種做法可行性在于一級緩存的訪問時間通常都極短,可能只有一到數個CPU周期。此外,由于TLB也是一種高速緩存硬件,所以也可以納入流水線。

非阻塞緩存:

一般而言,當緩存發生失效時,處理器必須停滯(stall),等待緩存將數據從次級存儲中讀取出來。

對于跨序執行(Out-of-orderExecution)處理器,由于多條指令在不同處理單元中并發執行,某一條指令引發的緩存失效應該只造成其所在處理單元的停滯,而不影響其他處理單元和指令派發單元繼續流水。因此,有必要設計這樣一種緩存,使之能夠在處理緩存失效的同時,繼續接受來自處理器的訪問請求。這稱為非阻塞緩存(Non-blockingcache)。

降低失效率。

使用更大的數據塊:

使用大數據塊有助于利用空間局部性降低失效率,但其代價是更高的失效代價。這是因為,一旦失效,就必須把整個數據塊都重新填滿。

使用更大的緩存:

單純增大緩存的容量也是降低失效率的一個辦法。不過顯然這也增大了命中時間。

高組相聯緩存:

使用多路組相聯可以減少沖突失效。但其后果是緩存電路邏輯復雜化,故增大了命中時間。

編譯器優化:

存在多種編譯器優化技術來間接影響緩存的使用模式。

責任編輯:haq

-

容量

+關注

關注

0文章

117瀏覽量

21270 -

軟件

+關注

關注

69文章

5009瀏覽量

88066 -

Cache

+關注

關注

0文章

129瀏覽量

28430

原文標題:甄建勇:五分鐘搞定Cache(下)

文章出處:【微信號:LinuxDev,微信公眾號:Linux閱碼場】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

什么是緩存(Cache)及其作用

Cache和內存有什么區別

解析Arm Neoverse N2 PMU事件L2D_CACHE_WR

2k1000LA中關于IODMA請求的描述

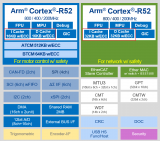

Cortex R52內核Cache的具體操作(2)

Cortex R52內核Cache的相關概念(1)

CortexR52內核Cache的具體操作

態勢數據有哪些格式和內容呢

為什么HAL庫在操作Flash erase的時候,需要把I-Cache和D-Cache關閉呢?

STM32F429使用外部SPI flash,只要執行Bitmap::cache(id)就進入硬件錯誤怎么解決?

STM32h7開啟Cache后,串口發送DMA會導致中斷觸發如何解決?

請問STM32MP13X的MMU和Cache如何使能?

關于PSDR和DSPR遇到的兩個問題求解

淺談modbus在其它類型網絡上傳輸

關于Cache的其它內容

關于Cache的其它內容

評論