數據是模型可解釋性的核心。可解釋人工智能( XAI )是一個快速發展的領域,旨在深入了解人工智能算法的復雜決策過程。

在人工智能對個人生活有重大影響的領域,如信用風險評分,管理者和消費者都有權要求深入了解這些決策。領先的金融機構已經在利用 XAI 驗證其模型。同樣,監管機構也要求深入了解金融機構的算法環境。但在實踐中如何做到這一點呢?

潘多拉的封閉盒子

人工智能越先進,對可解釋性來說,數據就越重要。

現代的 ML 算法有集成方法和深度學習,即使沒有數百萬個模型參數,也會產生數千個。當應用于實際數據時,如果不看到它們的實際作用,就不可能掌握它們。

甚至在培訓數據敏感的情況下,廣泛訪問數據的必要性也是顯而易見的。用于信用評分和保險定價的金融和醫療數據是人工智能中使用最頻繁、但也是最敏感的數據類型。

這是一個相互矛盾的難題:你想要數據得到保護,你想要一個透明的決策。

可解釋的 AI 需要數據

那么,這些算法如何變得透明呢?你如何判斷機器做出的模型決策?考慮到它們的復雜性,披露數學模型、實現或完整的訓練數據并不能達到目的。

相反,您必須通過觀察各種實際案例中的決策來探索系統的行為,并探索其對修改的敏感性。這些基于示例的假設探索有助于我們理解是什么驅動了模型的決策。

這種簡單而強大的概念,即在給定輸入數據變化的情況下,系統地探索模型輸出的變化,也稱為 local interpretability ,可以在域和 model-agnostic 按比例 中執行。因此,同樣的原則可以應用于幫助解釋信用評分系統、銷售需求預測、欺詐檢測系統、文本分類器、推薦系統等。

然而,像 SHAP 這樣的局部可解釋性方法不僅需要訪問模型,還需要訪問大量具有代表性和相關的數據樣本。

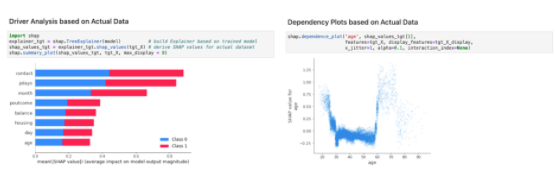

圖 1 顯示了一個在模型上進行的基本演示,該演示預測了客戶對金融行業內營銷活動的反應。查看相應的 Python 調用可以發現需要經過訓練的模型,以及執行這些類型分析的代表性數據集。然而,如果該數據實際上是敏感的,并且無法被 AI 模型驗證器 訪問,該怎么辦?

圖 1 :。使用實際數據通過 SHAP 解釋模型的示例

用于跨團隊擴展 XAI 的合成數據

在人工智能采用的早期,通常是同一組工程師開發模型并對其進行驗證。在這兩種情況下,他們都使用了真實的生產數據。

考慮到算法對個人的現實影響,現在越來越多的人認識到,獨立小組應該檢查和評估模型及其影響。理想情況下,這些人會從工程和非工程背景中提出不同的觀點。

與外部審計師和認證機構簽訂合同,以建立額外的信心,確保算法是公平、公正和無歧視的。然而,隱私問題和現代數據保護法規(如 GDPR )限制了對代表性驗證數據的訪問。這嚴重阻礙了模型驗證的廣泛開展。

幸運的是,模型驗證可以使用高質量的人工智能生成的 synthetic data 來執行,它可以作為敏感數據的高度準確、匿名的替代品。例如, AI 的 綜合數據平臺 主要使組織能夠以完全自助、自動化的方式生成合成數據集。

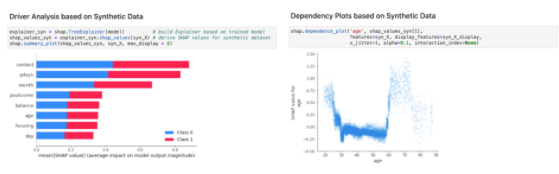

圖 2 顯示了使用合成數據對模型執行的 XAI 分析。比較圖 1 和圖 2 時,結果幾乎沒有任何明顯的差異。同樣的見解和檢查也可以通過利用 AI 的隱私安全合成數據來實現,這最終使真正的協作能夠在規模和連續的基礎上執行 XAI 。

圖 2 :。使用合成數據通過 SHAP 解釋模型的示例

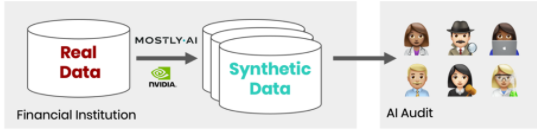

圖 3 顯示了跨團隊擴展模型驗證的過程。組織在其受控的計算環境中運行最先進的合成數據解決方案。它不斷生成其數據資產的合成副本,可以與內部和外部 AI 驗證器的不同團隊共享。

圖 3 :。通過合成數據進行模型驗證的流程

使用 GPU 擴展到真實數據量

GPU 加速的庫,如 RAPIDS 和 Plotly ,能夠以實際遇到的實際用例所需的規模進行模型驗證。這同樣適用于生成合成數據,其中以 AI 為動力的合成解決方案(主要是 AI )可以通過在全棧加速計算平臺上運行而受益匪淺。有關更多信息,請參閱 加速信用風險管理的可信 AI 。

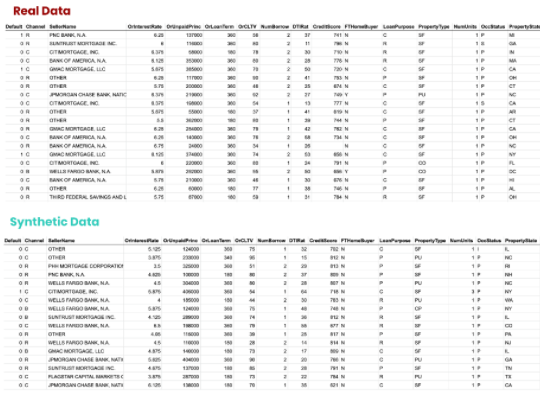

為了證明這一點,我們參考了房利美(Fannie Mae,FNMA)發布的抵押貸款數據集,目的是【VZX19】。我們首先生成一個具有統計代表性的訓練數據合成副本,由數千萬個合成貸款組成,由幾十個合成屬性組成(圖4)。

所有數據都是人工創建的,沒有一條記錄可以鏈接回原始數據集中的任何實際記錄。然而,數據的結構、模式和相關性被忠實地保留在合成數據集中。

這種捕獲數據多樣性和豐富性的能力對于模型驗證至關重要。該過程旨在驗證模型行為,不僅針對占主導地位的多數階級,還針對人口中代表性不足和最脆弱的少數群體。

圖 4 :。真實和合成數據樣本的快照

給定生成的合成數據,然后可以使用 GPU 加速的 XAI 庫來計算感興趣的統計信息,以評估模型行為。

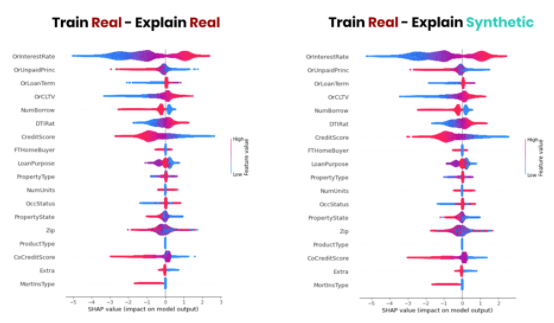

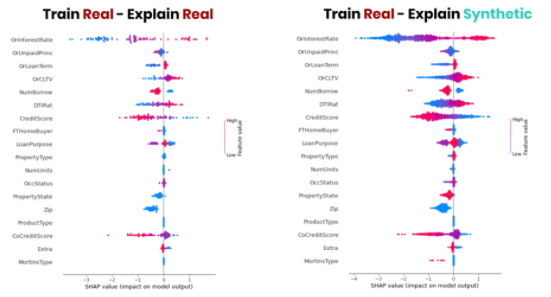

例如,圖 5 顯示了 SHAP 值的并列比較:貸款拖欠模型在真實數據上解釋,在合成數據上解釋之后。通過使用高質量的合成數據作為敏感原始數據的替代品,可以可靠地得出關于該模型的相同結論。

圖 5 :。貸款拖欠 ML 模型的 SHAP 值

圖 5 顯示,合成數據可以作為解釋模型行為的實際數據的安全替代品。

此外,合成數據生成器生成任意數量新數據的能力使您能夠顯著改進較小組的模型驗證。

圖 6 顯示了數據集中特定郵政編碼的 SHAP 值的并排比較。雖然原始數據在給定地理位置的貸款不到 100 筆,但我們利用 10 倍的數據量來檢查該區域的模型行為,從而實現更詳細和更豐富的見解。

圖 6 :。通過使用合成過采樣進行模型驗證,獲得更豐富的見解

使用合成樣品進行單獨水平檢驗

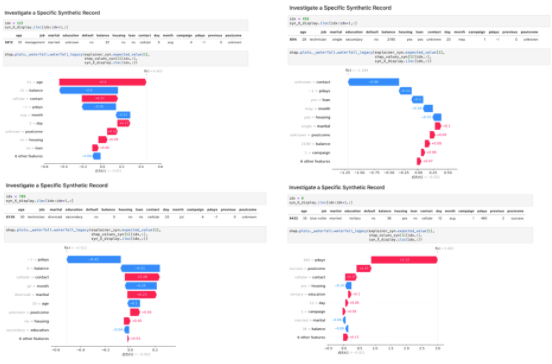

雖然匯總統計和可視化是分析一般模型行為的關鍵,但我們對模型的理解還可以通過逐個檢查單個樣本獲得更多好處。

XAI 工具揭示了多個信號對最終模型決策的影響。只要合成數據真實且具有代表性,這些案例不一定是實際案例。

圖 7 顯示了四個隨機生成的合成案例,以及它們的最終模型預測和每個輸入變量的相應分解。這使您能夠在不暴露任何個人隱私的情況下,深入了解對無限潛在案例的模型決策有多大影響的因素和方向。

圖 7 :。檢驗四個隨機抽樣合成記錄的模型預測

利用合成數據進行有效的 AI 治理

人工智能驅動的服務越來越多地出現在私營和公共部門,在我們的日常生活中發揮著越來越大的作用。然而,我們只是在人工智能治理的黎明。

雖然像歐洲提議的人工智能法案這樣的法規需要時間才能體現出來,但開發人員和決策者今天必須負責任地采取行動,并采用 XAI 最佳實踐。合成數據支持廣泛的協作環境,而不會危及客戶的隱私。它是一個強大、新穎的工具,可以支持開發和治理公平、健壯的人工智能。

關于作者

Jochen Papenbrock 位于德國法蘭克福,在過去的15年中,Jochen一直在金融服務業人工智能領域擔任各種角色,擔任思想領袖、實施者、研究者和生態系統塑造者。

Alexandra 是金融服務業的綜合數據專家,在隱私、公平和負責任的人工智能方面擁有深厚的專業知識。作為主要人工智能的首席信托官,她參與了有關隱私、道德人工智能和新興合成數據領域的公共政策討論,并定期在國際人工智能和銀行會議上發言,討論如何協調個性化與隱私,確保算法的公平性,以及如何克服數字轉型帶來的數據挑戰。除此之外, Alexandra 還是數據民主化播客的主持人,她邀請一些最大銀行的高管討論隱私和道德 AI 最佳實踐。

審核編輯:郭婷

-

gpu

+關注

關注

28文章

4775瀏覽量

129357 -

AI

+關注

關注

87文章

31520瀏覽量

270339 -

人工智能

+關注

關注

1796文章

47674瀏覽量

240294

發布評論請先 登錄

相關推薦

由合成數據支持的可解釋人工智能

由合成數據支持的可解釋人工智能

評論