論文地址:https://arxiv.org/pdf/1501.04587.pdf

摘要

阻礙CNN應(yīng)用于視覺(jué)跟蹤的主要障礙是缺乏適當(dāng)標(biāo)記的訓(xùn)練數(shù)據(jù)。雖然釋放CNN功率的現(xiàn)有應(yīng)用程序通常需要大量數(shù)百萬(wàn)的訓(xùn)練數(shù)據(jù),但是視覺(jué)跟蹤應(yīng)用程序通常在每個(gè)視頻的第一幀中僅具有一個(gè)標(biāo)記的示例。我們通過(guò)離線預(yù)培訓(xùn)CNN,然后將學(xué)到的豐富特征層次結(jié)構(gòu)轉(zhuǎn)移到在線跟蹤來(lái)解決此研究問(wèn)題。 CNN還在在線跟蹤期間進(jìn)行微調(diào),以適應(yīng)第一視頻幀中指定的跟蹤目標(biāo)的外觀。為了適應(yīng)對(duì)象跟蹤的特征,我們首先預(yù)先訓(xùn)練CNN以識(shí)別什么是對(duì)象,然后生成概率圖而不是生成簡(jiǎn)單的類標(biāo)簽。使用兩個(gè)具有挑戰(zhàn)性的開放式基準(zhǔn)進(jìn)行性能評(píng)估。

1 簡(jiǎn)介

在最近的研究興趣激增中,一些其他計(jì)算機(jī)視覺(jué)任務(wù)(例如視覺(jué)跟蹤)仍然相對(duì)未開發(fā)。我們認(rèn)為,一個(gè)主要原因是缺乏足夠的標(biāo)記訓(xùn)練數(shù)據(jù),這些數(shù)據(jù)通常在實(shí)現(xiàn)其他應(yīng)用的突破性表現(xiàn)方面起著非常重要的作用,因?yàn)镃NN訓(xùn)練通常以完全監(jiān)督的方式進(jìn)行。

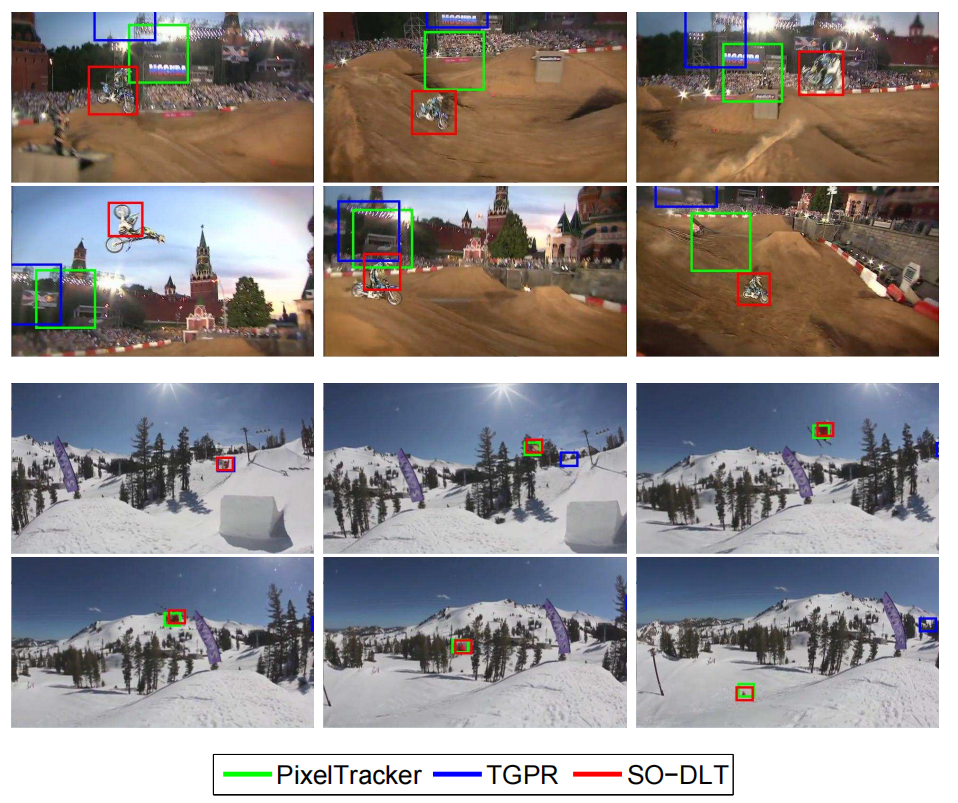

然而,在視覺(jué)跟蹤的情況下,標(biāo)記的訓(xùn)練數(shù)據(jù)通常非常有限,通常僅有一個(gè)標(biāo)記的示例作為在每個(gè)視頻的第一幀中指定的跟蹤對(duì)象。這使得大規(guī)模CNN方法的直接應(yīng)用變得不可行。在本文中,我們提出了一種可以解決這一挑戰(zhàn)的方法,因此可以將CNN框架引入視覺(jué)跟蹤。使用這種方法來(lái)實(shí)現(xiàn)跟蹤器,我們實(shí)現(xiàn)了非常有前途的性能,其性能優(yōu)于最先進(jìn)的基線跟蹤器超過(guò)10%(對(duì)于一些定性跟蹤結(jié)果,參見圖1)。

雖然視覺(jué)跟蹤可以根據(jù)不同的應(yīng)用在不同的設(shè)置中制定,但本文的重點(diǎn)是一次通過(guò)無(wú)模型的單目標(biāo)跟蹤設(shè)置。具體來(lái)說(shuō),它假定給出了第一幀中單個(gè)對(duì)象的邊界框,但沒(méi)有其他外觀模型可用。給定這個(gè)單獨(dú)的(標(biāo)記的)實(shí)例,目標(biāo)是以在線方式跟蹤對(duì)象的移動(dòng)。因此,該設(shè)置涉及基于跟蹤器的可能有噪聲的輸出使跟蹤器適應(yīng)對(duì)象的外觀變化。制定這個(gè)問(wèn)題的另一種方法是作為一個(gè)自學(xué)成才的單一學(xué)習(xí)問(wèn)題,其中單個(gè)例子來(lái)自前一幀。由于從單個(gè)示例學(xué)習(xí)視覺(jué)模型是一個(gè)不適定的問(wèn)題,因此成功的方法將需要使用一些輔助數(shù)據(jù)來(lái)學(xué)習(xí)通用對(duì)象特征的不變表示。雖然最近的一些工作也有這種精神,但由于一方面缺乏足夠的訓(xùn)練數(shù)據(jù)而另一方面所用模型的代表能力有限,所報(bào)告的表現(xiàn)不如現(xiàn)有技術(shù)水平。通過(guò)學(xué)習(xí)更強(qiáng)大的功能,CNN可以在這里發(fā)揮作用。為了在在線跟蹤期間使用有限的培訓(xùn)數(shù)據(jù)使其可行,我們離線預(yù)先培訓(xùn)CNN,然后將學(xué)習(xí)的通用功能轉(zhuǎn)移到在線跟蹤任務(wù)。

文獻(xiàn)中報(bào)道的第一個(gè)深度學(xué)習(xí)跟蹤器(DLT)基于SDAE網(wǎng)絡(luò)。雖然這種方法非常有前途,但與其他最先進(jìn)的跟蹤器相比,本文中報(bào)告的方法的確切實(shí)現(xiàn)有兩個(gè)限制,阻礙了DLT的跟蹤性能。首先,DLT的預(yù)訓(xùn)練可能不太適合跟蹤應(yīng)用。用于預(yù)訓(xùn)練的數(shù)據(jù)來(lái)自80M Tiny Images數(shù)據(jù)集,每個(gè)圖像通過(guò)直接從全尺寸圖像下采樣獲得。盡管可以通過(guò)學(xué)習(xí)重建輸入圖像來(lái)學(xué)習(xí)一些通用圖像特征,但是在典型的跟蹤任務(wù)中跟蹤的目標(biāo)是單個(gè)對(duì)象而不是整個(gè)圖像。對(duì)跟蹤有效的特征應(yīng)該能夠?qū)?duì)象與非對(duì)象(即背景)區(qū)分開,而不僅僅是重建整個(gè)圖像。其次,在每個(gè)幀中,DLT首先基于先前幀的預(yù)測(cè)生成目標(biāo)的候選者或提議,然后將跟蹤視為分類問(wèn)題。它忽略了邊界框的結(jié)構(gòu)化性質(zhì),因?yàn)檫吔缈蚧蚍指罱Y(jié)果對(duì)應(yīng)于圖像的區(qū)域,而不僅僅是分類或回歸問(wèn)題中的簡(jiǎn)單標(biāo)簽或?qū)崝?shù)。之前的一些工作表明,在模型中明確地利用結(jié)構(gòu)化性質(zhì)可以顯著提高性能。此外,提案的數(shù)量通常在幾百個(gè)數(shù)量級(jí),因此很難應(yīng)用更大的深度學(xué)習(xí)模型。

我們提出了一種新穎的結(jié)構(gòu)化輸出CNN,它傳輸用于在線跟蹤的通用對(duì)象特征。我們的論文的貢獻(xiàn)總結(jié)如下:

1.為了減輕在線跟蹤過(guò)程中的過(guò)度擬合和漂移問(wèn)題,我們預(yù)先訓(xùn)練CNN以區(qū)分對(duì)象和非對(duì)象,而不是簡(jiǎn)單地重建輸入或?qū)哂袑?duì)象級(jí)注釋的大規(guī)模數(shù)據(jù)集進(jìn)行分類分類。

2.CNN 的輸出是逐像素的映射,以指示輸入圖像中的每個(gè)像素屬于對(duì)象的邊界框的概率。像素輸出的主要優(yōu)點(diǎn)是其誘導(dǎo)的結(jié)構(gòu)損失和計(jì)算可擴(kuò)展性。

3.我們?cè)陂_放基準(zhǔn)以及具有挑戰(zhàn)性的非剛性物體跟蹤數(shù)據(jù)集上評(píng)估我們提出的方法,并獲得非常顯著的結(jié)果。特別是,對(duì)于開放基準(zhǔn),我們將重疊率曲線的 AUC 度量從0.529改善到0.602。

2 相關(guān)工作

3 我們的追蹤器

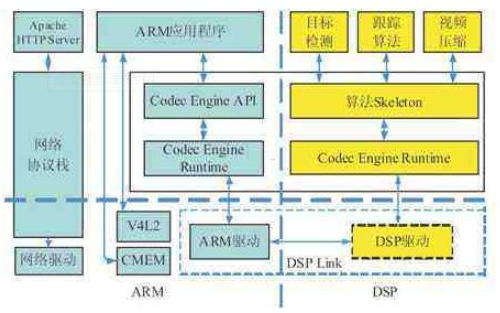

在本節(jié)中,我們將介紹我們的結(jié)構(gòu)化輸出深度學(xué)習(xí)跟蹤器( structured output deep learning tracker SO-DLT)。我們首先介紹了SO-DLT中的CNN架構(gòu)和CNN的離線預(yù)訓(xùn)練過(guò)程。然后,我們將介紹在線跟蹤流程的詳細(xì)信息。

3.1 概觀

跟蹤器的訓(xùn)練可分為兩個(gè)階段:

1.離線預(yù)訓(xùn)練階段

2.在線微調(diào)和跟蹤階段。

在訓(xùn)練前階段,我們訓(xùn)練CNN學(xué)習(xí)用于區(qū)分對(duì)象與非對(duì)象的通用對(duì)象特征,即,從示例中學(xué)習(xí)對(duì)象的概念。我們不是在在線跟蹤期間修復(fù)CNN的學(xué)習(xí)參數(shù),而是對(duì)它們進(jìn)行微調(diào),以便CNN能夠適應(yīng)被跟蹤的目標(biāo)。為了實(shí)現(xiàn)穩(wěn)健性,我們?cè)谠诰€跟蹤期間同時(shí)運(yùn)行兩個(gè)CNN,以解決模型更新可能導(dǎo)致的錯(cuò)誤。兩個(gè)CNN協(xié)同工作以確定每個(gè)視頻幀的跟蹤結(jié)果。

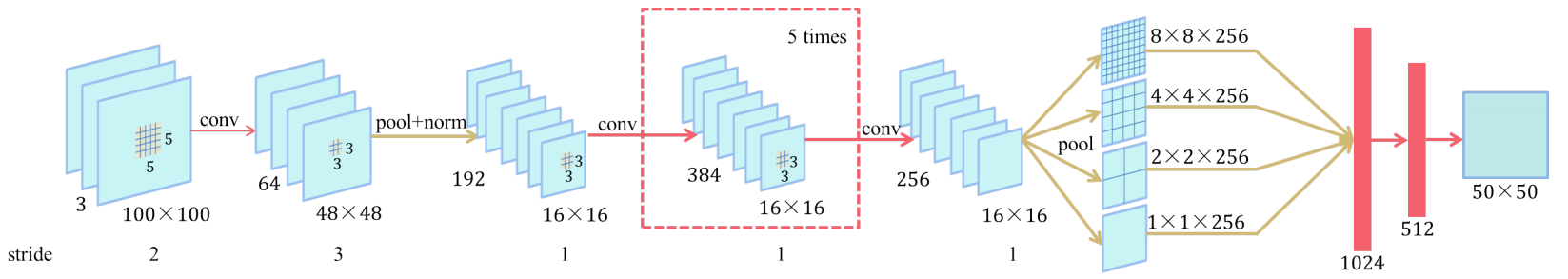

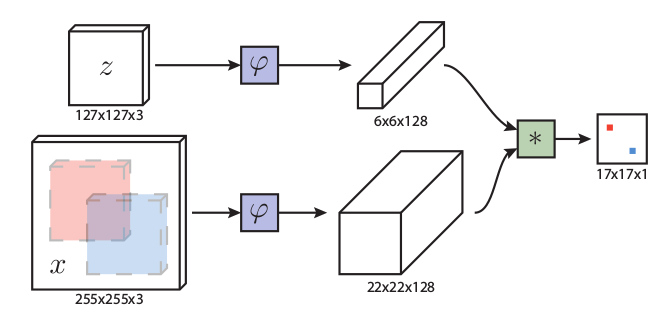

3.2 對(duì)象性預(yù)訓(xùn)練

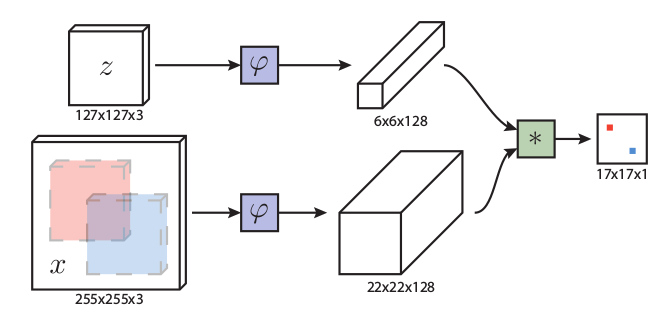

結(jié)構(gòu)化輸出CNN的結(jié)構(gòu)如圖2所示。它由七個(gè)卷積層和三個(gè)完全連接的層組成。在這兩部分之間,引入了多尺度池化以保留與地點(diǎn)相關(guān)的更多特征,因?yàn)檩敵鲂枰鼈冞M(jìn)行本地化。網(wǎng)絡(luò)的參數(shù)設(shè)置如圖2所示。與用于分類或回歸的傳統(tǒng)CNN相比,我們的模型存在一個(gè)重要的差異:CNN的輸出是50×50概率圖而不是單個(gè)數(shù)。每個(gè)輸出像素對(duì)應(yīng)于原始輸入中的2×2區(qū)域,其值表示對(duì)應(yīng)的輸入?yún)^(qū)域?qū)儆趯?duì)象的概率。在我們的實(shí)現(xiàn)中,輸出層是2500維全連接層,然后將其重新整形為50×50概率圖。由于概率圖的相鄰像素之間存在強(qiáng)相關(guān)性,因此我們僅使用前一層中的512個(gè)隱藏單元來(lái)幫助防止過(guò)擬合。

要訓(xùn)??練如此大的CNN,必須使用大型數(shù)據(jù)集來(lái)防止過(guò)度擬合。由于我們對(duì)對(duì)象級(jí)功能感興趣,因此我們使用ImageNet 2014檢測(cè)數(shù)據(jù)集,其中包含訓(xùn)練集中的478,807個(gè)邊界框。對(duì)于每個(gè)帶注釋的邊界框,我們?cè)谄渲車砑与S機(jī)填充和縮放。當(dāng)正樣本的重疊率(Overlap Rate, OLR)低于某個(gè)閾值時(shí),我們還隨機(jī)抽樣一些負(fù)樣本(negative samples)。請(qǐng)注意,它不會(huì)像在典型的分類或檢測(cè)任務(wù)中那樣學(xué)會(huì)區(qū)分不同的對(duì)象類,因?yàn)槲覀冎幌雽W(xué)習(xí)在此階段區(qū)分對(duì)象與非對(duì)象。因此,我們?cè)?0×50輸出圖的每個(gè)位置使用逐元素邏輯回歸模型,并相應(yīng)地定義損失函數(shù)。對(duì)于訓(xùn)練目標(biāo),邊界框內(nèi)的像素設(shè)置為1,而外部為0。對(duì)于負(fù)樣本整個(gè)概率圖目標(biāo)是0。該設(shè)置相當(dāng)于懲罰預(yù)測(cè)和地面實(shí)況之間的不匹配像素的數(shù)量,從而引起更好地適應(yīng)問(wèn)題的結(jié)構(gòu)化損失函數(shù)。在數(shù)學(xué)上,讓pij表示(i,j)位置的預(yù)測(cè),tij是二進(jìn)制變量表示(i,j)位置的基本事實(shí),我們方法的損失函數(shù)定義為:

\\min {p{i j}} \\sum_{i=1}^{50} \\sum_{j=1}^{50}-\\left(1-t_{i j}\\right) \\log \\left(1-p_{i j}\\right)-t_{i j} \\log \\left(p_{i j}\\right) \\tag{1}

4.1中描述了培訓(xùn)的詳細(xì)參數(shù)。

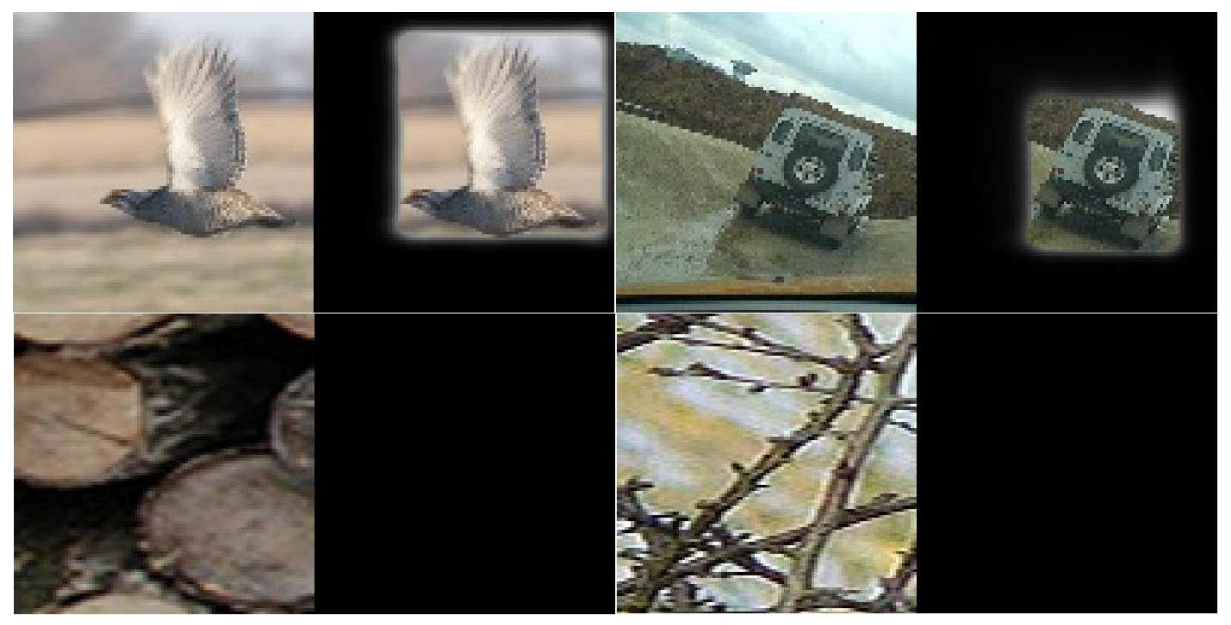

圖3顯示了在ImageNet 2014檢測(cè)任務(wù)提供的保持驗(yàn)證集上測(cè)試預(yù)訓(xùn)練的CNN時(shí)的一些結(jié)果。 在大多數(shù)情況下,CNN可以成功地確定輸入圖像是否包含對(duì)象,如果是,則可以準(zhǔn)確地定位感興趣的對(duì)象。 請(qǐng)注意,由于我們的訓(xùn)練數(shù)據(jù)的標(biāo)簽只是邊界框,因此50×50概率圖的輸出也是正方形。 雖然有方法[6]利用邊界框信息來(lái)提供弱監(jiān)督并獲得像素分割,但我們認(rèn)為模型中的概率圖輸出足以用于跟蹤。

3.3 在線跟蹤

如上所述預(yù)訓(xùn)練學(xué)習(xí)通用對(duì)象特征的CNN不能直接用于在線跟蹤,因?yàn)镮mageNet數(shù)據(jù)的數(shù)據(jù)偏差不同于在線跟蹤期間觀察到的數(shù)據(jù)偏差。此外,如果我們不對(duì)CNN進(jìn)行微調(diào),它將檢測(cè)到視頻幀中出現(xiàn)的所有對(duì)象,而不僅僅是被跟蹤的對(duì)象。因此,必須使用在線跟蹤期間收集的每個(gè)視頻的第一幀中的注釋來(lái)微調(diào)預(yù)訓(xùn)練的CNN,以確保CNN特定于目標(biāo)。微調(diào)或在線模型調(diào)整是我們跟蹤器中不可或缺的一部分,而不是僅為了進(jìn)一步提高跟蹤性能而引入的可選功能。

我們維護(hù)兩個(gè)使用不同模型更新策略的CNN。在使用第一幀中的注釋進(jìn)行微調(diào)之后,我們基于前一幀的估計(jì)從每個(gè)新幀中裁剪一些圖像塊。通過(guò)簡(jiǎn)單地向前穿過(guò)CNN,我們可以獲得每個(gè)圖像塊的概率圖。然后通過(guò)搜索適當(dāng)?shù)倪吔缈騺?lái)確定最終估計(jì)。如有必要,將更新兩個(gè)CNN。我們?cè)趫D4中說(shuō)明了跟蹤算法的流程。

3.3.1 邊界框確定

當(dāng)新框架到來(lái)時(shí),我們的跟蹤器的第一步是確定目標(biāo)的最佳位置和比例。我們首先指定可能包含目標(biāo)的可能區(qū)域,并將區(qū)域送到CNN。接下來(lái),我們根據(jù)概率圖確定邊界框的最可能位置。

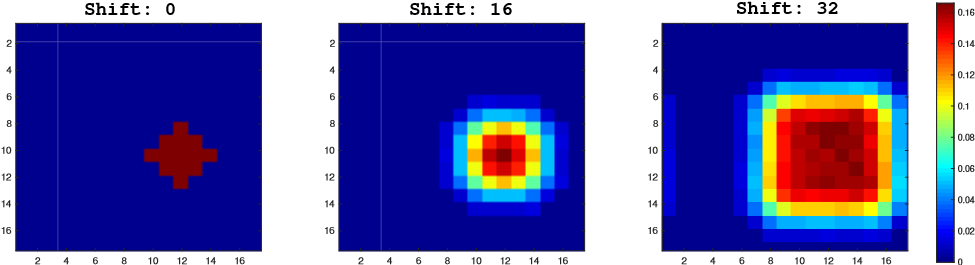

**搜索機(jī)制:**為目標(biāo)選擇合適的搜索范圍是一個(gè)非常重要的問(wèn)題。使用太小的搜索區(qū)域使得在快速運(yùn)動(dòng)下很容易失去對(duì)目標(biāo)的跟蹤,但是使用太大的搜索區(qū)域可能包括背景中的顯著干擾物。例如,在圖5中,輸出響應(yīng)變?nèi)酰驗(yàn)樗阉鲄^(qū)域被放大主要是由于雜亂的背景和附近的另一個(gè)人。為了解決這個(gè)問(wèn)題,我們提出了一種用于確定正確邊界框的多尺度搜索方案。首先,所有裁剪區(qū)域都以前一幀的估計(jì)為中心。然后,我們開始用最小的比例搜索。如果輸出概率圖上的總和低于閾值(即,目標(biāo)可能不在該比例中),那么我們進(jìn)入下一個(gè)更大的比例。如果我們無(wú)法在所有比例中找到對(duì)象,我們會(huì)報(bào)告目標(biāo)丟失。

**生成邊界框:**在我們選擇最佳比例后,我們需要為當(dāng)前幀生成最終邊界框。我們首先確定邊界框的中心,然后估計(jì)其相對(duì)于前一幀的比例變化。為了確定中心,我們使用基于密度的方法,該方法為相應(yīng)的概率圖設(shè)置閾值τ1,并找到具有高于閾值的所有概率值的邊界框。接下來(lái),通過(guò)取τ1的不同值的平均值來(lái)估計(jì)當(dāng)前尺度下的邊界框位置。確定中心后,我們需要在相應(yīng)區(qū)域再次搜索以找到合適的比例。該比例旨在完美地?cái)M合精確的目標(biāo)區(qū)域。簡(jiǎn)單地使用平均置信度(這使得跟蹤器更容易選擇中心區(qū)域具有高置信度)或完全置信度(這使得它更容易選擇整個(gè)幀)并不令人滿意。

設(shè)P表示輸出概率圖,并且p表示P中的第(i,j)個(gè)元素。我們考慮具有左上角(x,y),寬度w和高度h的邊界框。其得分計(jì)算為:

c=\\sum_{i=x}^{x+w-1} \\sum_{j=y}^{y+h-1}\\left(p_{i j}-\\epsilon\\right) \\cdot w \\cdot h \\tag{2}

在這里平衡邊界框的比例。我們還重復(fù)幾個(gè)值并對(duì)其結(jié)果進(jìn)行平均以進(jìn)行穩(wěn)健估計(jì)。借助積分圖像可以非常有效地計(jì)算置信度。

3.3.2 差分節(jié)奏微調(diào)

視覺(jué)跟蹤中的模型更新經(jīng)常面臨兩難選擇。如果跟蹤器更新頻率低,則無(wú)法很好地適應(yīng)外觀變化。但是如果更新太頻繁,不準(zhǔn)確的結(jié)果可能會(huì)影響其性能并導(dǎo)致漂移問(wèn)題。

我們通過(guò)在線跟蹤期間使用兩個(gè)CNN來(lái)解決這一難題。基本的想法是使一個(gè)CNN(CNNS)短期出現(xiàn),而另一個(gè)(CNNL)長(zhǎng)期出現(xiàn)。首先,兩個(gè)CNN都在視頻的第一幀中進(jìn)行微調(diào)。之后,CNNL保守調(diào)整,而CNNS則積極調(diào)整。通過(guò)協(xié)作,CNNS適應(yīng)戲劇性的外觀變化,而CNNL可以抵御潛在的錯(cuò)誤。然后由更自信的人確定最終估計(jì)。因此,最終的綜合結(jié)果對(duì)于由遮擋或雜亂背景引起的漂移更加穩(wěn)健。

我們現(xiàn)在提供有關(guān)更新策略的更多詳細(xì)信息。我們首先觀察到,如果在預(yù)測(cè)低于閾值時(shí)立即更新模型,則模型將很容易受到噪聲結(jié)果的影響。另一方面,我們發(fā)現(xiàn)負(fù)面例子的質(zhì)量通常非常穩(wěn)定。結(jié)果,當(dāng)存在這樣的負(fù)面示例時(shí),CNNS被更新:

\\sum_{i=1}^{50} \\sum_{j=1}^{50} p_{i j}>\\tau_{2} \\tag{3}

這是為了確保應(yīng)該抑制任何導(dǎo)致CNN起火的背景對(duì)象。 這樣做將減少跟蹤器在處理后續(xù)幀時(shí)向與跟蹤對(duì)象類似的一些負(fù)示例漂移的可能性。 相反,除了上述條件外,CNNL只會(huì)更新:

\\sum_{i=x}^{x+w-1} \\sum_{j=y}^{y+h-1} p_{i j}>\\tau_{3} \\cdot w \\cdot h \\tag{4}

其中(x,y,w,h)表示當(dāng)前幀中的輸出目標(biāo)邊界框。 這意味著我們更保守地更新 CNNL,因?yàn)槿绻覀儗?duì)當(dāng)前幀中的結(jié)果非常有信心,我們只會(huì)更新它。 這樣做可以降低真正目標(biāo)已經(jīng)漂移到后臺(tái)時(shí)不正確更新的風(fēng)險(xiǎn)。

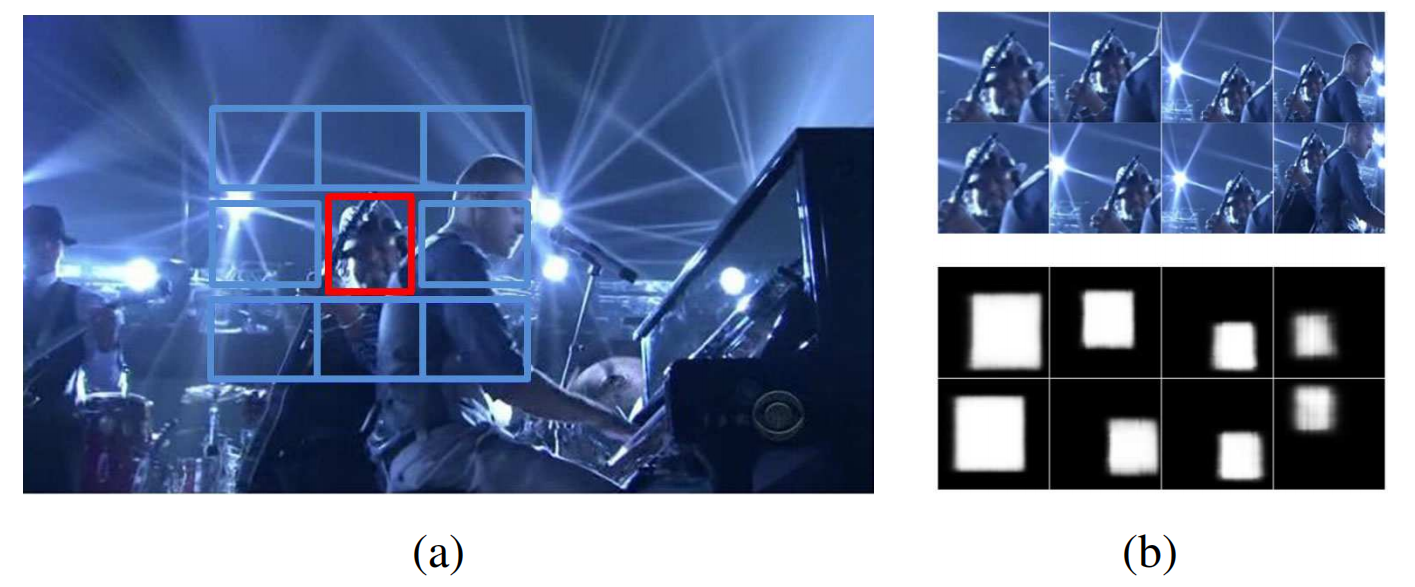

在每次更新中,我們都需要收集正面和負(fù)面的例子。 我們的抽樣方案如圖5所示。對(duì)于正例,我們基于前一幀的估計(jì)以四個(gè)尺度對(duì)它們進(jìn)行抽樣。 還引入隨機(jī)翻譯以消除對(duì)中心位置的學(xué)習(xí)偏差。 至于反面的例子,我們?cè)趦蓚€(gè)尺度上在不同方向上圍繞目標(biāo)裁剪八個(gè)非重疊邊界框。 正例的輸出也顯示在圖5中。

在左側(cè),紅色邊界框表示要跟蹤的目標(biāo),而其周圍的八個(gè)藍(lán)色邊框是負(fù)面示例。 在右邊,我們?cè)谏喜匡@示了進(jìn)入CNN的正面例子。 它們用不同的比例和隨機(jī)翻譯填充。 下部顯示了對(duì)該幀進(jìn)行微調(diào)后CNN的相應(yīng)輸出。

4 實(shí)驗(yàn)

在本節(jié)中,我們通過(guò)與其他最先進(jìn)的跟蹤器進(jìn)行比較,對(duì)經(jīng)過(guò)驗(yàn)證的SO-DLT跟蹤器進(jìn)行了實(shí)證驗(yàn)證。為了公平比較,我們不僅需要一個(gè)相當(dāng)大的基準(zhǔn)數(shù)據(jù)集來(lái)避免由于數(shù)據(jù)選擇而產(chǎn)生的偏差,而且還應(yīng)該有一個(gè)精心設(shè)計(jì)的協(xié)議,每個(gè)跟蹤器都遵循該協(xié)議。最近的一項(xiàng)工作引入了統(tǒng)一的跟蹤基準(zhǔn),其中包括數(shù)據(jù)集和協(xié)議。我們使用基準(zhǔn)數(shù)據(jù)集進(jìn)行比較研究,并嚴(yán)格遵循協(xié)議,為所有測(cè)試的視頻序列固定相同的參數(shù)集。如果論文被接受,我們將公開實(shí)施。

與CNN相關(guān)的部分使用Caffe工具箱實(shí)現(xiàn),在線跟蹤包裝器直接在MATLAB中實(shí)現(xiàn)。所有實(shí)驗(yàn)都在具有3.40GHz CPU和K40 GPU的臺(tái)式計(jì)算機(jī)上運(yùn)行。我們未經(jīng)優(yōu)化的代碼的速度約為每秒4到5幀。

對(duì)于CNN的預(yù)訓(xùn)練,我們從學(xué)習(xí)率10-7開始,動(dòng)量為0.9,并且每5個(gè)時(shí)期一次降低學(xué)習(xí)率。我們總共訓(xùn)練了大約15個(gè)時(shí)期。請(qǐng)注意,由于我們使用的損失函數(shù)不同,我們的學(xué)習(xí)率遠(yuǎn)低于典型選擇。為了減輕過(guò)度擬合,每層使用5×10-4的重量衰減,并且第一完全連接層以0.5的壓差率正規(guī)化。在微調(diào)期間,我們使用較大的學(xué)習(xí)率2×10-7,動(dòng)量小于0.5。對(duì)于第一幀,我們對(duì)每個(gè)CNN進(jìn)行微調(diào)20次。對(duì)于后續(xù)幀,我們只對(duì)一次迭代進(jìn)行微調(diào)。

τ1的范圍為0.1至0.7,步長(zhǎng)為0.05。將負(fù)例的置信度τ2的閾值設(shè)定為τ2= 100.將CNNL的更新閾值設(shè)定為τ3= 0.8。用于搜索適當(dāng)比例的歸一化常數(shù)范圍從0.55到0.6,步長(zhǎng)為0.025。

5 結(jié)論

在本文中,我們利用了傳輸高級(jí)特征層次結(jié)構(gòu)進(jìn)行視覺(jué)跟蹤的有效性。 據(jù)我們所知,我們是第一個(gè)將大規(guī)模CNN帶入視覺(jué)跟蹤領(lǐng)域的公司,并且顯示出對(duì)最先進(jìn)的跟蹤器的顯著改進(jìn)。 我們提出了一種用于視覺(jué)跟蹤的新穎結(jié)構(gòu)化輸出CNN,而不是將跟蹤建模作為提議分類問(wèn)題。 此外,CNN不是像以前的工作那樣學(xué)習(xí)重建輸入圖像,而是首先對(duì)大規(guī)模的ImageNet檢測(cè)數(shù)據(jù)集進(jìn)行預(yù)訓(xùn)練,以學(xué)習(xí)定位對(duì)象,從而緩解由于缺乏標(biāo)記訓(xùn)練而導(dǎo)致的問(wèn)題。 數(shù)據(jù)。 然后在在線跟蹤過(guò)程中傳輸和微調(diào)該對(duì)象CNN。 大量實(shí)驗(yàn)驗(yàn)證了我們的SO-DLT跟蹤器的優(yōu)越性。

學(xué)習(xí)更多編程知識(shí),請(qǐng)關(guān)注我的公眾號(hào):

[代碼的路]

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4779瀏覽量

101168 -

圖像處理

+關(guān)注

關(guān)注

27文章

1300瀏覽量

56890 -

視覺(jué)跟蹤

+關(guān)注

關(guān)注

0文章

11瀏覽量

8832 -

cnn

+關(guān)注

關(guān)注

3文章

353瀏覽量

22334 -

SDAE

+關(guān)注

關(guān)注

0文章

2瀏覽量

1525

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

高通Vuforia SDK 2.8的Extended Tracking功能

網(wǎng)絡(luò)分析儀的傳輸跟蹤規(guī)范是什么意思?

典型的ZYNQ SoC結(jié)構(gòu)圖/系統(tǒng)框架

自動(dòng)跟蹤對(duì)稱電源:Tracking Regulated Po

FM跟蹤發(fā)射器FM Tracking Transmitter

分塊多特征自適應(yīng)融合的多目標(biāo)視覺(jué)跟蹤_施瀅

機(jī)器視覺(jué)的Gabor Feature特征表達(dá)

結(jié)合高層對(duì)象特征和低層像素特征的視覺(jué)注意方法

基于SIFT特征匹配的運(yùn)動(dòng)目標(biāo)檢測(cè)及跟蹤方法

如何使用稀疏卷積特征和相關(guān)濾波進(jìn)行實(shí)時(shí)視覺(jué)跟蹤算法

SiamFC:用于目標(biāo)跟蹤的全卷積孿生網(wǎng)絡(luò) fully-convolutional siamese networks for object tracking

SiamRPN:High Performance Visual Tracking with Siamese Region Proposal Network 孿生網(wǎng)絡(luò)

SiamRPN++: Evolution of Siamese Visual Tracking with Very Deep Networks 深層網(wǎng)絡(luò)連體視覺(jué)跟蹤的演變

Azure Kinect Body Tracking For LabVIEW更新預(yù)覽

傳輸豐富的特征層次結(jié)構(gòu)以實(shí)現(xiàn)穩(wěn)健的視覺(jué)跟蹤Transferring Rich Feature Hierarchies for Robust Visual Tracking

傳輸豐富的特征層次結(jié)構(gòu)以實(shí)現(xiàn)穩(wěn)健的視覺(jué)跟蹤Transferring Rich Feature Hierarchies for Robust Visual Tracking

評(píng)論