這是RISC-V跑大模型系列的第二篇文章,主要教大家如何將LLaMA移植到RISC-V環境里。

1. 環境準備

2)確保機器有足夠的內存加載完整模型(7B模型需要13~15G)

3)下載原版LLaMA模型和擴展了的中文模型

LLaMA原版模型:

https://ipfs.io/ipfs/Qmb9y5GCkTG7ZzbBWMu2BXwMkzyCKcUjtEKPpgdZ7GEFKm/

2. 模型下載

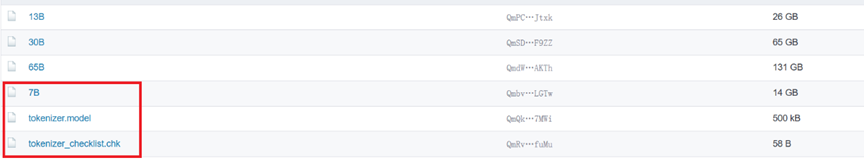

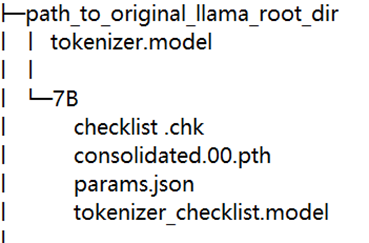

從LLaMA原版模型地址上下載下述文件(我們使用的是7B):

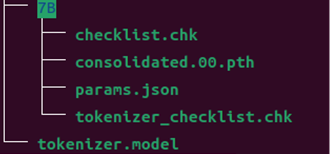

最后文件下載完成后的結果如下:

3. 加載并啟動

1)這一步需要下載llama.cpp,請輸入以下命令進行下載和編譯:

git clone https://github.com/ggerganov/llama.cpp && cd llama.cpp && make

2)將第二步下載的文件移到llama.cpp/models/下,使用命令:

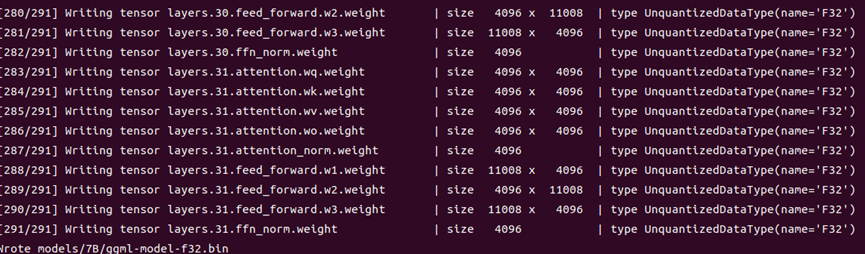

python3 convert-pth-to-ggml.py models/7B/ 0

3)將.pth模型權重轉換為ggml的FP32格式,生成文件路徑為models/7B/ggml-model-f32.bin。

4)運行./main二進制文件,-m命令指定Q4量化模型(也可加載ggml-FP16的模型)。以下是解碼參數:

./main models/7B/ggml-model-f32.bin --color -f prompts/alpaca.txt -ins -c 256 --temp 0.2 -n 128 --repeat_penalty 1.3

參數解釋:

| -ins | 啟動類ChatGPT對話交流的運行模式 |

| -f | 指定prompt模板,alpaca模型請加載prompts/alpaca.txt |

| -c | 控制上下文的長度,值越大越能參考更長的對話歷史(默認:512) |

| -n | 控制回復生成的最大長度(默認:128) |

| -t | 控制batch size(默認:8),可適當增加 |

| --repeat_penalty | 控制線程數量(默認:4),可適當增加 |

| --temp | 控制線程數量(默認:4),可適當增加 |

| --top_p, top_k |

控制解碼采樣的相關數據 |

4.結束

本篇教程到這里就結束了。是不是覺得LLaMA的速度比較慢而且不支持中文,沒關系,在下一期中,我們會為LLaMA擴充中文,并優化加速LLaMA,記得繼續關注我們哦。

另外,RISC -V跑大模型系列文章計劃分為四期:

1.RISC -V跑大模型(一)

2. RISC-V 跑大模型(二):LLaMA零基礎移植教程(本篇)

3.LLaMA擴充中文+優化加速(計劃)

4. 更多性能優化策略。(計劃)

審核編輯 黃宇

-

RISC-V

+關注

關注

45文章

2324瀏覽量

46604 -

大模型

+關注

關注

2文章

2551瀏覽量

3174 -

LLM

+關注

關注

0文章

299瀏覽量

400

發布評論請先 登錄

相關推薦

開發板上玩GTA,RISC-V多項移植項目成功運作中

安卓上RISC-V,移植成最大阻礙

每日推薦 | HarmonyOS 從入門到大神資料,從零開始寫RISC-V處理器經驗連載

RISC-V規范的演進 RISC-V何時爆發?

?開發板上玩GTA RISC-V多項移植項目成功運作中

從零開始寫RISC-V處理器

基于RISC-V內核單片機移植RTOS實時操作系統(一)

解鎖RISC-V技術力量丨曹英杰:RISC-V與大模型探索

RISC-V 跑大模型(二):LLaMA零基礎移植教程

RISC-V 跑大模型(二):LLaMA零基礎移植教程

評論