在AI大模型爆火的當下,GPU被瘋搶,連帶HBM內存芯片也在一片寒冬的存儲市場脫穎而出,成為三大原廠積極擴產的目標,并持續在該領域發力。

HBM是什么?

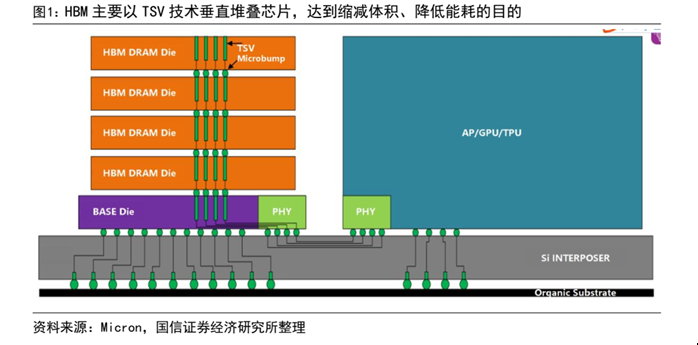

HBM(高帶寬存儲器, HighBandwidth Memory) 是一款新型的 CPU/GPU 內存芯片,是由 AMD 和 SK Hynix 發起的基于 3D 堆棧工藝的高性能 DRAM,適用于高存儲器帶寬需求的應用場合。HBM 以位元計算,通過增加帶寬,擴展內存容量,讓更大的模型、更多的參數留在離核心計算更近的地方,從而減少內存和存儲解決方案帶來的延遲,目的實現大容量,高位寬的 DDR 組合陣列,目前 HBM 占整個DRAM 市場比重約 1.5%,為新型高性能存儲產品。

由于AI 大模型處理數據的吞吐量呈指數級增長,需要應用并行處理數據的 GPU 作為核心處理器,GPU搭載的內存芯片帶寬關聯 GPU 數據處理能力,高帶寬的內存芯片可以為 GPU 提供更快的并行數據處理速度,對GPU的性能起到了決定性作用,HBM也順勢迎來發展機遇。

一系列配套性能自然決定了HBM的需求正不斷飆升,三大存儲原廠也看到了機遇,陸續決定擴產。

三大原廠積極擴產

據TrendForce集邦咨詢研究顯示,2022年三大原廠HBM市占率分別為SK海力士50%、三星約40%、美光約10%。此外,高階深度學習AI GPU的規格也刺激HBM產品更迭,2023下半年伴隨英偉達 H100與AMD MI300的搭載,三大原廠也已規劃相對應規格HBM3的量產。

SK海力士方面,正在擴建HBM產線,計劃將HBM產能翻倍,擴產焦點在于HBM3。據韓媒消息,SK海力士正在準備投資后段工藝設備,擴建封裝HBM3的利川工廠,預計到今年年末,后段工藝設備規模將增加近一倍。值得一提的是,SK海力士在去年6月已率先量產了DRAM HBM3,且已供貨英偉達的H100。另據Business Korea報道顯示,英偉達已要求SK 海力士提供HBM3E樣品,后者正在準備出貨樣品。

HBM3E是DRAM HBM3的下一代產品,目前SK海力士正在開發,目標明年上半年量產。

三星方面,據韓國ET News消息,三星電子將投資1萬億韓元(約合7.66億美元)擴大HBM產能,目標是到2024年底將HBM產能翻一番,并且已經下了主要設備的訂單。

美光方面,3月份的時候就宣布旗下第二代高帶寬存儲器(HBM2)即將開始出貨。HBM2主要用于高性能顯卡、服務器處理器以及各種高端處理器中。

價格是傳統DRAM的2~3倍

價格方面,目前HBM的價格比較昂貴,原本就是傳統DRAM的2~3倍。而在2023年開年后,隨著三星、SK海力士的HBM訂單快速增加,之前另有消息稱HBM3較DRAM價格上漲5倍。需求方面,由于谷歌、蘋果、微軟等科技巨頭都在籌劃擴大AI服務,HBM需求自然水漲船高。

業內預計,明年三星與SK海力士都將進一步擴大投資規模。,“但若想滿足未來需求,三星、SK海力士都必須將產能提高10倍以上。

TrendForce表示,從高階GPU搭載的HBM來看,英偉達高階GPU H100、A100主要采用HBM2e、HBM3。隨著英偉達的A100/H100、AMD的MI200/MI300、谷歌自研的TPU等需求逐步提升,預估2023年HBM需求量將同比增長58%,2024年有望再增長約30%。

國盛證券指出,HBM最適用于AI訓練、推理的存儲芯片。受AI服務器增長拉動,HBM需求有望在2027年增長至超過6000萬片。廣發證券也補充,HBM方案目前已演進為高性能計算領域擴展高帶寬的主流方案,并逐漸成為主流AI訓練芯片的標配。

Omdia則預計,2025年HBM市場規模可達25億美元。

-

存儲器

+關注

關注

38文章

7528瀏覽量

164345 -

AI

+關注

關注

87文章

31520瀏覽量

270335 -

大模型

+關注

關注

2文章

2548瀏覽量

3168

原文標題:AI風口下的這類芯片:缺貨、漲價、擴產!

文章出處:【微信號:ickey360,微信公眾號:芯三板】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

生成式AI帶飛,三大存儲產品齊漲價

鋰電漲價預期初步兌現 鋰電企業掀起擴產潮

臺積電CoWoS擴產超預期,月產能將達7.5萬片

臺積電先進封裝大擴產,CoWoS制程成擴充主力

大模型下的新風口,AI耳機帶飛存儲!

FPGA芯片國產替代性價比凸顯,Altera漲價在即,Xilinx繼去年大幅漲價后,12月繼續大幅調漲價格,成熟產品尤甚

德州儀器獲16億美元美國“芯片法案”補貼,助力擴產與就業

緯創擬斥資逾84億臺幣擴產AI服務器

德高化成第三代半導體GaN倒裝芯片LED封裝制造擴產項目正式開工

Pura 70系列AI修圖大師再上新!小藝AI擴圖開啟魔幻新體驗

AI風口下的這類芯片:缺貨、漲價、擴產!

AI風口下的這類芯片:缺貨、漲價、擴產!

評論