案例簡介

本案例通過利用NVIDIA TensorRT-LLM加速指令識別深度學習模型,并借助NVIDIA Triton推理服務器在NVIDIA V100 GPU上進行高效部署,幫助必優科技的文檔智能體 UTalk-Doc 將用戶指令識別服務吞吐量提升了 5 倍,單個請求響應時間縮減了三分之一,大幅提升服務運行效率,提升資源利用率。Triton 模型分析能力還協助必優科技,將尋找最佳推理配置所需的時間從數周減少到數小時。

智能體迭代和

用戶增長的并發壓力

必優科技旗下 UTalk-Doc 是新一代協助用戶進行表達的辦公產品。其中“用戶指令識別”能力是產品組成中十分重要的一環。目前該能力主要由底層指令識別深度學習模型提供服務支持。

深度學習模型在運行過程中需要較大的計算量,在用 Pytorch 進行模型的推理時,一方面時延特別大,導致用戶體驗受損;另一方面,顯存占用很大,導致推理請求的并發數上不去,請求失敗的概率太高,只能通過增加機器的方式來提高并發能力,業務部署成本較高;再次,使用的模型經常變化,而業務需要更換后的模型能夠快速地加速和上線部署。NVIDIA GPU 硬件和軟件框架的強大性能幫助企業解決了海量計算需求,滿足了必優科技多模態 office 智能體的迭代和用戶幾何倍增長的并發壓力。

利用 NVIDIA產品技術組合

提升用戶體驗

基于以上挑戰,必優科技選擇了采用 NVIDIA 的 TensorRT-LLM SDK 對模型進行推理加速,并利用 NVIDIA Triton推理服務器在 V100 GPU 上進行在線部署,在提升用戶體驗的同時,大幅降低了服務成本。

通過使用 TensorRT-LLM 對指令識別深度學習模型進行加速,在都使用 FP32 的情況下,與 Pytorch 相對,時延降低 50% 左右。

使用 TensorRT-LLM 結合 NVIDIA V100 GPU 的 FP16 Tensor Core,在保證精度的同時,模型推理的時延進一步降低了 40%。

Triton 的 dynamic batch 及多實例特性,在滿足時延要求的同時,提高了系統整體的并發能力。

TensorRT-LLM 可以對模型進行快速地加速,Triton 則可以對加速后的模型進行快速地部署,滿足了業務對修改后的模型進行快速部署的需求,同時也大大減少了工程人員的工作量。

NVIDIA 賦能文檔智能體

在 NVIDIA 技術和初創加速生態的加持中,必優科技旗下應用產品 ChatPPT(UTalk-Doc)在短短幾個月內自然注冊用戶破 100 萬,同時通過內容表達場景(如 PPT 演示),賦能了如金融、教育、醫療等垂直行業領域客戶,并且在硬件生態合作等方面也做了更多的探索,共同推進整個 AI 行業的快速發展。

“NVIDIA 提供的 GPU 解決方案,解決了深度學習和機器學習的技術難題,是我們公司在人工智能道路上一路狂飆所不可或缺的一環。”必優科技創始人兼 CTO 陳潤天博士表示。

必優科技成立于 2020 年,是國內較早期就專注于人工智能領域的智能內容生成技術的科技型公司,公司目前主要圍繞智慧辦公場景做相關業務開發服務,如 2023 年 3 月上線的 Chatppt(AI 生成 PPT)6 個月用戶過百萬;全新下一代產品 UTalk-Doc——不拘泥于格式、自由切換文檔格式的產品,將徹底顛覆、改變和引領下一代 office 產品,幫助用戶更好地進行表達。

NVIDIA 初創加速計劃

必優科技是 NVIDIA 初創加速計劃 (NVIDIA Inception) 會員企業。NVIDIA 初創加速計劃為免費會員制,旨在培養顛覆行業格局的優秀創業公司。該計劃聯合國內外知名的風投機構,創業孵化器,創業加速器,行業合作伙伴以及科技創業媒體等,打造創業加速生態系統。能夠提供產品折扣,技術支持,市場宣傳,融資對接,業務推薦等一系列服務,加速創業公司的發展。

-

NVIDIA

+關注

關注

14文章

5076瀏覽量

103728 -

gpu

+關注

關注

28文章

4777瀏覽量

129360 -

深度學習

+關注

關注

73文章

5516瀏覽量

121553

原文標題:NVIDIA GPU 解決方案加速必優科技新一代文檔智能體

文章出處:【微信號:NVIDIA_China,微信公眾號:NVIDIA英偉達】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

NVIDIA攜手行業巨頭,共促醫療健康產業變革

NVIDIA技術引領媒體行業AI革新

NVIDIA技術助力Pantheon Lab數字人實時交互解決方案

戴爾科技集團推出全新PC產品組合,驅動行業創新

借助NVIDIA GPU提升魯班系統CAE軟件計算效率

NVIDIA推出全新生成式AI模型Fugatto

全球大型電子產品制造商利用 Omniverse 和 AI 制定計劃

Foxconn利用NVIDIA AI和Omniverse訓練機器人

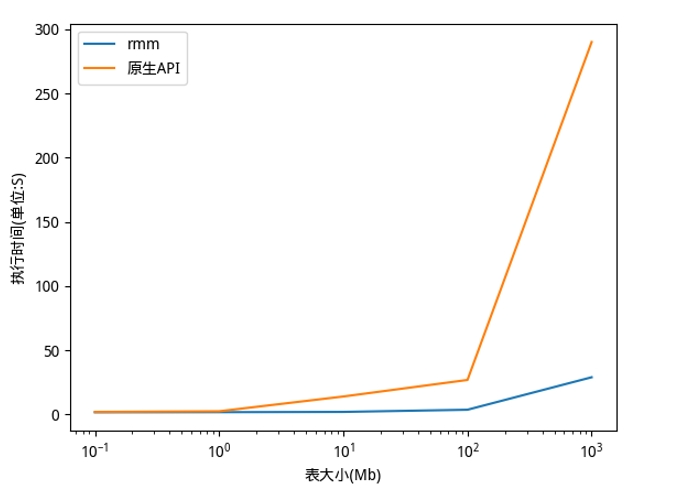

利用NVIDIA RAPIDS加速DolphinDB Shark平臺提升計算性能

利用NVIDIA產品技術組合提升用戶體驗

利用NVIDIA產品技術組合提升用戶體驗

評論