引言

深度學習作為人工智能領域的一個重要分支,在過去十年中取得了顯著的進展。在構建和訓練深度學習模型的過程中,深度學習框架扮演著至關重要的角色。TensorFlow和PyTorch是目前最受歡迎的兩大深度學習框架,它們各自擁有獨特的特點和優勢。本文將從背景介紹、核心特性、操作步驟、性能對比以及選擇指南等方面對TensorFlow和PyTorch進行詳細比較,以幫助讀者了解這兩個框架的優缺點,并選擇最適合自己需求的框架。

背景介紹

TensorFlow

TensorFlow由Google的智能機器研究部門開發,并在2015年發布。它是一個開源的深度學習框架,旨在提供一個可擴展的、高性能的、易于使用的深度學習平臺,可以在多種硬件設備上運行,包括CPU、GPU和TPU。TensorFlow的核心概念是張量(Tensor),它是一個多維數組,用于表示數據和計算的結果。TensorFlow使用Directed Acyclic Graph(DAG)來表示模型,模型中的每個操作都是一個節點,這些節點之間通過張量連接在一起。

PyTorch

PyTorch由Facebook的核心人工智能團隊開發,并在2016年發布。它同樣是一個開源的深度學習框架,旨在提供一個易于使用的、靈活的、高性能的深度學習平臺,也可以在多種硬件設備上運行。PyTorch的核心概念是動態計算圖(Dynamic Computation Graph),它允許開發人員在運行時修改計算圖,這使得PyTorch在模型開發和調試時更加靈活。PyTorch使用Python編程語言,這使得它更容易學習和使用。

核心特性比較

計算圖

- TensorFlow :TensorFlow 1.x版本使用靜態計算圖,即需要在計算開始前將整個計算圖完全定義并優化。這種方式使得TensorFlow在執行前能夠進行更多的優化,從而提高性能,尤其是在大規模分布式計算時表現尤為出色。然而,這種方式不利于調試。而在TensorFlow 2.x版本中,引入了動態計算圖(Eager Execution),使得代碼的執行和調試更加直觀和方便。

- PyTorch :PyTorch采用動態計算圖,計算圖在運行時構建,可以根據需要進行修改。這種靈活性使得PyTorch在模型開發和調試時更加方便,但在執行效率上可能略遜于TensorFlow,尤其是在復雜和大規模的計算任務中。

編程風格

- TensorFlow :TensorFlow的編程風格相對較為嚴謹,需要用戶先定義計算圖,再執行計算。這種方式在部署和優化方面有一定的優勢,但學習曲線較為陡峭。不過,TensorFlow 2.x版本通過引入Keras API,使得構建神經網絡模型變得更加簡單和直觀。

- PyTorch :PyTorch的編程風格更接近Python,其API設計也盡可能接近Python的工作方式,這使得PyTorch對于Python開發者來說非常容易上手。PyTorch的動態計算圖特性也使其在實驗和原型設計方面非常受歡迎。

生態系統

- TensorFlow :TensorFlow擁有一個龐大的生態系統,包括用于移動設備(TensorFlow Lite)、瀏覽器(TensorFlow.js)、分享和發現預訓練模型和特征的平臺(TensorFlow Hub)等。此外,TensorFlow還提供了許多高級功能,如自動混合精度訓練、聯邦學習等,這些功能可以進一步提高模型的訓練速度和精度。

- PyTorch :PyTorch的生態系統相對較小,但也在不斷發展壯大。PyTorch的研究社區非常活躍,許多最新的研究成果首先在PyTorch上實現。此外,PyTorch也提供了豐富的自動微分功能,使得求解梯度變得非常簡單。

操作步驟與示例

TensorFlow 示例

以下是一個使用TensorFlow構建線性回歸模型的簡單示例:

import tensorflow as tf

# 創建輸入數據張量

x = tf.constant([[1.0, 2.0], [3.0, 4.0], [5.0, 6.0]], dtype=tf.float32)

y = tf.constant([2.0, 4.0, 6.0], dtype=tf.float32)

# 創建權重矩陣張量和偏置項張量

W = tf.Variable(tf.random.normal([2, 1], dtype=tf.float32), name='weights')

b = tf.Variable(tf.zeros([1], dtype=tf.float32), name='bias')

# 使用tf.matmul函數計算輸入數據與權重矩陣的乘積

y_pred = tf.matmul(x, W) + b

# 計算損失

loss = tf.square(y_pred - y)

loss = tf.reduce_mean(loss)

# 使用優化器最小化損失

optimizer = tf.train.GradientDescentOptimizer(learning_rate=0.01)

train = optimizer.minimize(loss)

# 初始化變量并啟動會話

init = tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)

for

TensorFlow 示例(續)

for i in range(1000):

sess.run(train)

if i % 100 == 0:

print(f'Step {i}, Loss: {sess.run(loss)}')

# 輸出訓練后的權重和偏置

print(f'Weights: {sess.run(W)}')

print(f'Bias: {sess.run(b)}')

在這個示例中,我們首先定義了輸入數據x和對應的標簽y,然后創建了權重矩陣W和偏置項b作為可訓練的變量。接著,我們計算了預測值y_pred,即輸入數據x與權重矩陣W的乘積加上偏置項b。之后,我們定義了損失函數為預測值與真實值之間的均方誤差,并使用梯度下降優化器來最小化這個損失。最后,我們通過多次迭代來訓練模型,并在每次迭代后打印出當前的損失值,以及訓練完成后的權重和偏置。

PyTorch 示例

以下是一個使用PyTorch構建相同線性回歸模型的簡單示例:

import torch

import torch.nn as nn

import torch.optim as optim

# 定義模型

class LinearRegressionModel(nn.Module):

def __init__(self):

super(LinearRegressionModel, self).__init__()

self.linear = nn.Linear(2, 1) # 輸入特征數為2,輸出特征數為1

def forward(self, x):

return self.linear(x)

# 創建模型實例

model = LinearRegressionModel()

# 定義損失函數和優化器

criterion = nn.MSELoss()

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 準備輸入數據和標簽

x = torch.tensor([[1.0, 2.0], [3.0, 4.0], [5.0, 6.0]], dtype=torch.float32)

y = torch.tensor([2.0, 4.0, 6.0], dtype=torch.float32)

# 轉換標簽的形狀,使其與模型輸出一致

y = y.view(-1, 1)

# 訓練模型

for epoch in range(1000):

# 前向傳播

outputs = model(x)

loss = criterion(outputs, y)

# 反向傳播和優化

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 打印損失

if (epoch+1) % 100 == 0:

print(f'Epoch [{epoch+1}/{1000}], Loss: {loss.item():.4f}')

# 輸出訓練后的模型參數

print(f'Model parameters:n{model.state_dict()}')

在這個PyTorch示例中,我們首先定義了一個LinearRegressionModel類,它繼承自nn.Module并包含一個線性層nn.Linear。然后,我們創建了模型實例,并定義了損失函數(均方誤差)和優化器(SGD)。接著,我們準備了輸入數據x和標簽y,并確保了它們的形狀與模型的要求一致。在訓練過程中,我們通過多次迭代來更新模型的參數,并在每次迭代后打印出當前的損失值。最后,我們輸出了訓練后的模型參數。

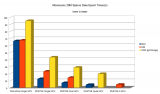

性能對比

靈活性

- PyTorch :PyTorch的動態計算圖特性使其在模型開發和調試時更加靈活。開發者可以在運行時動態地修改計算圖,這使得PyTorch在原型設計和實驗階段非常受歡迎。

- TensorFlow :TensorFlow的靜態計算圖(在TensorFlow 2.x中通過Eager Execution得到了改善)在編譯時進行優化,這有助于在大規模分布式計算中提高性能。然而,在模型開發和調試時,靜態計算圖可能不如動態計算圖靈活。

性能

- TensorFlow :TensorFlow在編譯時優化計算圖,這使得它在執行大規模計算任務時通常具有較高的性能。此外,TensorFlow還提供了自動混合精度訓練等高級功能,可以進一步提高訓練速度和精度。

- PyTorch :PyTorch的動態計算圖特性可能在一定程度上影響執行效率,尤其是在需要進行大量計算的情況下。然而,隨著PyTorch的不斷發展和優化,其性能也在不斷提升。

生態系統

- TensorFlow :TensorFlow擁有一個龐大的生態系統,包括用于移動設備、瀏覽器、分布式計算等多個領域的工具和庫。這使得TensorFlow在工業界和學術界都有廣泛的應用。

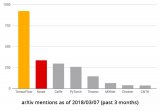

- PyTorch :雖然PyTorch的生態系統相對較小,但其研究社區非常活躍,并且與學術界緊密合作。許多最新的研究成果和算法首先在PyTorch上實現,這使得PyTorch在研究和實驗領域具有獨特的優勢。此外,PyTorch還提供了豐富的API和工具,如

torchvision(用于圖像處理和計算機視覺任務)、torchaudio(用于音頻處理)、torchtext(用于自然語言處理)等,這些庫極大地擴展了PyTorch的功能和應用范圍。

選擇指南

在選擇TensorFlow或PyTorch時,您應該考慮以下幾個因素:

- 項目需求 :首先明確您的項目需求,包括模型的復雜度、計算資源的可用性、部署環境等。如果您的項目需要在大規模分布式計算環境中運行,或者需要利用TensorFlow提供的自動混合精度訓練等高級功能,那么TensorFlow可能是更好的選擇。如果您的項目更注重模型的快速原型設計和實驗,或者您更傾向于使用Python的靈活性和動態性,那么PyTorch可能更適合您。

- 學習曲線 :TensorFlow和PyTorch都有各自的學習曲線。TensorFlow的API相對較為嚴謹,需要一定的時間來熟悉其計算圖的概念和操作方式。而PyTorch的API更加接近Python的工作方式,對于Python開發者來說更容易上手。因此,如果您是Python開發者,或者希望快速開始深度學習項目,那么PyTorch可能更適合您。

- 社區支持 :TensorFlow和PyTorch都擁有龐大的社區支持,但它們的社區氛圍和重點略有不同。TensorFlow的社區更加側重于工業界的應用和部署,而PyTorch的社區則更加側重于研究和實驗。因此,您可以根據自己的興趣和需求選擇更適合自己的社區。

- 兼容性 :考慮您的項目是否需要與其他系統或框架兼容。例如,如果您的項目需要與TensorFlow Lite(用于移動設備的TensorFlow)或TensorFlow.js(用于瀏覽器的TensorFlow)等TensorFlow生態系統中的其他工具集成,那么選擇TensorFlow可能更加方便。

- 未來趨勢 :最后,您還可以考慮未來趨勢和發展方向。雖然TensorFlow和PyTorch都是目前非常流行的深度學習框架,但未來可能會有新的框架或技術出現。因此,您可以關注業界動態和趨勢,以便及時調整自己的選擇。

結論

TensorFlow和PyTorch都是優秀的深度學習框架,它們各自擁有獨特的特點和優勢。在選擇框架時,您應該根據自己的項目需求、學習曲線、社區支持、兼容性和未來趨勢等因素進行綜合考慮。無論您選擇哪個框架,都應該深入學習其核心概念和API,以便更好地利用它們來構建和訓練深度學習模型。

-

深度學習

+關注

關注

73文章

5513瀏覽量

121544 -

tensorflow

+關注

關注

13文章

329瀏覽量

60629 -

pytorch

+關注

關注

2文章

808瀏覽量

13359

發布評論請先 登錄

相關推薦

TensorFlow實戰之深度學習框架的對比

深度學習框架排名:TensorFlow第一,PyTorch第二

TensorFlow與PyTorch深度學習框架的比較與選擇

TensorFlow與PyTorch深度學習框架的比較與選擇

評論