隨著人工智能技術(shù)的飛速發(fā)展,大語言模型(LLM)已成為自然語言處理領(lǐng)域的核心工具,廣泛應(yīng)用于智能客服、文本生成、機器翻譯等多個場景。然而,大語言模型的高計算復(fù)雜度和資源消耗成為其在實際應(yīng)用中面臨的主要挑戰(zhàn)。本文將從多個維度深入探討如何加速大語言模型的推理過程,以期為相關(guān)領(lǐng)域的研究者和開發(fā)者提供參考。

一、引言

大語言模型,如GPT系列、BERT等,基于Transformer架構(gòu),通過海量數(shù)據(jù)的訓練,具備了強大的語言理解和生成能力。然而,這些模型龐大的參數(shù)量和復(fù)雜的計算需求,使得其推理速度較慢,難以滿足實時響應(yīng)的需求。因此,加速大語言模型推理成為了一個亟待解決的問題。

二、模型壓縮技術(shù)

模型壓縮是一種減少模型大小和計算需求的技術(shù),旨在保持模型性能的同時降低其資源消耗。主要方法包括:

- 剪枝 :通過移除模型中不重要的參數(shù)或連接,減少模型復(fù)雜度。剪枝技術(shù)可以分為非結(jié)構(gòu)化剪枝和結(jié)構(gòu)化剪枝兩種,前者直接刪除單個權(quán)重,后者則刪除整個神經(jīng)元或?qū)印?/li>

- 量化 :將模型中的浮點數(shù)權(quán)重和激活值轉(zhuǎn)換為低精度整數(shù),如8位或4位量化,以減少內(nèi)存占用和計算量。量化通常會導(dǎo)致一定的精度損失,但合理的量化策略可以在保持性能的同時顯著降低推理時間。

- 知識蒸餾 :通過一個小而快的“學生”模型學習一個龐大且復(fù)雜的“教師”模型的知識,從而在保持性能的同時減小模型尺寸。

三、硬件優(yōu)化

使用特定的硬件加速器可以顯著提高大語言模型的推理速度。這些硬件通常具有并行處理能力,能夠高效地執(zhí)行大量的矩陣運算。

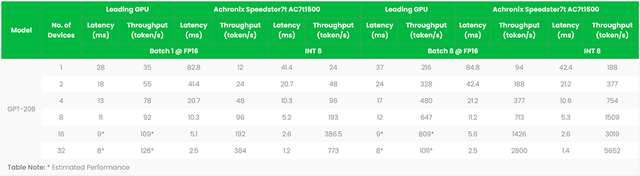

- GPU :圖形處理單元(GPU)具有強大的并行計算能力,適合處理大量并行的矩陣乘法運算,是加速深度學習模型推理的常用硬件。

- TPU :張量處理單元(TPU)是谷歌專為機器學習設(shè)計的專用集成電路(ASIC),進一步優(yōu)化了矩陣運算的性能,比GPU更適合用于加速大語言模型的推理。

- FPGA :現(xiàn)場可編程門陣列(FPGA)可以根據(jù)特定任務(wù)進行定制,實現(xiàn)高效的硬件加速。通過為Transformer等特定模型設(shè)計專用的FPGA加速器,可以進一步提升推理速度。

四、模型微調(diào)與結(jié)構(gòu)優(yōu)化

- 模型微調(diào) :通過對模型進行微調(diào),可以使其更適應(yīng)特定的任務(wù)或數(shù)據(jù)集,從而在不犧牲準確性的情況下提高推理速度。例如,使用adapters進行微調(diào),可以在不改變原始模型參數(shù)的情況下,通過添加額外的參數(shù)來提高模型在特定任務(wù)上的性能。

- 模型結(jié)構(gòu)優(yōu)化 :設(shè)計更高效的網(wǎng)絡(luò)結(jié)構(gòu)可以減少計算量同時保持性能。例如,使用深度可分離卷積或注意力機制的變體來替代傳統(tǒng)的卷積層或自注意力層。

五、高效的推理引擎與算法優(yōu)化

- 推理引擎 :如SiliconLLM等專為大模型推理設(shè)計的加速引擎,可以顯著降低部署成本并加速生成式AI產(chǎn)品的落地。這些引擎通常集成了多種優(yōu)化技術(shù),包括模型壓縮、硬件加速等。

- 算法優(yōu)化 :研究和開發(fā)更高效的算法可以減少模型在推理時的計算復(fù)雜度。例如,優(yōu)化注意力機制的計算過程,通過稀疏化或近似化等方法減少不必要的計算。

六、并行計算與緩存技術(shù)

- 并行計算 :利用多線程或分布式計算技術(shù)將推理任務(wù)分散到多個處理器或計算機上執(zhí)行,可以顯著提高整體的處理速度。例如,使用分布式訓練框架將模型分割成多個部分并行處理。

- 緩存和預(yù)取技術(shù) :通過智能地緩存數(shù)據(jù)和預(yù)取可能需要的信息可以減少內(nèi)存訪問時間。例如,在大語言模型推理過程中使用KV緩存技術(shù)存儲和復(fù)用前序詞塊在計算注意力機制時產(chǎn)生的Key和Value向量,以減少大量計算上的冗余。

七、存內(nèi)計算技術(shù)

存內(nèi)計算技術(shù)(Compute-In-Memory, CIM)通過在內(nèi)存芯片中直接進行數(shù)據(jù)處理來減少數(shù)據(jù)在傳統(tǒng)計算架構(gòu)中從存儲器到處理器之間的傳輸需求。這種技術(shù)可以顯著降低能源消耗并減少推理任務(wù)的延遲。例如,X-Former和iMCAT等CIM硬件平臺通過優(yōu)化參數(shù)管理、提升計算效率和硬件利用率來加速Transformer模型的推理過程。

八、實際應(yīng)用場景優(yōu)化

不同的應(yīng)用場景對LLM的推理性能有不同的需求。因此,需要根據(jù)實際應(yīng)用場景來選擇合適的優(yōu)化策略。例如,對于需要實時響應(yīng)的場景可以優(yōu)先考慮降低時延;而對于需要處理大量數(shù)據(jù)的場景可以優(yōu)先考慮提高吞吐量和優(yōu)化顯存使用。

九、挑戰(zhàn)與展望

挑戰(zhàn)

- 精度與效率的平衡 :在模型壓縮過程中,如何找到一個合適的平衡點,既能顯著減少模型的體積和計算復(fù)雜度,又能保持較高的預(yù)測精度,是一個具有挑戰(zhàn)性的問題。過度的壓縮可能導(dǎo)致模型性能的急劇下降,影響實際應(yīng)用效果。

- 硬件異構(gòu)性與兼容性 :隨著技術(shù)的發(fā)展,市場上出現(xiàn)了多種類型的硬件加速器,如GPU、TPU、FPGA等,它們各自具有不同的架構(gòu)和性能特點。如何設(shè)計出一種能夠跨平臺兼容且高效利用這些硬件資源的推理框架,是一個亟待解決的問題。

- 動態(tài)場景下的優(yōu)化 :在實際應(yīng)用中,大語言模型往往需要處理各種類型的輸入數(shù)據(jù)和任務(wù)需求。如何根據(jù)輸入數(shù)據(jù)的特性和任務(wù)要求,動態(tài)地調(diào)整模型的參數(shù)、結(jié)構(gòu)和推理策略,以實現(xiàn)最優(yōu)的性能表現(xiàn),是一個具有挑戰(zhàn)性的研究方向。

- 隱私保護與安全性 :隨著大語言模型在更多領(lǐng)域的應(yīng)用,數(shù)據(jù)隱私和模型安全成為越來越重要的問題。如何在加速推理的同時,確保用戶數(shù)據(jù)的隱私保護和模型的安全性,是一個需要深入研究的課題。

展望

- 更高效的壓縮與量化技術(shù) :未來,隨著算法和硬件技術(shù)的不斷進步,我們有望看到更高效的模型壓縮與量化技術(shù)。這些技術(shù)將能夠在保持模型性能的同時,進一步減少模型的體積和計算復(fù)雜度,從而實現(xiàn)更快的推理速度。

- 自適應(yīng)的推理框架 :為了應(yīng)對動態(tài)場景下的優(yōu)化需求,未來的推理框架將更加注重自適應(yīng)性和靈活性。這些框架將能夠根據(jù)輸入數(shù)據(jù)的特性和任務(wù)要求,自動調(diào)整模型的參數(shù)、結(jié)構(gòu)和推理策略,以實現(xiàn)最優(yōu)的性能表現(xiàn)。

- 軟硬協(xié)同優(yōu)化 :未來的大語言模型推理加速將更加注重軟硬件的協(xié)同優(yōu)化。通過緊密結(jié)合硬件加速器的特性和軟件算法的優(yōu)化,我們可以實現(xiàn)更加高效的推理過程,從而進一步提升模型的性能表現(xiàn)。

- 隱私保護與安全性的提升 :隨著技術(shù)的不斷發(fā)展,我們將看到更多針對大語言模型隱私保護和安全性的解決方案。這些方案將采用加密技術(shù)、差分隱私、聯(lián)邦學習等方法來保護用戶數(shù)據(jù)的隱私和模型的安全性。

- 跨模態(tài)與多任務(wù)的融合 :未來的大語言模型將不僅僅局限于文本處理領(lǐng)域,而是會向跨模態(tài)(如文本、圖像、語音等)和多任務(wù)方向發(fā)展。這將為模型的推理加速帶來新的挑戰(zhàn)和機遇。通過融合不同模態(tài)的數(shù)據(jù)和任務(wù)需求,我們可以實現(xiàn)更加智能和高效的推理過程。

總之,加速大語言模型推理是一個充滿挑戰(zhàn)和機遇的領(lǐng)域。隨著技術(shù)的不斷進步和應(yīng)用場景的不斷拓展,我們有理由相信,未來的大語言模型將具備更快的推理速度、更高的性能和更廣泛的應(yīng)用前景。

-

人工智能

+關(guān)注

關(guān)注

1796文章

47666瀏覽量

240262 -

模型

+關(guān)注

關(guān)注

1文章

3305瀏覽量

49217 -

GPT

+關(guān)注

關(guān)注

0文章

360瀏覽量

15505

發(fā)布評論請先 登錄

相關(guān)推薦

【大語言模型:原理與工程實踐】揭開大語言模型的面紗

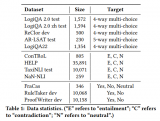

【大語言模型:原理與工程實踐】大語言模型的評測

【大語言模型:原理與工程實踐】大語言模型的應(yīng)用

【《大語言模型應(yīng)用指南》閱讀體驗】+ 基礎(chǔ)知識學習

壓縮模型會加速推理嗎?

HarmonyOS:使用MindSpore Lite引擎進行模型推理

NVIDIA DLI 實戰(zhàn)培訓 | 加速大語言模型開發(fā)的核心技能

FPGA加速器支撐ChatGPT類大語言模型創(chuàng)新

現(xiàn)已公開發(fā)布!歡迎使用 NVIDIA TensorRT-LLM 優(yōu)化大語言模型推理

NVIDIA加速微軟最新的Phi-3 Mini開源語言模型

LLM大模型推理加速的關(guān)鍵技術(shù)

FPGA和ASIC在大模型推理加速中的應(yīng)用

如何加速大語言模型推理

如何加速大語言模型推理

評論