RNN(Recurrent Neural Network)是循環神經網絡,而非遞歸神經網絡。循環神經網絡是一種具有時間序列特性的神經網絡,能夠處理序列數據,具有記憶功能。以下是關于循環神經網絡的介紹:

- 循環神經網絡的基本概念

循環神經網絡是一種具有時間序列特性的神經網絡,它能夠處理序列數據,具有記憶功能。與傳統的前饋神經網絡不同,循環神經網絡在處理序列數據時,不僅考慮當前時刻的輸入,還會考慮之前時刻的輸入信息。這種特性使得循環神經網絡在處理時間序列數據、自然語言處理等領域具有廣泛的應用。

- 循環神經網絡的結構

循環神經網絡的基本結構包括輸入層、隱藏層和輸出層。與傳統的前饋神經網絡不同,循環神經網絡的隱藏層具有循環連接,即隱藏層的輸出會作為下一個時間步的輸入。這種循環連接使得循環神經網絡能夠記憶之前時刻的信息。

循環神經網絡的隱藏層通常使用非線性激活函數,如tanh或ReLU。非線性激活函數能夠增加網絡的表達能力,使得網絡能夠學習更復雜的函數映射。

- 循環神經網絡的工作原理

循環神經網絡的工作原理可以分為以下幾個步驟:

(1)初始化隱藏狀態:在網絡開始處理序列數據之前,需要初始化隱藏狀態。隱藏狀態通常初始化為零向量或隨機向量。

(2)輸入序列數據:將序列數據逐個時間步輸入到網絡中。每個時間步的輸入數據可以是一個向量,表示該時刻的特征。

(3)計算隱藏狀態:根據當前時刻的輸入數據和上一個時間步的隱藏狀態,計算當前時刻的隱藏狀態。隱藏狀態的計算公式如下:

h_t = f(W * x_t + U * h_(t-1) + b)

其中,h_t表示當前時刻的隱藏狀態,x_t表示當前時刻的輸入數據,W和U分別表示輸入到隱藏層和隱藏層到隱藏層的權重矩陣,b表示隱藏層的偏置項,f表示激活函數。

(4)計算輸出:根據當前時刻的隱藏狀態,計算輸出。輸出的計算公式如下:

y_t = g(V * h_t + c)

其中,y_t表示當前時刻的輸出,V表示隱藏層到輸出層的權重矩陣,c表示輸出層的偏置項,g表示輸出層的激活函數。

(5)重復步驟(3)和(4),直到處理完序列數據的所有時間步。

- 循環神經網絡的變體

循環神經網絡有幾種常見的變體,包括長短期記憶網絡(LSTM)和門控循環單元(GRU)。

(1)長短期記憶網絡(LSTM):LSTM是一種特殊的循環神經網絡,它通過引入三個門(輸入門、遺忘門和輸出門)來解決傳統循環神經網絡的梯度消失問題。這三個門可以控制信息的流動,使得網絡能夠學習長距離依賴關系。

(2)門控循環單元(GRU):GRU是另一種特殊的循環神經網絡,它通過引入更新門和重置門來解決梯度消失問題。GRU的結構相對簡單,但在某些任務上與LSTM具有相似的性能。

- 循環神經網絡的應用

循環神經網絡在許多領域都有廣泛的應用,包括:

(1)自然語言處理:循環神經網絡可以用于語言模型、機器翻譯、文本分類等任務。通過學習文本序列中的語義信息,循環神經網絡能夠捕捉到詞語之間的依賴關系。

(2)語音識別:循環神經網絡可以用于語音信號的處理,識別語音中的音素和語義信息。

(3)時間序列預測:循環神經網絡可以用于股票價格、氣象數據等時間序列數據的預測。

(4)視頻處理:循環神經網絡可以用于視頻幀的分析,捕捉視頻中的運動信息。

- 循環神經網絡的訓練和優化

循環神經網絡的訓練通常使用反向傳播算法,即BPTT(Backpropagation Through Time)。BPTT算法通過計算梯度并更新網絡參數來優化網絡性能。

為了解決梯度消失或梯度爆炸問題,可以采用以下策略:

(1)梯度裁剪:限制梯度的最大值,防止梯度爆炸。

(2)權重初始化:使用合適的權重初始化方法,如Glorot初始化或He初始化,有助于緩解梯度消失問題。

(3)激活函數:使用ReLU等非飽和激活函數,可以緩解梯度消失問題。

(4)調整學習率:使用學習率衰減策略,如學習率衰減或自適應學習率方法,可以提高訓練效果。

-

循環神經網絡

+關注

關注

0文章

38瀏覽量

2993 -

自然語言處理

+關注

關注

1文章

619瀏覽量

13646 -

rnn

+關注

關注

0文章

89瀏覽量

6913 -

遞歸神經網絡

+關注

關注

0文章

12瀏覽量

368

發布評論請先 登錄

相關推薦

什么是RNN (循環神經網絡)?

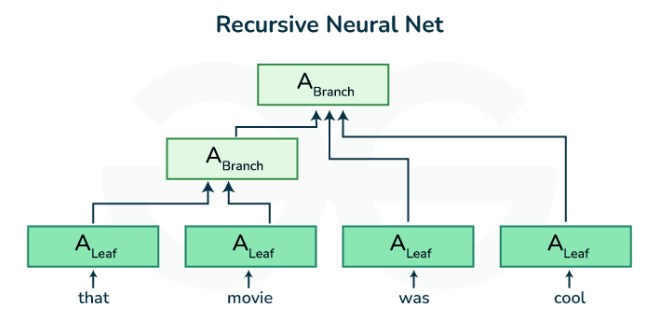

遞歸神經網絡(RNN)

什么是RNN(循環神經網絡)?RNN的基本原理和優缺點

循環神經網絡和遞歸神經網絡的區別

循環神經網絡和卷積神經網絡的區別

循環神經網絡算法原理及特點

遞歸神經網絡是循環神經網絡嗎

rnn神經網絡模型原理

遞歸神經網絡與循環神經網絡一樣嗎

rnn是什么神經網絡

rnn是什么神經網絡模型

遞歸神經網絡的實現方法

遞歸神經網絡和循環神經網絡的模型結構

rnn是遞歸神經網絡還是循環神經網絡

rnn是遞歸神經網絡還是循環神經網絡

評論