作者:Shaoni Mukherjee

編譯:ronghuaiyang,來源:AI公園

導(dǎo)讀

在本文中,我們將探討一種廣泛采用的技術(shù),用于減小大型語言模型(LLM)的大小和計算需求,以便將這些模型部署到邊緣設(shè)備上。這項技術(shù)稱為模型量化。它使得人工智能模型能夠在資源受限的設(shè)備上高效部署。

在當今世界,人工智能和機器學(xué)習的應(yīng)用已成為解決實際問題不可或缺的一部分。大型語言模型或視覺模型因其卓越的表現(xiàn)和實用性而備受關(guān)注。如果這些模型運行在云端或大型設(shè)備上,并不會造成太大問題。然而,它們的大小和計算需求在將這些模型部署到邊緣設(shè)備或用于實時應(yīng)用時構(gòu)成了重大挑戰(zhàn)。

邊緣設(shè)備,如我們所說的智能手表或Fitbits,擁有有限的資源,而量化是一個將大型模型轉(zhuǎn)換為可以輕松部署到小型設(shè)備上的過程。隨著人工智能技術(shù)的進步,模型復(fù)雜度呈指數(shù)增長。將這些復(fù)雜的模型容納在智能手機、物聯(lián)網(wǎng)設(shè)備和邊緣服務(wù)器等小型設(shè)備上是一項重大挑戰(zhàn)。然而,量化是一種減少機器學(xué)習模型大小和計算需求的技術(shù),同時不會顯著犧牲其性能。量化已被證明在提高大型語言模型的內(nèi)存和計算效率方面非常有用,從而使這些強大的模型更加實用和易于日常使用。

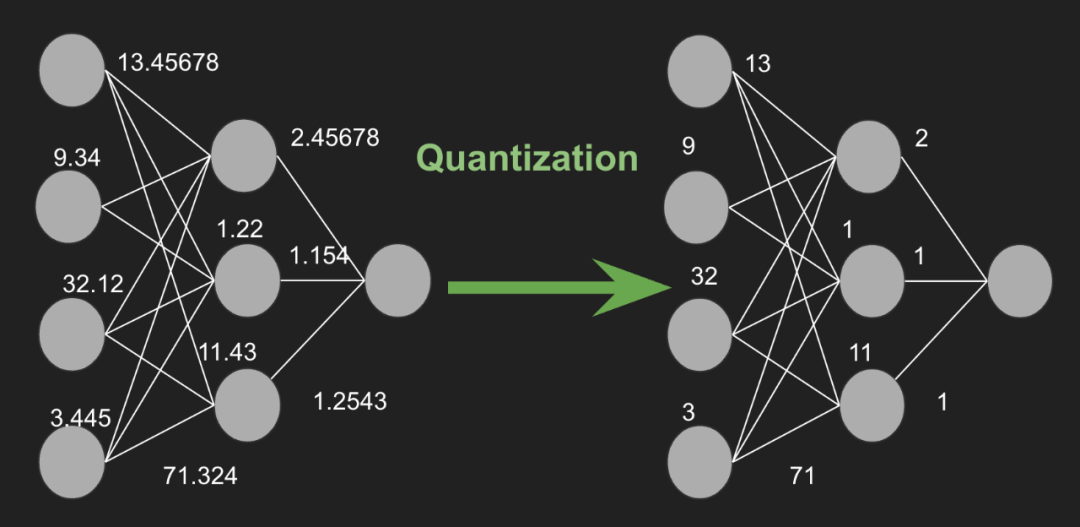

模型量化涉及將神經(jīng)網(wǎng)絡(luò)的參數(shù)(如權(quán)重和激活)從高精度(例如32位浮點數(shù))表示轉(zhuǎn)換為較低精度(例如8位整數(shù))格式。這種精度的降低可以帶來顯著的好處,包括減少內(nèi)存使用、加快推理時間和降低能耗。

什么是模型量化?模型量化的益處

模型量化是一種減少模型參數(shù)精度的技術(shù),從而降低了存儲每個參數(shù)所需的位數(shù)。例如,考慮一個32位精度的參數(shù)值7.892345678,它可以被近似為8位精度下的整數(shù)8。這一過程顯著減小了模型的大小,使得模型能夠在內(nèi)存有限的設(shè)備上更快地執(zhí)行。

除了減少內(nèi)存使用和提高計算效率外,量化還可以降低能耗,這對于電池供電的設(shè)備尤為重要。通過降低模型參數(shù)的精度,量化還能加快推理速度,因為它減少了存儲和訪問這些參數(shù)所需的內(nèi)存。

模型量化有多種類型,包括均勻量化和非均勻量化,以及訓(xùn)練后的量化和量化感知訓(xùn)練。每種方法都有其自身的模型大小、速度和準確性之間的權(quán)衡,這使得量化成為在廣泛的硬件平臺上部署高效AI模型的一個靈活且必不可少的工具。

不同的模型量化技術(shù)

模型量化涉及各種技術(shù)來減少模型參數(shù)的大小,同時保持性能。

以下是幾種常見的技術(shù):

1. 訓(xùn)練后的量化

訓(xùn)練后的量化(PTQ)是在模型完全訓(xùn)練之后應(yīng)用的。PTQ可能會降低模型的準確性,因為在模型被壓縮時,原始浮點值中的一些詳細信息可能會丟失。

- 準確性損失:當PTQ壓縮模型時,可能會丟失一些重要的細節(jié),這會降低模型的準確性。

- 平衡:為了在使模型更小和保持高準確性之間找到合適的平衡,需要仔細調(diào)優(yōu)和評估。這對于那些準確性至關(guān)重要的應(yīng)用尤其重要。

簡而言之,PTQ可以使模型變得更小,但也可能降低其準確性,因此需要謹慎校準以維持性能。

這是一種簡單且廣泛使用的方法,包括幾種子方法:

- 靜態(tài)量化:將模型的權(quán)重和激活轉(zhuǎn)換為較低精度。使用校準數(shù)據(jù)來確定激活值的范圍,這有助于適當?shù)乜s放它們。

- 動態(tài)量化:僅量化權(quán)重,而在推理期間激活保持較高精度。根據(jù)推理時觀察到的范圍動態(tài)量化激活。

2. 量化感知訓(xùn)練

量化感知訓(xùn)練(QAT)將量化集成到訓(xùn)練過程中。模型在前向傳播中模擬量化,使模型能夠?qū)W會適應(yīng)降低的精度。這通常比訓(xùn)練后的量化產(chǎn)生更高的準確性,因為模型能夠更好地補償量化誤差。QAT在訓(xùn)練過程中增加了額外的步驟來模擬模型被壓縮后的表現(xiàn)。這意味著調(diào)整模型以準確處理這種模擬。這些額外步驟和調(diào)整使訓(xùn)練過程更具計算要求。它需要更多的時間和計算資源。訓(xùn)練后,模型需要經(jīng)過徹底的測試和微調(diào),以確保不會失去準確性。這為整個訓(xùn)練過程增加了更多的復(fù)雜性。

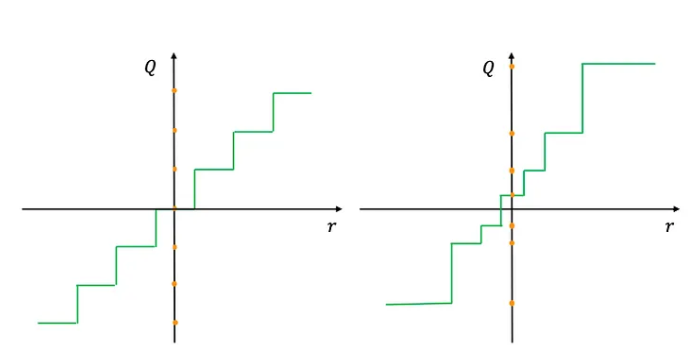

3. 均勻量化

在均勻量化中,值范圍被劃分為等間距的間隔。這是最簡單的量化形式,通常應(yīng)用于權(quán)重和激活。

4. 非均勻量化

非均勻量化為不同的區(qū)間分配不同的大小,通常使用諸如對數(shù)或k均值聚類等方法來確定區(qū)間。這種方法對于參數(shù)具有非均勻分布的情況更為有效,可能在關(guān)鍵范圍內(nèi)保留更多信息。

均勻量化和非均勻量化

5. 權(quán)重共享

權(quán)重共享涉及將相似的權(quán)重聚類,并在它們之間共享相同的量化值。這種技術(shù)減少了唯一權(quán)重的數(shù)量,從而實現(xiàn)了進一步的壓縮。權(quán)重共享量化是一種通過限制大型神經(jīng)網(wǎng)絡(luò)中唯一權(quán)重的數(shù)量來節(jié)省能量的技術(shù)。

益處:

- 抗噪性:該方法更好地處理噪聲。

- 可壓縮性:可以在不犧牲準確性的情況下縮小網(wǎng)絡(luò)的規(guī)模。

6. 混合量化

混合量化在同一模型中結(jié)合了不同的量化技術(shù)。例如,權(quán)重可以被量化到8位精度,而激活則保持較高的精度,或者不同的層可以根據(jù)它們對量化的敏感性使用不同級別的精度。這種技術(shù)通過將量化應(yīng)用于模型的權(quán)重(模型的參數(shù))和激活(中間輸出)來減小神經(jīng)網(wǎng)絡(luò)的大小并加快速度。

- 量化兩個部分:它同時壓縮模型的權(quán)重和計算的數(shù)據(jù)激活。這意味著兩者都使用較少的位數(shù)存儲和處理,從而節(jié)省了內(nèi)存并加快了計算速度。

- 內(nèi)存和速度提升:通過減少模型需要處理的數(shù)據(jù)量,混合量化使得模型更小、更快。

- 復(fù)雜性:因為它同時影響權(quán)重和激活,所以實施起來可能比僅僅量化其中一個更復(fù)雜。它需要精心調(diào)優(yōu)以確保模型在保持高效的同時仍然保持準確性。

7. 僅整數(shù)量化

在僅整數(shù)量化中,權(quán)重和激活都被轉(zhuǎn)換為整數(shù)格式,并且所有計算都使用整數(shù)算術(shù)完成。這種技術(shù)對于優(yōu)化整數(shù)操作的硬件加速器特別有用。

8. 按張量和按通道量化

按張量量化:在整個張量(例如,一層中的所有權(quán)重)上應(yīng)用相同的量化尺度。

按通道量化:在一個張量的不同通道上使用不同的尺度。這種方法可以通過允許卷積神經(jīng)網(wǎng)絡(luò)中的量化更細粒度,從而提供更好的準確性。

9. 自適應(yīng)量化

自適應(yīng)量化方法根據(jù)輸入數(shù)據(jù)分布動態(tài)調(diào)整量化參數(shù)。這些方法通過針對數(shù)據(jù)的具體特征定制量化,有可能達到更高的準確性。

每種技術(shù)都有其在模型大小、速度和準確性之間的權(quán)衡。選擇適當?shù)牧炕椒ㄈQ于部署環(huán)境的具體要求和約束。

模型量化面臨的挑戰(zhàn)與考慮因素

在AI中實施模型量化涉及到應(yīng)對幾個挑戰(zhàn)和考慮因素。主要的問題之一是準確性權(quán)衡,因為減少模型數(shù)值數(shù)據(jù)的精度可能會降低其性能,特別是對于需要高精度的任務(wù)。為了管理這一點,采用的技術(shù)包括量化感知訓(xùn)練、混合方法(結(jié)合不同精度級別)以及量化參數(shù)的迭代優(yōu)化,以保持準確性。此外,不同硬件和軟件平臺之間的兼容性可能存在問題,因為并非所有平臺都支持量化。解決這個問題需要廣泛的跨平臺測試,使用標準化框架(如TensorFlow或PyTorch)以獲得更廣泛的兼容性,有時還需要為特定硬件開發(fā)定制解決方案以確保最佳性能。

實際應(yīng)用案例

模型量化在各種實際應(yīng)用中廣泛使用,其中效率和性能至關(guān)重要。

以下是一些示例:

- 移動應(yīng)用:量化模型用于移動應(yīng)用中的任務(wù),如圖像識別、語音識別和增強現(xiàn)實。例如,量化神經(jīng)網(wǎng)絡(luò)可以在智能手機上高效運行,以識別照片中的目標或提供實時的語言翻譯,即使在計算資源有限的情況下也是如此。

- 自動駕駛汽車:在自動駕駛汽車中,量化模型幫助實時處理傳感器數(shù)據(jù),如識別障礙物、讀取交通標志和做出駕駛決策。量化模型的效率使得這些計算可以快速完成,并且功耗較低,這對于自動駕駛汽車的安全性和可靠性至關(guān)重要。

- 邊緣設(shè)備:量化對于將AI模型部署到無人機、物聯(lián)網(wǎng)設(shè)備和智能攝像頭等邊緣設(shè)備至關(guān)重要。這些設(shè)備通常具有有限的處理能力和內(nèi)存,因此量化模型使它們能夠高效地執(zhí)行復(fù)雜的任務(wù),如監(jiān)控、異常檢測和環(huán)境監(jiān)測。

- 醫(yī)療保健:在醫(yī)學(xué)影像和診斷中,量化模型用于分析醫(yī)學(xué)掃描和檢測異常,如腫瘤或骨折。這有助于在硬件計算能力有限的情況下提供更快、更準確的診斷,例如便攜式醫(yī)療設(shè)備。

- 語音助手:數(shù)字語音助手如Siri、Alexa和Google Assistant使用量化模型處理語音命令、理解自然語言并提供響應(yīng)。量化使這些模型能夠在家庭設(shè)備上快速高效地運行,確保順暢且響應(yīng)迅速的用戶體驗。

- 推薦系統(tǒng):在線平臺如Netflix、Amazon和YouTube使用量化模型提供實時推薦。這些模型處理大量用戶數(shù)據(jù)以建議電影、產(chǎn)品或視頻,量化有助于管理計算負載,同時及時提供個性化推薦。

量化提高了AI模型的效率,使它們能夠在資源受限的環(huán)境中部署,而不顯著犧牲性能,從而改善了廣泛應(yīng)用中的用戶體驗。

總結(jié)思考

量化是人工智能和機器學(xué)習領(lǐng)域的一項關(guān)鍵技術(shù),解決了將大型模型部署到邊緣設(shè)備的挑戰(zhàn)。量化顯著減少了神經(jīng)網(wǎng)絡(luò)的內(nèi)存占用和計算需求,使它們能夠在資源受限的設(shè)備和實時應(yīng)用中部署。正如本文討論的,量化的一些好處包括減少內(nèi)存使用、加快推理時間和降低功耗。技術(shù)如均勻量化和非均勻量化,以及創(chuàng)新方法如權(quán)重共享和混合量化。盡管量化具有優(yōu)勢,但也帶來了挑戰(zhàn),特別是在保持模型準確性方面。然而,隨著近期的研究和量化方法的發(fā)展,研究人員繼續(xù)致力于解決這些問題,推動低精度計算的可能性邊界。隨著深度學(xué)習社區(qū)不斷創(chuàng)新發(fā)展,量化將在部署強大且高效的AI模型中扮演關(guān)鍵角色,使先進的AI功能能夠廣泛應(yīng)用于更多的應(yīng)用場景和設(shè)備。總之,量化不僅僅是技術(shù)優(yōu)化那么簡單——它在AI進步中扮演著至關(guān)重要的角色。

-

人工智能

+關(guān)注

關(guān)注

1796文章

47683瀏覽量

240311 -

語言模型

+關(guān)注

關(guān)注

0文章

538瀏覽量

10342 -

LLM

+關(guān)注

關(guān)注

0文章

299瀏覽量

400

發(fā)布評論請先 登錄

相關(guān)推薦

小白學(xué)大模型:構(gòu)建LLM的關(guān)鍵步驟

一種信息引導(dǎo)的量化后LLM微調(diào)新算法IR-QLoRA

什么是LLM?LLM在自然語言處理中的應(yīng)用

如何訓(xùn)練自己的LLM模型

【飛凌嵌入式OK3576-C開發(fā)板體驗】rkllm模型量化構(gòu)建

LLM大模型推理加速的關(guān)鍵技術(shù)

深度學(xué)習模型量化方法

理解LLM中的模型量化

理解LLM中的模型量化

評論