作者:京東零售 陳航

0000 生成式推薦系統優勢介紹

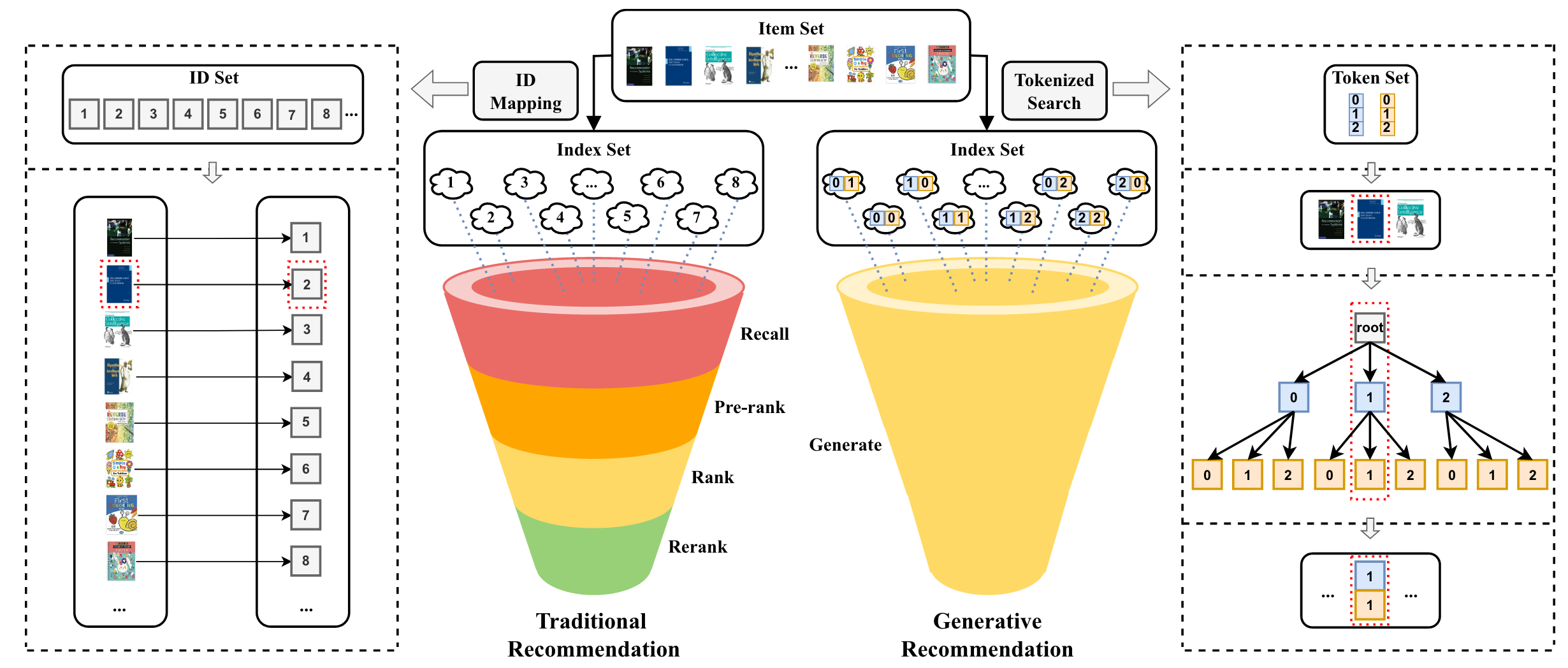

推薦系統的主要任務是根據用戶的歷史行為預測其興趣點,并向其推薦相應的商品。傳統的推薦系統在處理用戶請求時,會觸發多個召回模塊(包括熱門商品召回、個性化召回、深度召回等),以召回大量候選商品。隨后,系統通過相對簡單的粗排模型對候選集進行初步篩選,縮小候選范圍,最后通過精排和重排模型,確定最終返回給用戶的推薦結果。

隨著大語言模型(LLM)在推薦系統中的應用,生成式推薦系統相比傳統推薦系統展現出以下優勢:

1)簡化推薦流程:生成式推薦系統實現了從多級過濾的判別式(discriminative-based)架構向單級過濾的生成式(generative-based)架構的轉變。通過直接生成推薦結果,簡化了推薦流程,降低了系統復雜度。

2)知識融合:LLM 具有更強的泛化能力和穩定性。利用 LLM 所包含的世界知識和推理能力,可以突破傳統電子商務平臺在商品和用戶建模中存在的數據局限性。在新用戶和新商品的冷啟動以及新領域的推薦場景中,生成式推薦系統能夠提供更優的推薦效果和更好的遷移性能。

3)規模定律 (Scaling Law):傳統的點擊率(CTR)稀疏模型在模型規模擴大時,邊際收益遞減現象明顯。而 LLM 所表現出的規模定律屬性,為模型的有效擴展提供了一種新模式,即模型性能隨著規模的增加而持續提升。這意味著通過擴大模型規模,可以獲得更好的推薦效果,突破傳統模型的性能瓶頸。

0001 生成式召回方案介紹

1、生成式召回算法與實現簡介

生成式推薦涉及兩個接地(grounding)過程:一是建立商品與自然語言的連接。二是建立用戶行為與目標商品之間的連接。為實現這兩個過程,我們需要以下幾步:

1)商品表示:在實際操作中,直接生成文檔或商品描述幾乎是不可行的。因此,我們采用短文本序列,即語義 ID,來表征商品。選取高點擊商品的標題、類目等語義信息,經由編碼器模型獲得向量表示,再利用 RQ-VAE 對向量進行殘差量化,從而獲得商品的語義 ID。例如,商品:“XXX品牌 14+ 2024 14.5 英寸輕薄本 AI 全能本高性能獨顯商務辦公筆記本電腦” 可表示為:。

2)用戶畫像&行為建模:通過構建提示詞來定義任務,并將用戶相關信息(例如用戶畫像和用戶歷史行為數據)轉化為文本序列。例如:“用戶按時間順序點擊過這些商品:,, 你預測用戶下一個可能點擊的商品是? ”。

3)模型訓練:確定了生成模型的輸入(用戶表示)和輸出(商品物料標識符),即可基于生成式 Next Token Prediction 任務進行模型訓練。

4)模型推理:經過訓練后,生成模型能夠接收用戶信息并預測相應的商品語義 ID,這些語義標識可以對應數據集中的實際商品 ID。

(了解詳細算法方案請參考: 生成式推薦系統與京東聯盟廣告-綜述與應用 。 )

2、LLM 模型部署的工程適配

傳統基于深度學習的召回模型,其參數量通常在幾十萬到幾千萬之間,且模型結構以Embedding層為主。而采用大語言模型(LLM)實現的生成式召回模型,其參數規模大幅提升至0.5B至7B之間,模型結構主要由Dense網絡構成。由于參數量的急劇增加,LLM在推理過程中所需的計算資源相比傳統模型顯著提升,通常高出數十倍甚至上百倍。這使得LLM在處理復雜任務時具備更強的表現力,但同時也對計算能力有了更高的要求。

將如此龐大的算力模型部署至線上環境,并確保其滿足毫秒級實時響應的需求,同時在嚴格控制資源成本的前提下實現工業化應用,這無疑是對工程能力的巨大考驗。因此,我們必須對在線推理架構進行極致的性能優化。

3、基于 TensorRT-LLM 的 LLM 構建優化及其系統部署

· 在建模封裝層,通過 TensorRT-LLM 實現 LLM 模型的構建與優化。然后將 LLM 無縫整合至現有生態系統,利用 Python 與 TensorFlow API 實現端到端推理圖的構建。基于 TensorFlow 原生算子及現有業務的自定義 TensorFlow 算子庫(例如用戶行為特征處理算子),實現算法的靈活建模。

· 在推理優化層,通過應用 Inflight Batching、Constrained Sampling、Flash Attention 及 Paged Attention 等加速方案,最大限度地提升單卡吞吐量并降低推理延遲。

· 在系統部署方面,為了最大化利用時間資源,生成式召回的部署采用了與傳統多分支召回模塊并行的方式。由于生成式召回簡化了推理流程,相較于傳統召回方式,其資源消耗更少,運行時間更短,并且取得了優異的召回效果。

4、生成式召回在推薦及搜索場景應用效果

目前,生成式召回已在京東廣告推薦場景及搜索場景等業務線成功實施。在推薦場景,借助生成式模型的參數規模及語義理解優勢,AB 實驗結果顯示商品點擊率與消費帶來了顯著的提升。在搜索場景,通過 LLM 所具備的語義理解能力,顯著提升了對查詢與商品的認知能力,特別是在處理搜索中的長尾查詢時,填充率有明顯提升,AB 實驗同樣取得了點擊率與消費幾個點的收益增長。

0010 推理優化加速: 實現降低延遲、提升吞吐

在線推理基于Nvidia TensorRT-LLM, 通過使用 TensorRT-LLM 中的多種優化特性,并針對廣告生成式召回業務場景進行深度定制優化后, 不僅模型推理延遲達到線上業務要求, 同時吞吐也有著顯著提升。

在 NVIDIA GPU 上進行的測試中,通過對比 TensorRT-LLM 與基線,發現在限制 100 毫秒推理耗時的廣告場景下,采用 TensorRT-LLM 進行推理,疊加針對業務的定制優化后,其吞吐量相較于 baseline提升了五倍以上。這相當于將部署成本降至原來的五分之一。

對于這個特定的應用場景,beam width 的合理配置對檢索結果有著重要影響。一般來說,較高的 beam width 能夠增加候選商品的數量,從而提高檢索的準確性。以返回 300 個商品為例,若 beam width 設置較低,每個 code 就需要對應更多的商品 id,這無疑會降低檢索的精度。

針對這個情況,一方面我們與NVIDIA DevTech 技術團隊合作進行了有針對性的二次開發和優化工作,另一方面,結合生成式召回的業務場景,研發定制高性能GPU算子,大幅提升推理效率,最終讓 TensorRT-LLM 支持更大范圍的 beam width, 從而及時滿足了線上的業務需求。

0011 持續優化以實現模型效率效果提升

未來, 我們將持續在生成式推薦領域深入探索, 重點聚焦以下幾個方面

1)提升模型規模,滿足實時推理需求

當前,受制于算力、時間消耗和成本等客觀條件,生成式推薦系統在實時推理中的可部署模型規模相對較小(約 0.5B 至 6B 參數)。然而,離線實驗數據表明,擴大模型規模能夠顯著提升線上推薦效果。這對在線性能優化提出了更高要求。為了在不顯著增加成本的前提下支持更大規模的模型在線部署,需要進一步優化模型結構和推理效率。例如,采用模型剪枝、量化等模型壓縮技術,優化采樣檢索算法效率,以及高效的分布式推理架構。

2)擴展用戶行為輸入,提高模型效果

實驗證明,輸入更長的用戶歷史行為序列可以提升模型的推薦效果。然而,更長的序列輸入會導致計算資源消耗的增加和推理時間的延長。為此,需要尋求在效果提升和性能開銷之間的平衡。對應的優化方案包括:

a. Token 序列壓縮:通過對輸入序列進行壓縮,如去除冗余信息、合并相似行為等,減少序列長度的同時保留關鍵信息。

b. 用戶行為 KV 緩存復用:在推理過程中,針對用戶行為特征有序遞增的特點,對長期行為進行離線計算并進行緩存,在線部分負責計算實時行為,避免重復計算的同時最大化利用算力,提高推理效率。

3)融合稀疏與稠密模型,實現聯合推理

隨著模型參數量的增大,可以考慮將稀疏的傳統 CTR 模型與稠密的 LLM 模型進行聯合推理。稀疏模型擅長處理高維度的稀疏特征,具有計算效率高的優勢;而稠密模型能夠捕獲復雜的非線性特征和深層次的語義信息。通過融合兩者的優勢,構建一個兼具高效性和精確性的推薦系統。

審核編輯 黃宇

-

NVIDIA

+關注

關注

14文章

5076瀏覽量

103714 -

LLM

+關注

關注

0文章

299瀏覽量

398

發布評論請先 登錄

相關推薦

在NVIDIA TensorRT-LLM中啟用ReDrafter的一些變化

解鎖NVIDIA TensorRT-LLM的卓越性能

NVIDIA TensorRT-LLM Roadmap現已在GitHub上公開發布

NVIDIA助力Amdocs打造生成式AI智能體

TensorRT-LLM低精度推理優化

NVIDIA在加速計算和生成式AI領域的創新

NVIDIA Nemotron-4 340B模型幫助開發者生成合成訓練數據

京東廣告生成式召回基于 NVIDIA TensorRT-LLM 的推理加速實踐

京東廣告生成式召回基于 NVIDIA TensorRT-LLM 的推理加速實踐

評論