訓(xùn)練方法與推理策略

性能評(píng)測(cè)體系

現(xiàn)存挑戰(zhàn)與未來方向

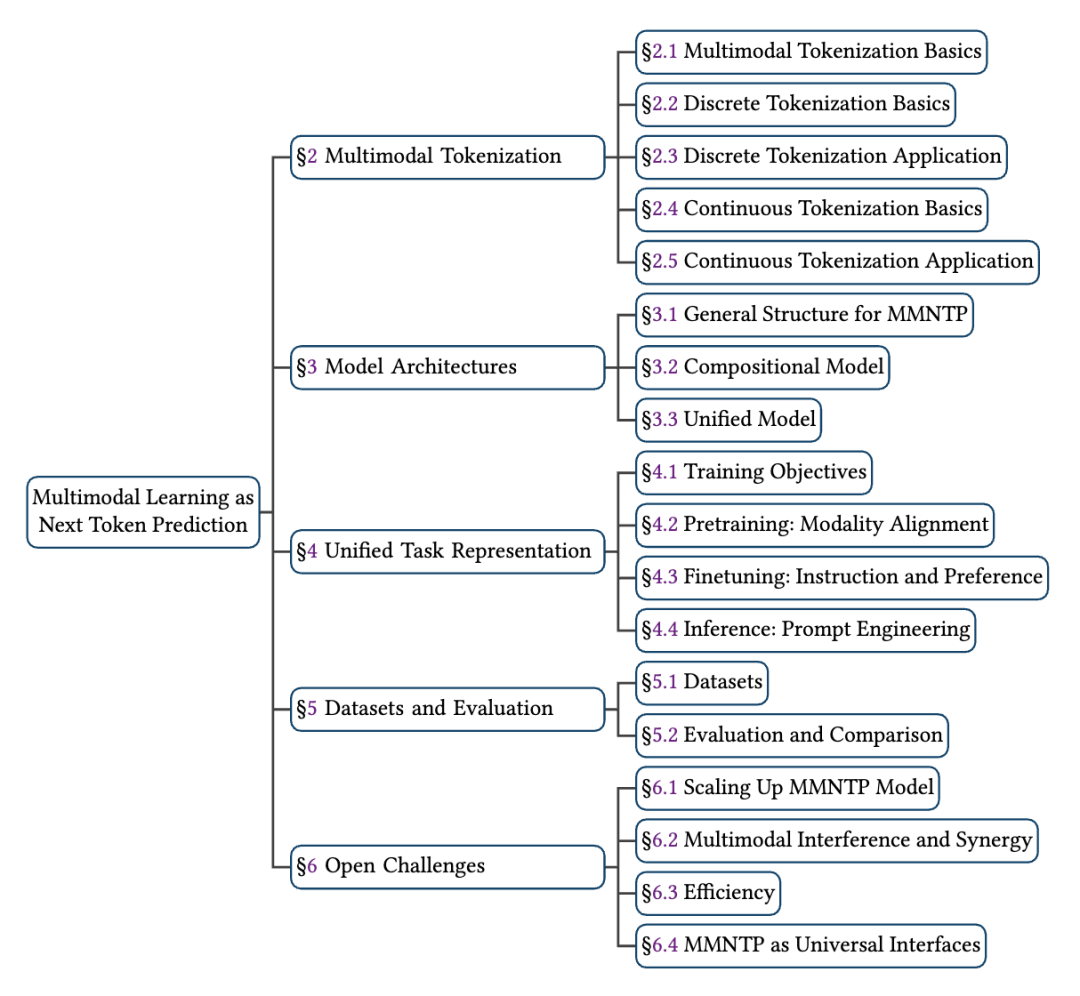

綜述的完整目錄如下:

多模態(tài)的 Tokenization

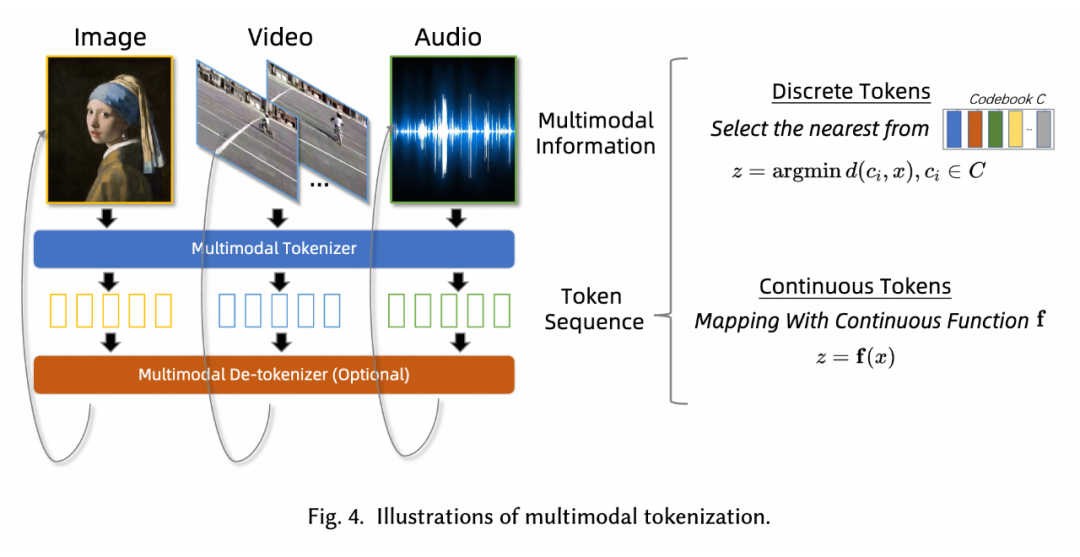

我們認(rèn)為多模態(tài)的 Tokenization 是 MMNTP 的基石和最重要的部分,它將各種模態(tài)的信息(如圖像、視頻和音頻片段)分解為最小的單元序列(Token),以便 Transformer 結(jié)構(gòu)為基礎(chǔ)的 NTP 模型學(xué)習(xí)。

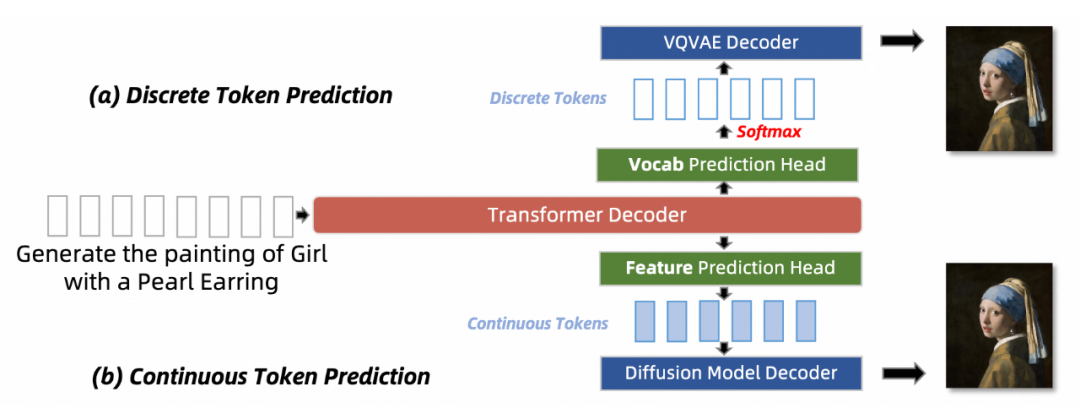

Tokenization 方法可以分為離散(Discrete Tokenization)和連續(xù)(Continuous Tokenization)兩種。離散標(biāo)記化通過量化將原始信息映射到有限的離散空間,而連續(xù)標(biāo)記化則不涉及量化,保留了數(shù)據(jù)的連續(xù)性質(zhì)。下面的圖給出了兩種方式的示意圖。

2.1 Tokenizer 訓(xùn)練方法

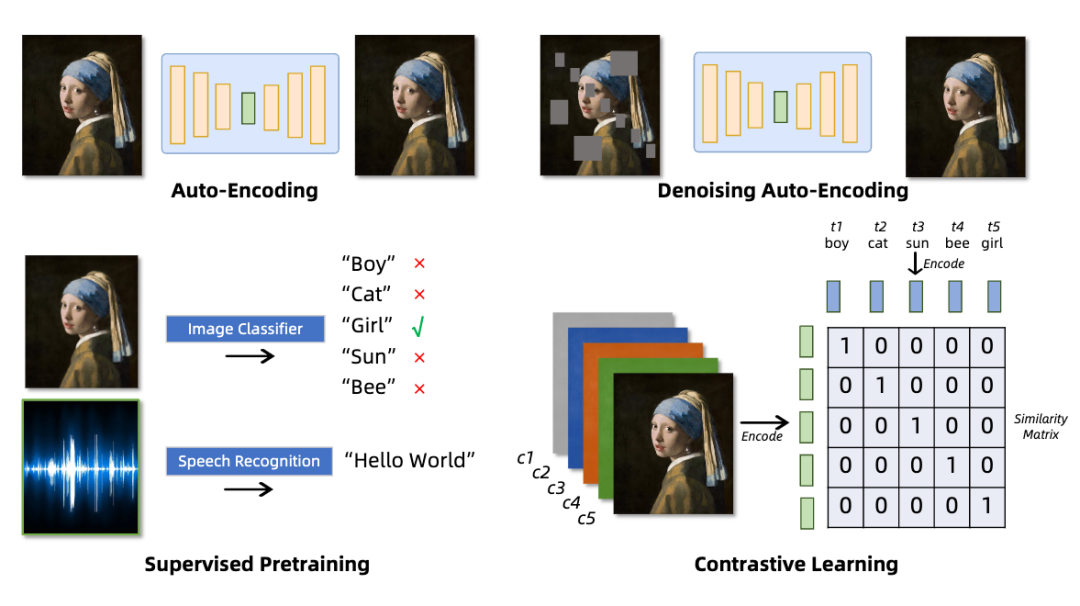

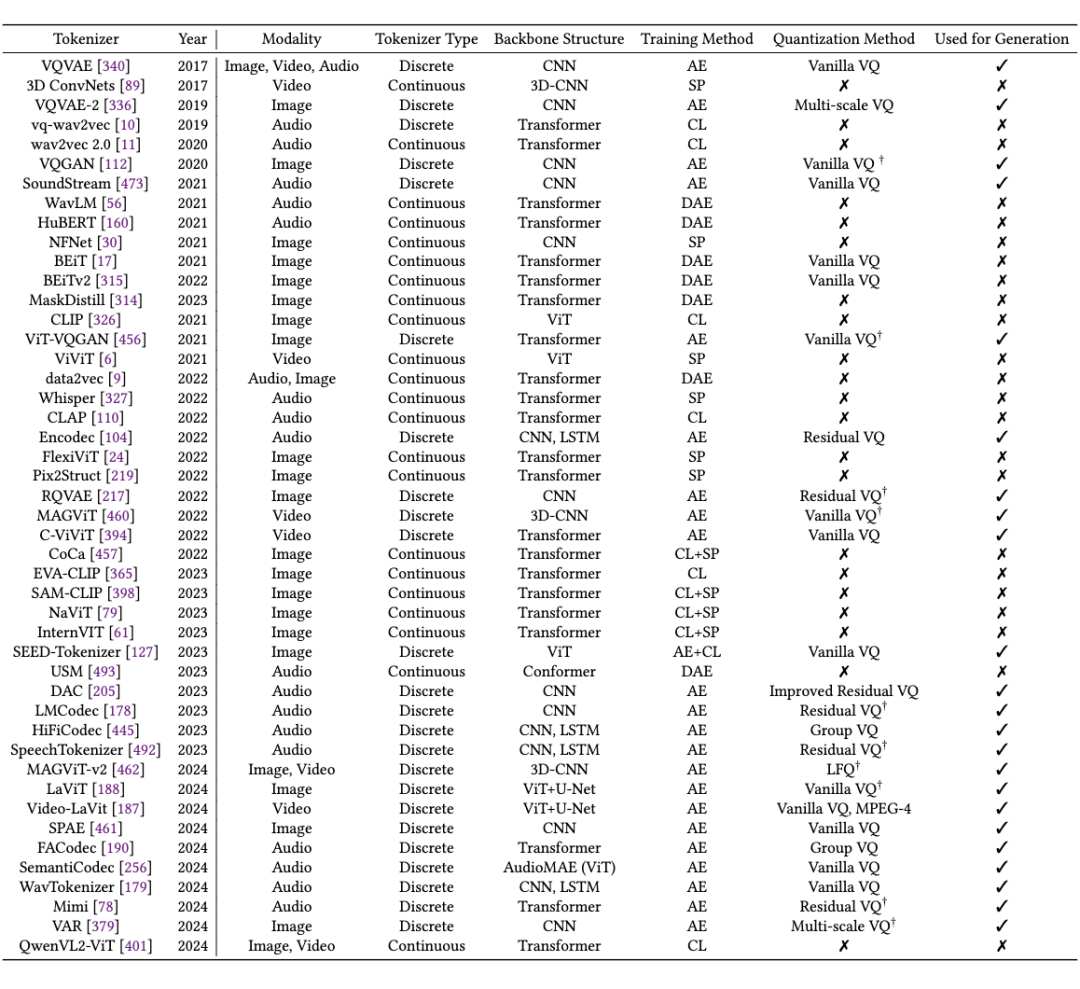

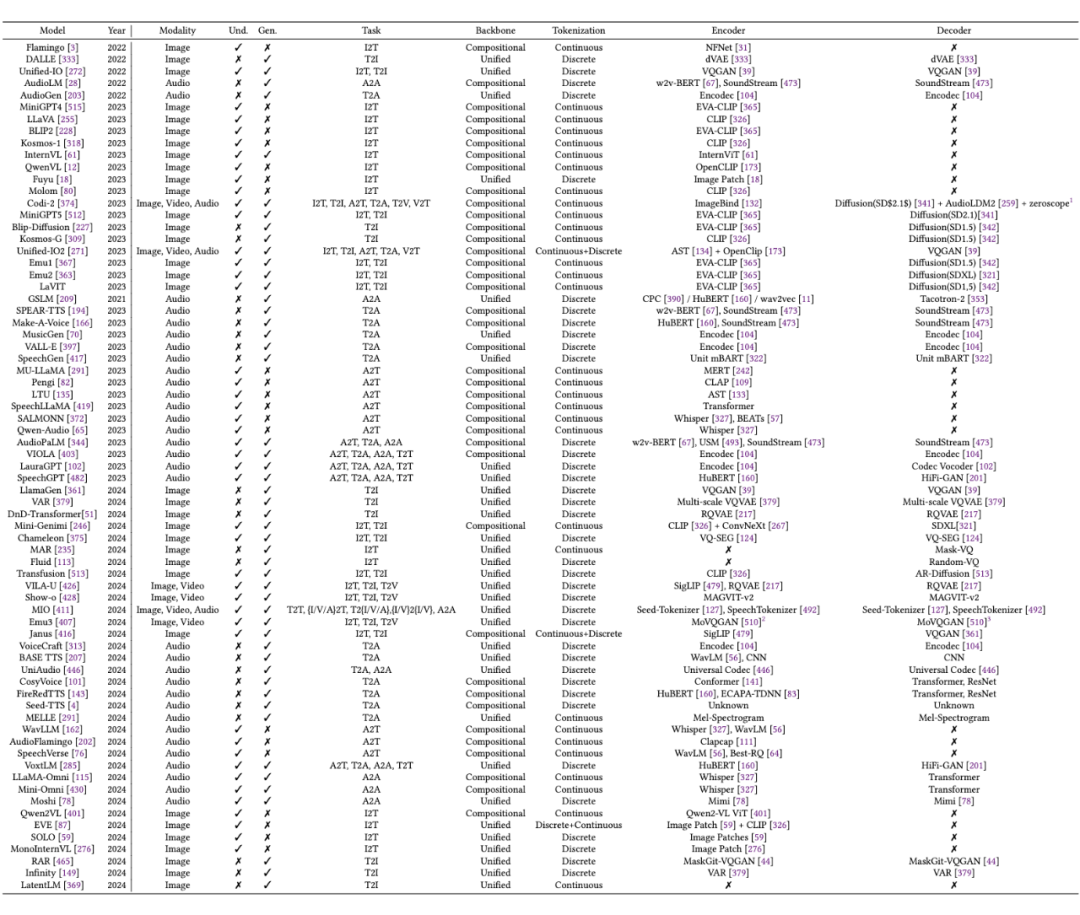

本節(jié)針對(duì)圖片,視頻,音頻領(lǐng)域的 Tokenization 訓(xùn)練方法進(jìn)行了詳細(xì)的梳理和比較。首先總結(jié)了幾種常見的訓(xùn)練方法,例如對(duì)比學(xué)習(xí),自編碼器等,以及這些方法在不同模態(tài)上的應(yīng)用與針對(duì)不同模態(tài)特點(diǎn)的改進(jìn),并按照不同的訓(xùn)練方法歸納整理了不同類型的 Tokenizers,如下表所示:

我們以表示能力(representation)和重建能力(reconstruction)為基點(diǎn),重點(diǎn)討論了 Tokenizers 在訓(xùn)練時(shí)存在的挑戰(zhàn),例如離散型編碼器存在的編碼表塌陷,信息損失的問題以及一些改進(jìn)措施例如 FSQ,LFQ 等方案,以及以 CLIP 為代表的連續(xù)型編碼器中主要存在的語義對(duì)齊,編碼效率,以及對(duì)于不同模態(tài)的數(shù)據(jù),大家提出了哪些針對(duì)性的改進(jìn)措施。

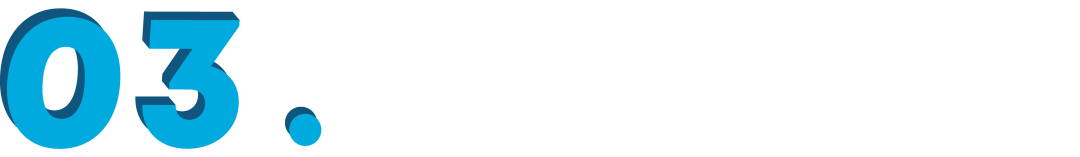

MMNTP 模型

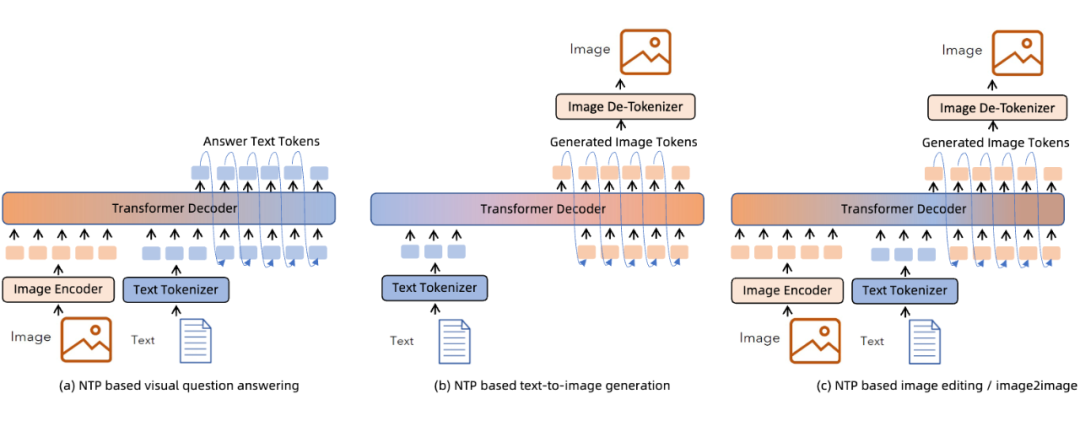

MMNTP 模型一般結(jié)構(gòu)如上圖所示,它主要由骨干模型(一般是一個(gè) Transformer 模型),以及不同模態(tài)的 Tokenizer 與 De-Tokenizer 組成。Tokenizer將不同模態(tài)的信息轉(zhuǎn)換為 Token 序列,De-Tokenizer 則將 Token 序列轉(zhuǎn)換為原始模態(tài)的信息。

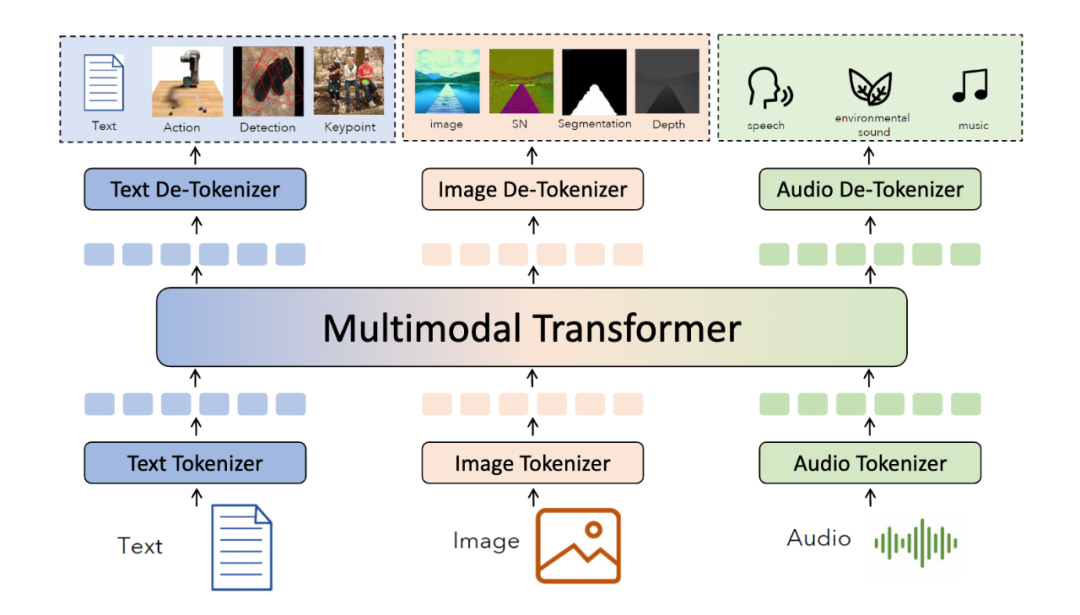

如上圖所示,我們將 MMNTP 模型進(jìn)一步分為兩類,組合式(Compositional)和統(tǒng)一(Unified)式。組合模型依賴于強(qiáng)大的外部編碼器例如 CLIP 和解碼器例如 SD3 來理解和生成多模態(tài)信息,而統(tǒng)一模型則使用輕量級(jí)的編碼器和解碼器例如 VQVAE,將大部分理解和生成任務(wù)交給骨干模型。本文對(duì)這兩種模型結(jié)構(gòu)進(jìn)行了詳細(xì)討論,并比較了它們的優(yōu)缺點(diǎn)。

對(duì)于不同的多模態(tài)任務(wù)來說,MMNTP 模型可以以一種統(tǒng)一的方式處理不同任務(wù),區(qū)別之處在于不同任務(wù)的輸入輸出不同。上圖以圖片模態(tài)為例子,列出來了同一個(gè) MMNTP 模型結(jié)構(gòu)如何進(jìn)行圖片理解例如 VQA,圖片生成,以及基于文字指令的圖片編輯任務(wù)。

只需要替換輸入輸出的組合形式,同一個(gè)模型架構(gòu)就可以完成不同的任務(wù),這體現(xiàn)了 MMNTP 模型在多模態(tài)任務(wù)上的統(tǒng)一性。本文針對(duì)圖片,視頻,音頻模態(tài)的 MMNTP 模型進(jìn)行了詳細(xì)的討論,并根據(jù)結(jié)構(gòu)類型進(jìn)行了梳理,如下表所示。

訓(xùn)練范式

4.1 訓(xùn)練任務(wù)的類型

一旦將不同模態(tài)的內(nèi)容轉(zhuǎn)化為序列化的標(biāo) Tokens,就可以使用統(tǒng)一的骨 MMNTP 模型來訓(xùn)練,以解決各種理解和生成任務(wù)。

本文將訓(xùn)練任務(wù)按照生成的 Token 類型不同分為兩類,離散 Token 預(yù)測(cè)和連續(xù) Token 預(yù)測(cè)。二者的區(qū)別在于預(yù)測(cè)的 token 是離散的還是連續(xù)的,這會(huì)對(duì)應(yīng)不同的訓(xùn)練任務(wù),以及特殊的輸出頭的結(jié)構(gòu)。

例如多模態(tài)理解任務(wù)往往以語言作為輸出,則需要使用語言模型頭作為輸出頭,進(jìn)行離散 Token 預(yù)測(cè)。如果將 Diffusion 模型和 NTP 模型結(jié)合,則需要使用 Diffusion 模型頭作為輸出頭,進(jìn)行連續(xù) Token 預(yù)測(cè)。

4.2 訓(xùn)練階段

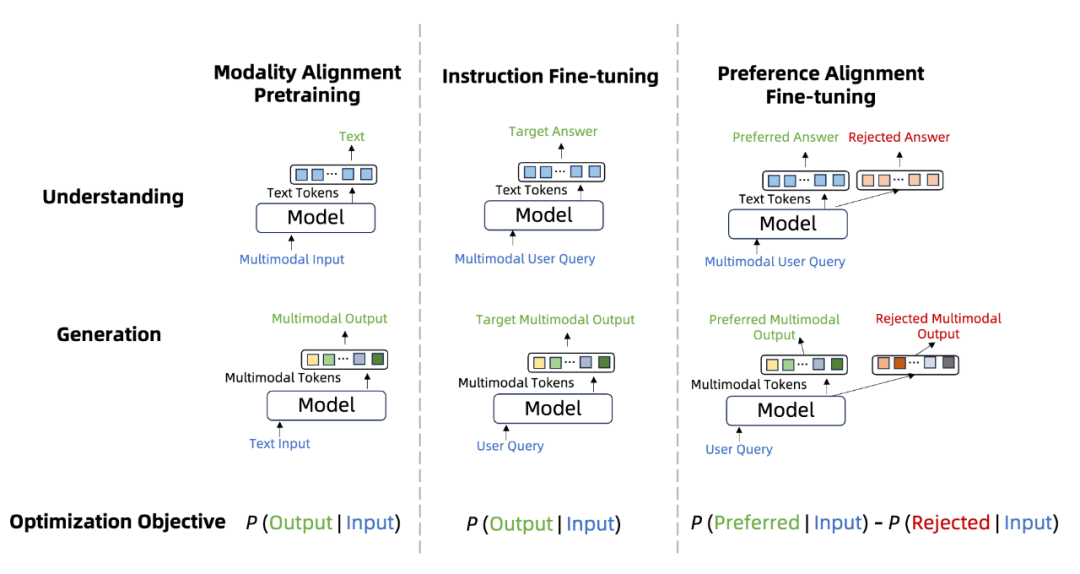

和語言模型類似,MMNTP 模型的訓(xùn)練也可以分為三個(gè)階段,如上圖所示,分別是模態(tài)對(duì)齊預(yù)訓(xùn)練,指令微調(diào)和偏好學(xué)習(xí)。

這里的預(yù)訓(xùn)練階段,通常指的是在多模態(tài)數(shù)據(jù)-文本對(duì)數(shù)據(jù)上進(jìn)行預(yù)訓(xùn)練,以將不同模態(tài)的信息對(duì)齊到語言空間。指令微調(diào)階段是針對(duì)不同的下游任務(wù),例如理解和生成類任務(wù),用標(biāo)注好的數(shù)據(jù)進(jìn)行訓(xùn)練。偏好學(xué)習(xí)在 MMNTP 模型中的研究剛剛起步,主要將模型的輸出和人類的偏好進(jìn)行對(duì)齊。

本文詳細(xì)這三個(gè)階段的相關(guān)研究工作,并根據(jù)任務(wù)類型進(jìn)行了歸納整理。

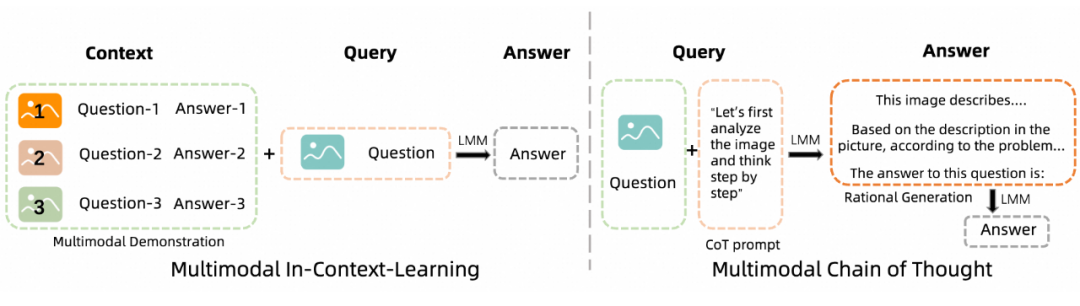

4.3 測(cè)試時(shí)的Prompt工程

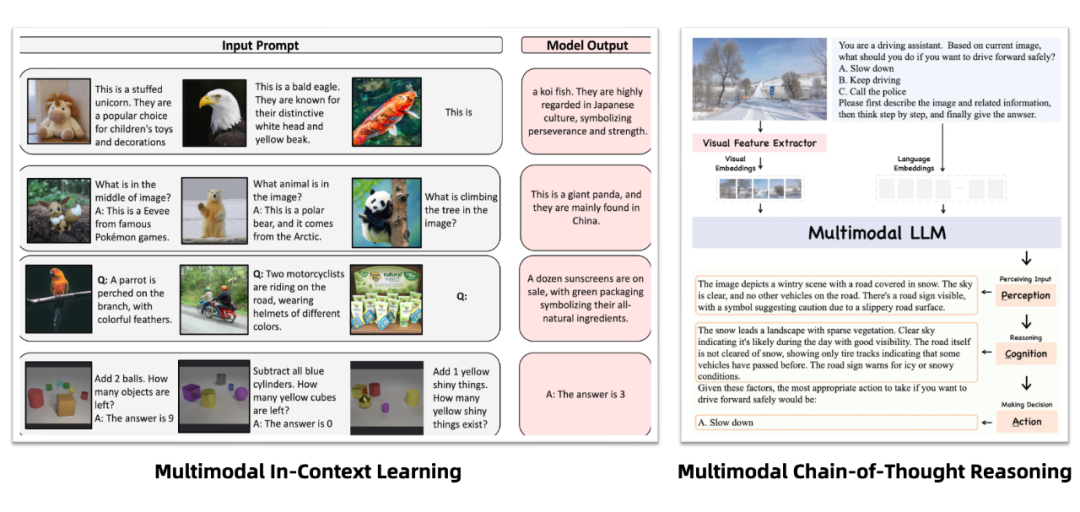

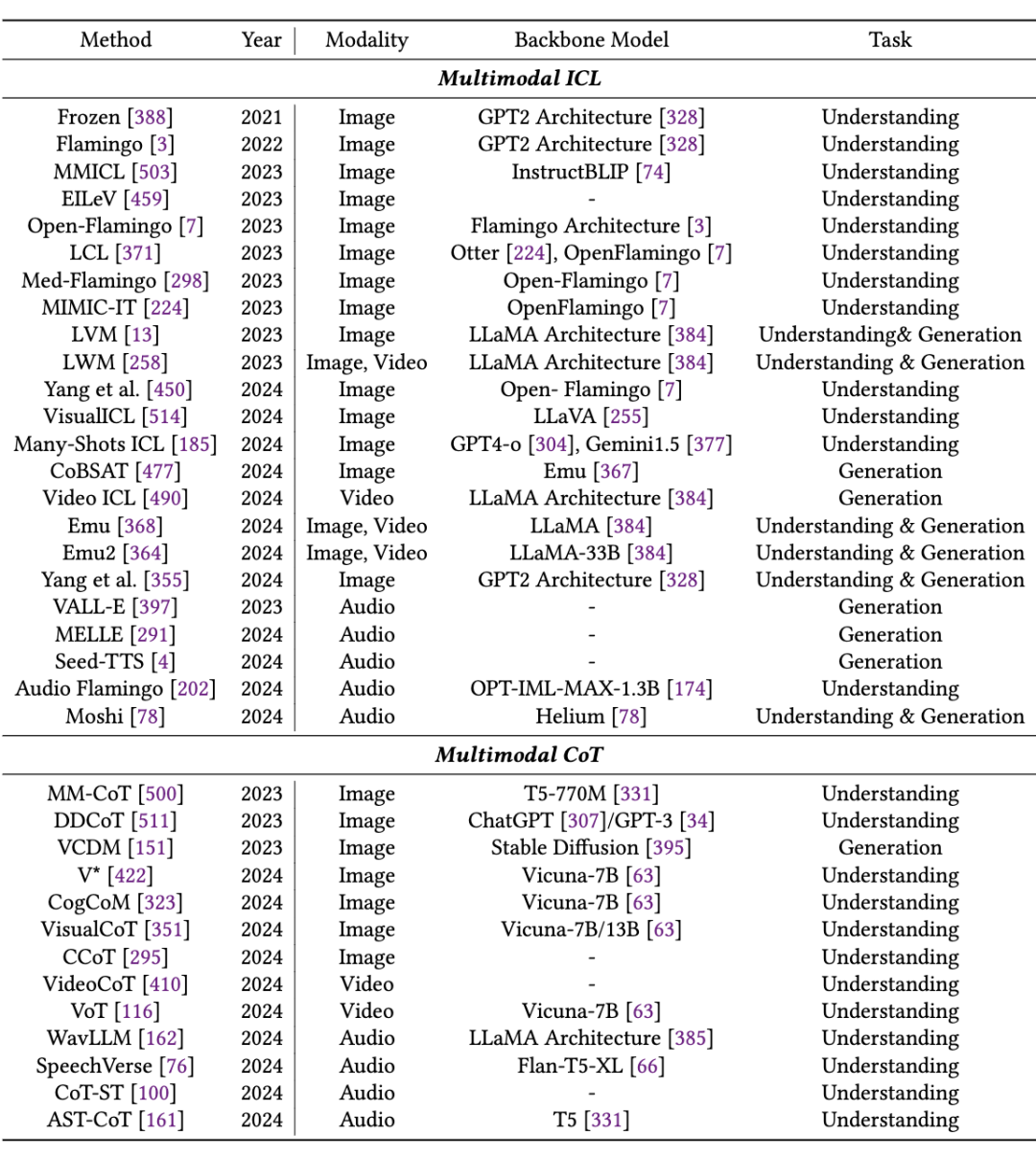

Prompt 工程是提升 LLM 模型效果的重要手段,在 MMNTP 模型中,借助了 LLM 繼基座模型的能力,Prompt 工程同樣重要。本文對(duì) MMNTP 模型中的 Prompt 工程進(jìn)行了詳細(xì)的討論,如上圖所示,分為多模態(tài)的上下文學(xué)習(xí)(Multimodal In-Context Learning)和多模態(tài)思維鏈(Multimodal Chain-of-Thought)兩種方法。

如上圖所示,多模態(tài)的上下文學(xué)習(xí)指的是在輸入中加入多模態(tài)任務(wù)的例子,以幫助模型更好地理解任務(wù)。多模態(tài)思維鏈則是指在輸入中加入一些思維鏈的提示,例如“感知”,“推理過程”等,以促使模型更好地進(jìn)行多模態(tài)推理。我們將這些方法進(jìn)行整理,如下表所示。

訓(xùn)練數(shù)據(jù)集與性能評(píng)測(cè)

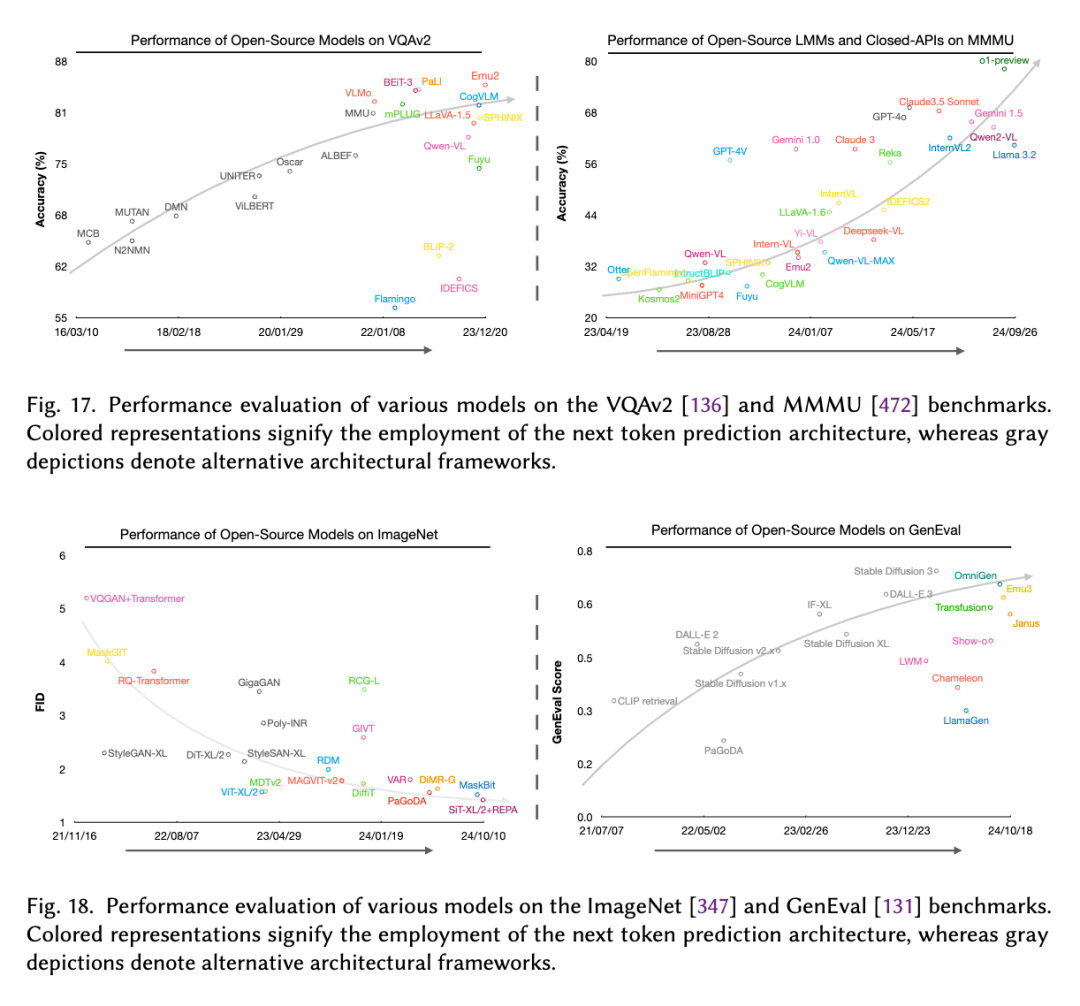

在綜述中,我們還對(duì) MMNTP 模型的訓(xùn)練數(shù)據(jù)集進(jìn)行了詳細(xì)的討論,包括數(shù)據(jù)集的構(gòu)建,數(shù)據(jù)集的規(guī)模,以及數(shù)據(jù)集的多樣性。同時(shí),我們也比較了 NTP 模型和非 NTP 模型在多模態(tài)任務(wù)上的表現(xiàn),如上圖所示,在大規(guī)模理解任務(wù)例如 VQAv2,MMMU上,NTP 模型表現(xiàn)全面優(yōu)于非 NTP 模型。

在生成任務(wù)評(píng)測(cè)數(shù)據(jù)例如 Imagenet,GenEval,我們觀察到 NTP 模型在和純 Diffusion 取得了不相上下的效果,甚至在某些任務(wù)上表現(xiàn)更好,這展示了 NTP 模型在統(tǒng)一不同多模態(tài)任務(wù)上的潛力。

存在的挑戰(zhàn)

本文提出了四個(gè)目前尚未解決的挑戰(zhàn),主要源于 MMNTP 訓(xùn)練范式。這些挑戰(zhàn)包括:

如何更好地利用無監(jiān)督的多模態(tài)數(shù)據(jù)來擴(kuò)展 MMNTP 模型

克服多模態(tài)干擾并增強(qiáng)協(xié)同作用

提高 MMNTP 模型的訓(xùn)練和推理效率

將 MMNTP 作為更廣闊任務(wù)的通用接口。

這些挑戰(zhàn)的解決對(duì)于 MMNTP 范式實(shí)現(xiàn)多模態(tài)智能的發(fā)展至關(guān)重要。

-

編碼器

+關(guān)注

關(guān)注

45文章

3667瀏覽量

135235 -

NTP

+關(guān)注

關(guān)注

1文章

180瀏覽量

13962

原文標(biāo)題:2025年Next Token Prediction范式會(huì)統(tǒng)一多模態(tài)嗎?

文章出處:【微信號(hào):tyutcsplab,微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

2025年,多地籌謀集成電路產(chǎn)業(yè)

電子發(fā)燒友社區(qū)2025年春節(jié)放假通知!

麻省理工科技評(píng)論:2025年AI領(lǐng)域突破性技術(shù)

商湯日日新多模態(tài)大模型權(quán)威評(píng)測(cè)第一

2025電子設(shè)計(jì)與制造技術(shù)研討會(huì)

一文理解多模態(tài)大語言模型——下

一文理解多模態(tài)大語言模型——上

利用OpenVINO部署Qwen2多模態(tài)模型

Meta發(fā)布多模態(tài)LLAMA 3.2人工智能模型

云知聲推出山海多模態(tài)大模型

統(tǒng)一多云管理平臺(tái)怎么用?

李未可科技正式推出WAKE-AI多模態(tài)AI大模型

2025年Next Token Prediction范式會(huì)統(tǒng)一多模態(tài)嗎

2025年Next Token Prediction范式會(huì)統(tǒng)一多模態(tài)嗎

評(píng)論