本文詳細對比了谷歌TPU2和英偉達V100的性能,有兩個對比方向:一是測試在沒有增強過的合成數(shù)據(jù)上的吞吐量(每秒圖像);二是,考察ImageNet上兩者實現(xiàn)的精確性和收斂性。結(jié)果在ResNet-50模型的原始表現(xiàn)上,4塊TPU2芯片和4塊V100GPU速度相同。訓(xùn)練ResNet-50時谷歌云TPU的實現(xiàn)用時短到令人發(fā)指,且基于ImageNet數(shù)據(jù)集的圖像分類準確度達76.4%的成本只要73美元,說物美價廉可能也不過分。

去年5月,谷歌推出了第二代TPU芯片,這是一個自定義開發(fā)的深度學(xué)習(xí)加速芯片,不少人認為有望成為英偉達GPU的替代品。

可事實真的如此么?

在這篇文章中,作者詳細對比了谷歌TPU2和英偉達V100的性能。孰優(yōu)孰劣,一較便知~

環(huán)境設(shè)置

話不多說直接上干貨了。下面我們就先比較由四個TPU芯片組成的TPU2組合板與四個英偉達V100 GPU的環(huán)境設(shè)置的差別。

巧的是,因為兩者的總內(nèi)存均為64G,因此我們能夠用同一個模型測試了,還能使用相同的batch size,節(jié)省了不少工夫呢。

在這次實驗中,我們用相同的方式訓(xùn)練模型,雙方需要運行同步數(shù)據(jù)并行分布式訓(xùn)練。

最后,我們選中了ImageNet上的ResNet-50模型進行測試。它實際上是圖像分類的一個參考點,雖然參考實現(xiàn)是公開的,但目前還沒有一個支持在云TPU和多個GPU上訓(xùn)練的單一實現(xiàn)。

先看看V100這一邊,英偉達建議用MXNet或TensorFlow來實現(xiàn),兩者都可以在英偉達GPU云上的Docker映像中使用。

但實際的操作中我們卻發(fā)現(xiàn)了一些問題,這要是兩種實現(xiàn)不能很好融合多個GPU和產(chǎn)生的大型batch size。

好在我們還有一些新發(fā)現(xiàn),從TensorFlow的基準存儲庫中使用ResNet-50實現(xiàn),并在Docker映像中運行它是可行的。這種方法比英偉達的推薦的TensorFlow實現(xiàn)要快得多,只比MXNet實現(xiàn)稍微慢一點(約3%)。這樣一來,也更容易在相同版本中用同一個框架的實現(xiàn)做對比。

再看看谷歌云TPU這一邊,官方建議用帶TensorFlow 1.7.0官方TPU存儲庫的bfloat16實現(xiàn)。TPU和GPU實現(xiàn)都在各自的體系架構(gòu)上使用混合精度計算,但大部分張量是以半精度的方式儲存的。

一翻研究和對比后……我們終于敲定了實驗方案。

對于V100來說,我們決定用AWS上的p3.8xlarge實例(Xeon E5-2686@2.30GHz 16內(nèi)核,244GB內(nèi)存,Ubuntu16.04),用4個單個內(nèi)存為16GB的V100 GPU進行測試。

TPU這邊的測試,我們將小型的n1-standard-4實例作為host(Xeon@2.3GHz兩核,15GB內(nèi)存,Debian 9),我們提供了一個云TPU,由4個單個內(nèi)存為16G的TPU2芯片組成。

方案敲定后,我們又規(guī)劃了兩個對比方向。

一是我們要測試在沒有增強過的合成數(shù)據(jù)上的吞吐量(每秒圖像)。這種比較獨立于收斂性,保證里了在I/O或數(shù)據(jù)增強中沒有瓶頸bottleneck影響結(jié)果。

二是,我們要考察ImageNet上兩者實現(xiàn)的精確性和收斂性。

目標,明確,方法,明確。我們迫不及待開始測試了——

吞吐量測試

我們依據(jù)每秒合成數(shù)據(jù)上的圖像來測量吞吐量,即在訓(xùn)練數(shù)據(jù)實時創(chuàng)建、batch size也不同的情況下對吞吐量進行檢測。

雖然~官方只推薦的TPU的batch size是1024,但是基于讀者的請求,我們還報告了其他batch size大小的性能。

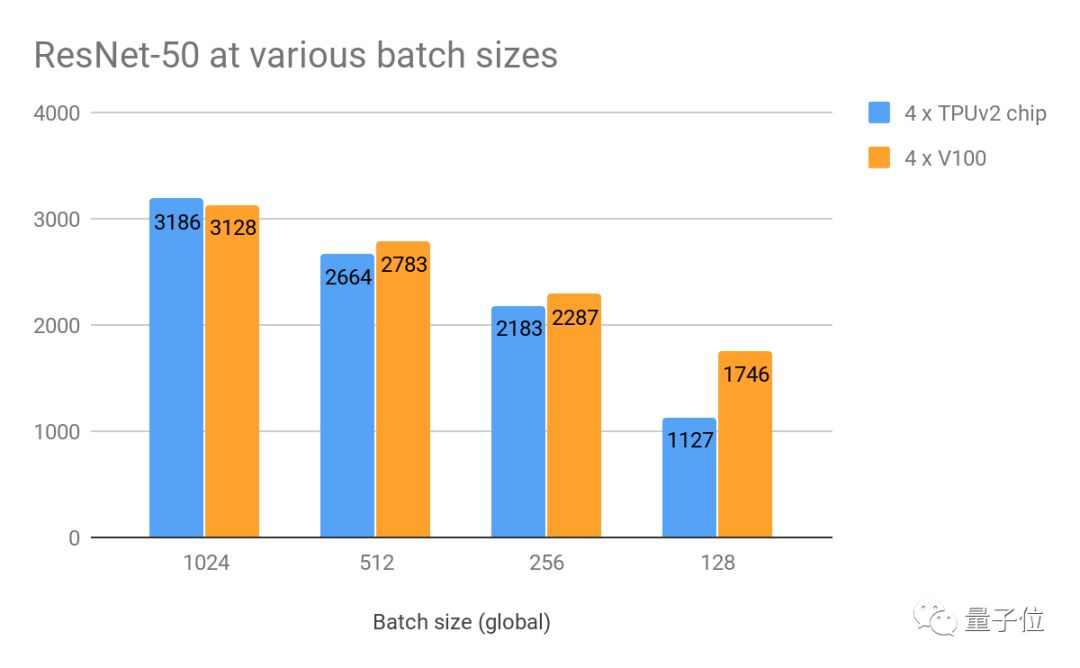

△在合成數(shù)據(jù)和w/o數(shù)據(jù)增強的不同批次上每秒的圖像性能

在batch size為1024的情況下,雙方的吞吐量旗鼓相當,TPU略領(lǐng)先2%。

當batch size較小時,在雙方吞吐量均降低,但對比起來GPU的性能稍好一些。看來,這些batch size真的不是TPU的推薦設(shè)置~

根據(jù)英偉達的建議,我們還也在MXNet上做了一個GPU測驗。

利用英偉達GPU云上Docker映像中提供的ResNet-50實現(xiàn)(mxnet:18.03-py3),我們發(fā)現(xiàn)在batch size為768的情況下,GPU每秒能處理約3280個圖像。這比上面最好的TPU結(jié)果還要快3%。

也正如上面所說的那樣,在上述batch size下,MXNet的實現(xiàn)在多個GPU上并沒有很好聚合。所以,我們接下來研究的重點就是這就是為什么我們將重點就是TensorFlow的實現(xiàn)。

性價比

上面我們也提到過,谷歌云TPU2一組有四塊芯片,目前只在谷歌云上才能用到。

當需要進行計算時,我們可以將它與虛擬機相連。考慮到谷歌云上不支持英偉達V100,所以其云服務(wù)只能來自AWS。

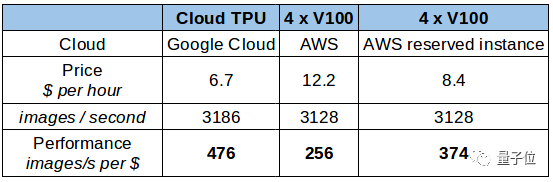

基于上述結(jié)果,我們可以把數(shù)據(jù)標準化,從每小時的花費、每秒處理的圖片數(shù)量、每美元能處理的圖片數(shù)三個維度進行對比。

△每美元每秒處理圖像的表現(xiàn)

對比下來,谷歌云TPU性價比略高。不過,谷歌TPU目前不賣,只能租。如果你考慮長期租用,或者購買的話,結(jié)論就不一樣了。

有一點你可能忘了,上面這張表的前提是假定了我們的租期為12個月,所以費用中包含了AWS上p3.8xlarge實例,并且不需要提前支付定金。這樣大大降低了價格,還能達到每美元能處理375張圖片的不錯效果。

其實對于GPU來說,還有更多的選擇。比方說,Cirrascale提供4臺V100GPU服務(wù)器的月租服務(wù),收費大概是7500美元,折算下來是每小時10.3美元。

不過,因為AWS上像CPU、內(nèi)存、NVLink支持等硬件類型也各不同,如果要更直接的對比,就需要更多的參考數(shù)據(jù)。其他費用套餐可參考:

http://www.cirrascale.com/pricing_x86BM.php

精準度和收斂程度

除了原始的表現(xiàn),我們還希望有效驗證的計算能力。比方說,實現(xiàn)收斂的結(jié)果。因為比較的是兩個不同的實現(xiàn),所以可以預(yù)期到結(jié)果會有不同。比較的結(jié)果不僅僅是硬件的速度,也包含實現(xiàn)的質(zhì)量。

比方說,TPU實現(xiàn)的過程中應(yīng)用到了計算密集的圖像預(yù)處理步驟,并且還犧牲了原始的吞吐量。下面我們也能看到,谷歌的這種選擇有不錯的回報。

我們用ImageNet數(shù)據(jù)集訓(xùn)練這些模型,想把圖像進行分類。目前,這個數(shù)據(jù)集中的類別已經(jīng)細分到了1000種,包含了130萬張訓(xùn)練圖片,5萬張驗證圖片。

我們在batch size為1024的情況下進行訓(xùn)練,進行了90次迭代后在驗證集上對比雙方的結(jié)果。

結(jié)果顯示,TPU可以每秒完成2796張圖,GPU則為2839張。這個結(jié)果和我們上面提到的吞吐量不同,是因為上面我們禁用了數(shù)據(jù)增強,并用合成數(shù)據(jù)來比較的TPU和GPU的原始速度。

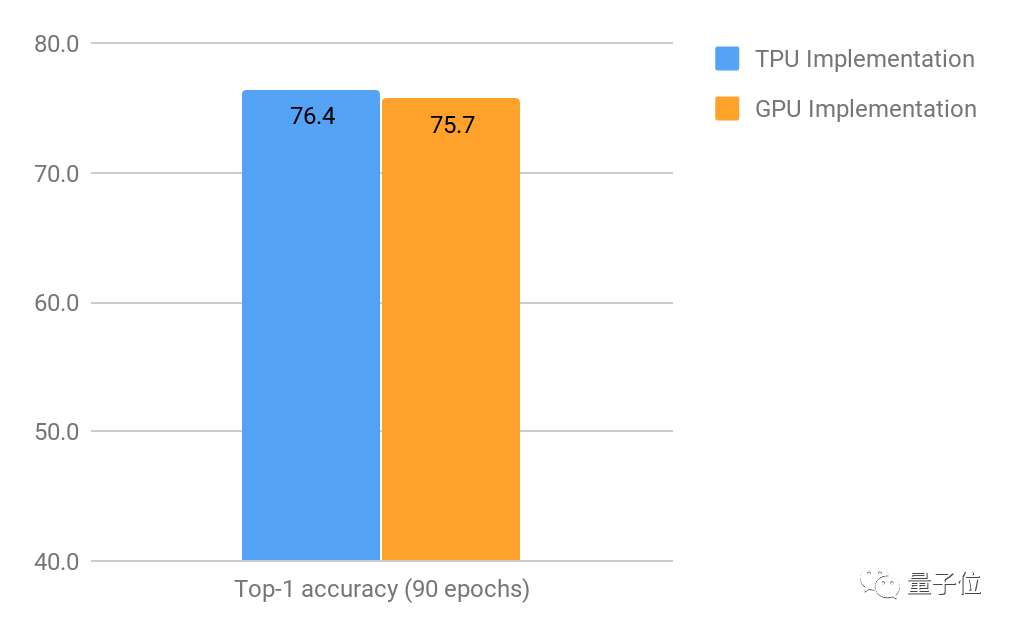

△90次訓(xùn)練之后,Top-1 精確值*(只考慮每張圖最高的預(yù)估)

從上圖可以看出來,90次訓(xùn)練之后,TPU實現(xiàn)的Top-1精準度要好過GPU,有0.7%的優(yōu)勢。

雖然0.7%的優(yōu)勢看起來非常微小,但在如此高水平的情況下還有這樣的改進非常難,基于不同的應(yīng)用個,這點改進將對最后的結(jié)果有很大影響。

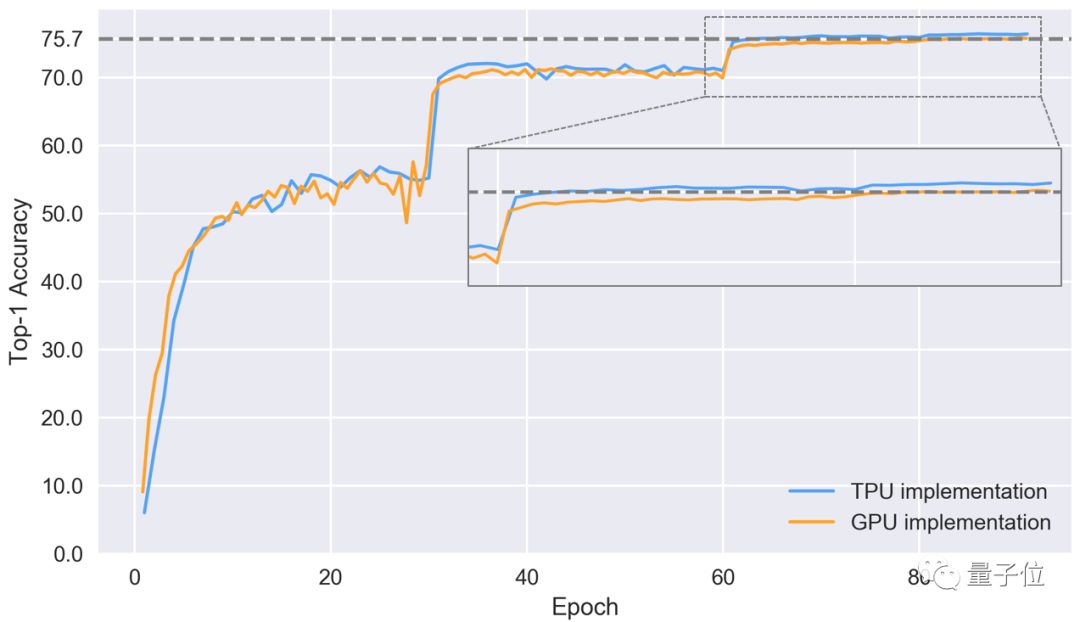

接下來,我們看一下不同訓(xùn)練時期,模型Top-1精準度的表現(xiàn)。

△在驗證集上,兩種方法實現(xiàn)Top-1精準度的表現(xiàn)

可以看出,圖表中有一段精準度陡增,和學(xué)習(xí)速率高度同步。TPU實現(xiàn)的收斂表現(xiàn)更好,最后到第86次訓(xùn)練時,準確率可以達到76.4%。

GPU的表現(xiàn)就被甩在了后面,第84次訓(xùn)練后達到了75.7%的準確率,而TPU早在第64次訓(xùn)練時就達到了這個水平。

TPU有更好的表現(xiàn),很可能要歸功于前期的預(yù)處理和數(shù)據(jù)增強。不過我們需要更多的實驗來驗證這個猜想。

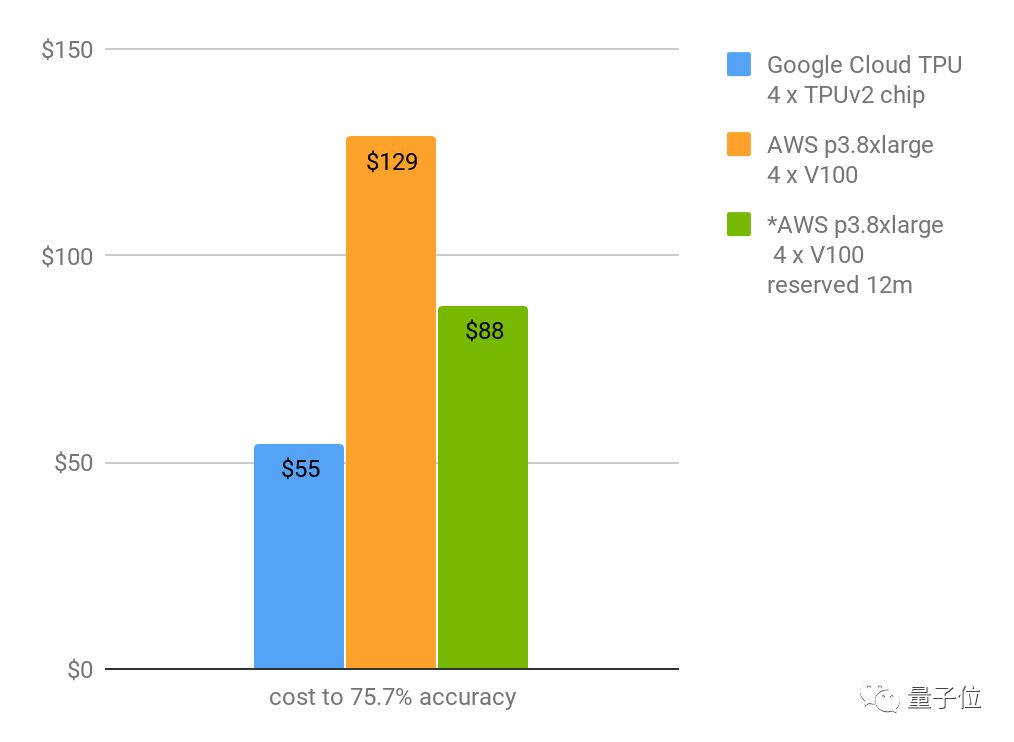

基于成本價格提出的解決方案

我們最終需要考慮的,一是整個流程走下來的時間,二是它需要耗費多少資金。如果我們假設(shè)最后可接受的準確率為75.7%,那么可以根據(jù)每秒訓(xùn)練速度和既定要求的訓(xùn)練次數(shù),算出來達到這個標準所需的成本。時間方面需要注意,不包括訓(xùn)練啟動用時,以及訓(xùn)練期間的模型驗證用時。

△達到75.1%Top-1準確率所需成本 | *表示租期為12個月

上圖顯示,谷歌TPU從零訓(xùn)練圖像分類模型的成本是55美元(且訓(xùn)練時間用了不到9小時)!收斂到76.4%的話成本將達到73美元。

而英偉達V100速度差不多快,但成本會更高,收斂速度也比較慢,不是個性價比高的解決方案~

對了,我們這個結(jié)論是基于實現(xiàn)的質(zhì)量、云的價格來對比得出的。其實還有另外一個維度可以來比較,即算力的損耗。不過因為我們?nèi)狈Χ鶷PU算力損耗的公開信息,這方面的對比先不做了啦。

總結(jié)

按我們上述的衡量標準來看,在ResNet-50模型的原始表現(xiàn)上,4塊TPU2芯片和4塊V100GPU是速度相同。

目前來說,訓(xùn)練ResNet-50時谷歌云TPU的實現(xiàn)用時短到令人發(fā)指,且基于ImageNet數(shù)據(jù)集的圖像分類準確度達76.4%的成本只要73美元,說物美價廉可能也不過分~

-

谷歌

+關(guān)注

關(guān)注

27文章

6194瀏覽量

106016 -

gpu

+關(guān)注

關(guān)注

28文章

4775瀏覽量

129357 -

TPU

+關(guān)注

關(guān)注

0文章

143瀏覽量

20783 -

英偉達

+關(guān)注

關(guān)注

22文章

3847瀏覽量

91972

原文標題:谷歌TPU2代有望取代英偉達GPU?測評結(jié)果顯示…

文章出處:【微信號:IV_Technology,微信公眾號:智車科技】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

OpenAI與博通洽談合作!定制化ASIC芯片走向臺前,英偉達GPU迎來“勁敵”?

英偉達與谷歌聯(lián)手加速量子計算設(shè)備設(shè)計

英偉達與谷歌攜手加速量子計算設(shè)備設(shè)計

英偉達攜手谷歌,共筑量子計算新篇章

從TPU v1到Trillium TPU,蘋果等科技公司使用谷歌TPU進行AI計算

谷歌TPU2和英偉達V100的性能詳細對比

谷歌TPU2和英偉達V100的性能詳細對比

評論