相信各位小伙伴一定已經(jīng)學(xué)習(xí)了今年CVPR的兩篇最佳論文了,一篇是來自于斯坦福和伯克利大學(xué)的研究人員共同進(jìn)行的關(guān)于如何進(jìn)行高效遷移學(xué)習(xí)的:Taskonomy: Disentangling Task Transfer Learning,另一篇來自卡耐基梅隆大學(xué)的論文:Total Capture: A 3D Deformation Model for Tracking Faces, Hands, and Bodies實現(xiàn)了多尺度人類行為的三維重建和追蹤。但除此之外,還有四篇優(yōu)秀的工作被授予了最佳論文的榮譽(yù)提名獎,分別是來自:

帝國理工戴森機(jī)器人實驗室的:CodeSLAM — Learning a Compact, Optimisable Representation for Dense Visual SLAM;

加州大學(xué)默塞德分校、麻省大學(xué)阿默斯特分校和英偉達(dá)的:SPLATNet: Sparse Lattice Networks for Point Cloud Processing;

隆德大學(xué)、羅馬尼亞科學(xué)院的:Deep Learning of Graph Matching;

奧地利科技學(xué)院、馬克思普朗克圖賓根研究所、海德巴拉國際信息技術(shù)研究所和劍橋大學(xué)共同研究的:Efficient Optimization for Rank-based Loss Functions四篇論文分別從幾何描述、點云處理、圖匹配和優(yōu)化等方面進(jìn)行了研究,下面讓我們一起學(xué)習(xí)一下吧!

CodeSLAM — Learning a Compact, Optimisable Representation for Dense Visual SLAM

在實時三維感知系統(tǒng)中,物體幾何的表述一直是一個十分關(guān)鍵的問題,特別是在定位和映射算法中有著重要的作用,它不僅影響著映射的幾何質(zhì)量,更與其采取的算法息息相關(guān)。在SLAM特別是單目SLAM中場景幾何信息不能從單一的視角得到,而與生俱來的不確定性在大自由度下會變得難以控制。這使得目前主流的slam分成了稀疏和稠密兩個方向。雖然稠密地圖可以捕捉幾何的表面形貌并用語義標(biāo)簽進(jìn)行增強(qiáng),但它的高維特性帶來的龐大存儲計算量限制了它的應(yīng)用,同時它還不適用于精密的概率推測。稀疏的特征可以避免這些問題,但捕捉部分場景的特征僅僅對于定位問題有用。

為了解決這些問題,這篇文章里作者提出了一種緊湊但稠密的場景幾何表示,它以場景的單幅強(qiáng)度圖作為條件并由很少參數(shù)的編碼來生成。研究人員在從圖像學(xué)習(xí)深度和自編碼器等工作的啟發(fā)下設(shè)計了這一方法。這種方法適用于基于關(guān)鍵幀的稠密slam系統(tǒng):每一個關(guān)鍵幀通過編碼可以生成深度圖,而編碼可以通過位姿變量和重疊的關(guān)鍵幀進(jìn)行優(yōu)化以保持全局的連續(xù)性。訓(xùn)練的深度圖可使得編碼表示不能直接從圖像預(yù)測出的局部幾何特征。

這篇文章的貢獻(xiàn)主要在兩個方面:

推導(dǎo)出了一種通過強(qiáng)度圖訓(xùn)練深度自編碼器的稠密集合表示,并進(jìn)行了優(yōu)化;

首次實現(xiàn)了稠密集合與運動估計聯(lián)合優(yōu)化的單目系統(tǒng)。

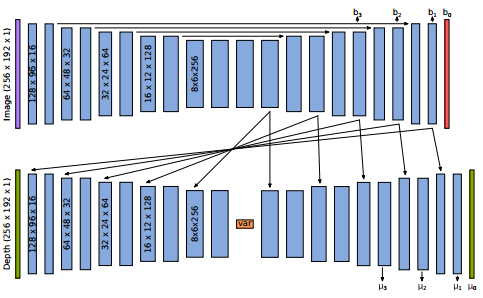

下圖是研究人員采用的網(wǎng)絡(luò)架構(gòu),實現(xiàn)了基于圖像強(qiáng)度的變分深度自編碼器。

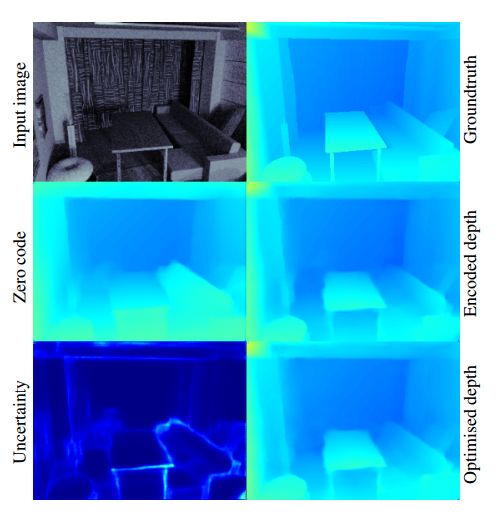

下圖是編解碼階段不同的輸出,以及編碼抓取細(xì)節(jié)的能力:

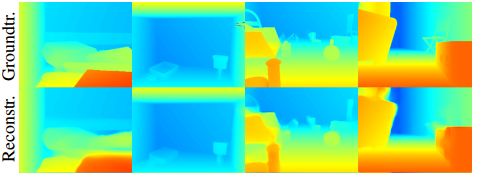

下圖是編碼后的恢復(fù)以及sfm結(jié)果:

研究人員們希望在未來構(gòu)建出完整的基于關(guān)鍵幀的實時SLAM系統(tǒng),并在更遠(yuǎn)的將來致力于研究一般三維幾何更加緊湊的表示,甚至用于三維物體識別。

如果有興趣,可以訪問項目主頁獲取更詳細(xì)信息,也可參看附件的視頻簡介:

http://www.imperial.ac.uk/dyson-robotics-lab/projects/codeslam/

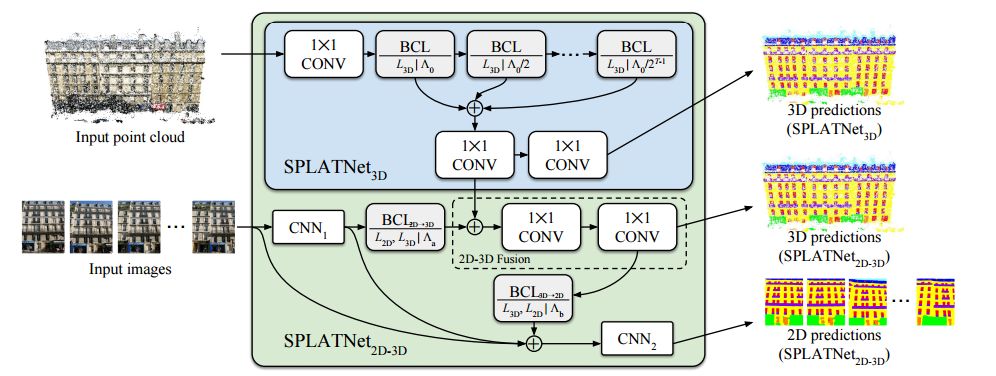

SPLATNet: Sparse Lattice Networks for Point Cloud Processing

激光雷達(dá)等三維傳感器的數(shù)據(jù)經(jīng)常是不規(guī)則的點云形式,分析和處理點云數(shù)據(jù)在機(jī)器人和自動駕駛中有著十分重要的作用。

但點云具有稀疏性和無序性的特征,使得一般的卷積神經(jīng)網(wǎng)絡(luò)處理3D點數(shù)據(jù)十分困難,所以目前主要利用手工特征來對點云進(jìn)行處理。其中一種方法就是對點云進(jìn)行預(yù)處理使其符合標(biāo)準(zhǔn)空間卷積的輸入形式。按照這一思路,用于3D點云分析的深度學(xué)習(xí)架構(gòu)都需要對不規(guī)則的點云進(jìn)行預(yù)處理,或者進(jìn)行體素表示,或者投影到2D。這需要很多的人工并且會失去點云中包含自然的不變性信息。

為了解決這些問題,在這篇文章中作者提出了一種用于處理點云的網(wǎng)絡(luò)架構(gòu),其中的關(guān)鍵在于研究發(fā)現(xiàn)雙邊卷積層(e bilateral convolutionlayers——BCLs)對于處理點云有著很多優(yōu)異的特性。

雙邊卷積層

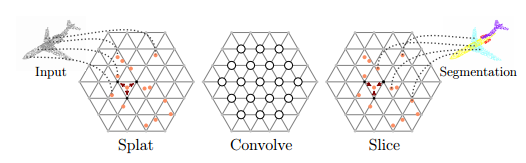

BCLs提供了一種系統(tǒng)的方法來除了無序點,但同時保持了卷積操作中柵格的靈活性。BCL將輸入點云平滑地映射到稀疏的柵格上,并在稀疏柵格上進(jìn)行卷積操作,隨后進(jìn)行平滑插值并將信號映射到原始輸入中去。利用BCLs研究人員們建立了SPLATNet(SParse LATtice Networks)用于分層處理無序點云并識別器空間特征。

SPLATNet的架構(gòu)

它具有以下優(yōu)點:

無需點云預(yù)處理;

可以方便實現(xiàn)像標(biāo)準(zhǔn)CNN一樣的鄰域操作;

利用哈希表可高效處理稀疏輸入;

利用稀疏高效的柵格濾波實現(xiàn)對輸入點云分層和空間特征的處理;

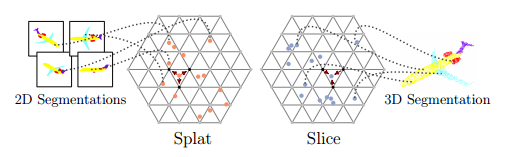

可實現(xiàn)2D-3D之間的互相映射。

二維到三維的投影

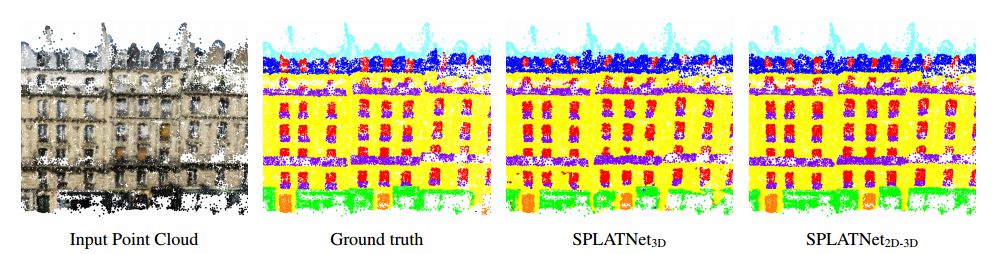

下圖是對于建筑物點云的處理結(jié)果:

如果有興趣的小伙伴可以參考項目主頁:

http://vis-www.cs.umass.edu/splatnet/

和英偉達(dá)的官方介紹:https://news.developer.nvidia.com/nvidia-splatnet-research-paper-wins-a-major-cvpr-2018-award/

如果想要上手練練,這里還有代碼可以跑一波:https://github.com/NVlabs/splatnet

今天附件中包含了視頻介紹,敬請觀看。

https://pan.baidu.com/s/1dIyZyEx-Bc9zYPIr4F_5bw

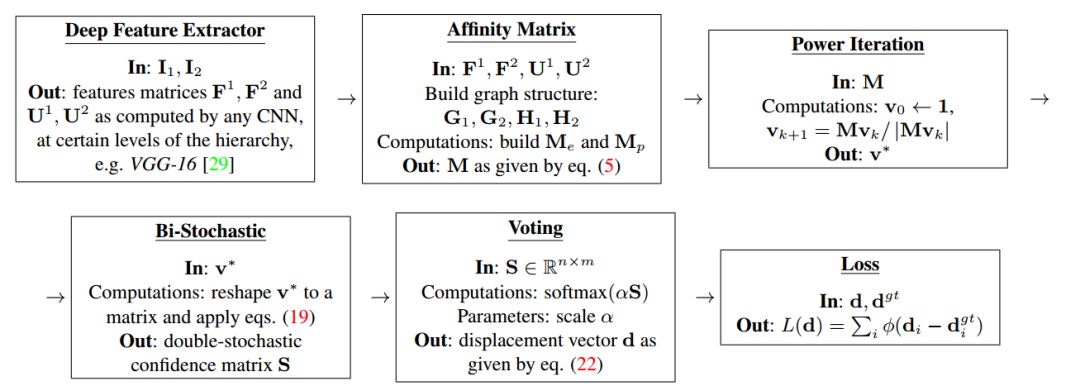

Deep Learning of Graph Matching

圖匹配問題是優(yōu)化、機(jī)器學(xué)習(xí)、計算機(jī)視覺中的重要問題,而如何表示節(jié)點與其相鄰結(jié)構(gòu)的關(guān)系是其中的關(guān)鍵。這篇文章提出了一種端到端的模型來使得學(xué)習(xí)圖匹配過程中的所有參數(shù)成為可能。其中包括了單位的和成對的節(jié)點鄰域、表達(dá)成了深度分層的特征抽取。

完整訓(xùn)練圖匹配模型的計算流程

這其中的難點在于為不同層之間的矩陣運算建立從損失函數(shù)開始的完整流程、實現(xiàn)高效、連續(xù)的梯度傳播。通過結(jié)合優(yōu)化層解決了匹配問題,并利用了分層特征抽取。最后在計算機(jī)視覺的實驗中取得了很好的結(jié)果。

可以看到在外形和位姿都極不同的各個實例中,關(guān)鍵點的圖匹配算法依然表現(xiàn)良好。

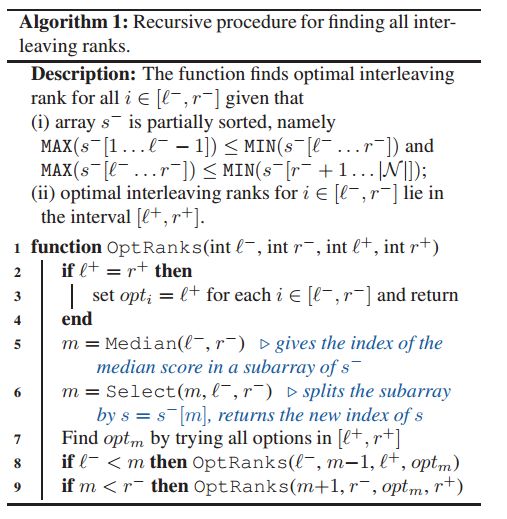

Efficient Optimization for Rank-based Loss Functions

在信息檢索系統(tǒng)中通常利用復(fù)雜的損失函數(shù)(AP,NDCG)來衡量系統(tǒng)的表現(xiàn)。雖然可以通過正負(fù)樣本來估計檢索系統(tǒng)的參數(shù),但這些損失函數(shù)不可微、不可分解使得基于梯度的算法無法使用。通常情況下人們通過優(yōu)化損失函數(shù)hinge-loss上邊界或者使用漸進(jìn)方法來規(guī)避這一問題。

系統(tǒng)算法

為了解決這一問題,研究人員們提出了一種用于大規(guī)模不可微損失函數(shù)算法。提供了符合這一算法的損失函數(shù)的特征描述,它可以處理包括AP和NDCC系列的損失函數(shù)。同時研究人員們還提出了一種非比照的算法改進(jìn)了上述漸進(jìn)過程的計算復(fù)雜度。這種方法與更簡單的可分解(需要對照訓(xùn)練)損失函數(shù)相比有著更好的結(jié)果。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4781瀏覽量

101178 -

圖像

+關(guān)注

關(guān)注

2文章

1089瀏覽量

40574 -

激光雷達(dá)

+關(guān)注

關(guān)注

968文章

4028瀏覽量

190424

原文標(biāo)題:提名也是莫大的榮譽(yù):除了最佳論文,CVPR的這些論文也不容錯過

文章出處:【微信號:thejiangmen,微信公眾號:將門創(chuàng)投】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

基于變分自編碼器的異常小區(qū)檢測

是什么讓變分自編碼器成為如此成功的多媒體生成工具呢?

自編碼器介紹

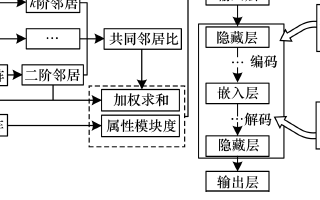

基于稀疏自編碼器的屬性網(wǎng)絡(luò)嵌入算法SAANE

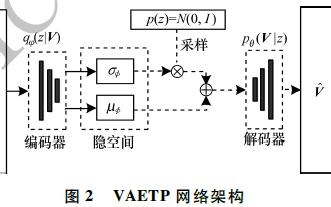

基于變分自編碼器的海面艦船軌跡預(yù)測算法

自編碼器基礎(chǔ)理論與實現(xiàn)方法、應(yīng)用綜述

一種多通道自編碼器深度學(xué)習(xí)的入侵檢測方法

一種基于變分自編碼器的人臉圖像修復(fù)方法

基于變分自編碼器的網(wǎng)絡(luò)表示學(xué)習(xí)方法

自編碼器神經(jīng)網(wǎng)絡(luò)應(yīng)用及實驗綜述

基于深度稀疏自編碼網(wǎng)絡(luò)的行人檢測

基于交叉熵?fù)p失函欻的深度自編碼器診斷模型

深度對戰(zhàn)自編碼網(wǎng)絡(luò)在船舶重量評估的應(yīng)用

自編碼器 AE(AutoEncoder)程序

采用的網(wǎng)絡(luò)架構(gòu),實現(xiàn)了基于圖像強(qiáng)度的變分深度自編碼器

采用的網(wǎng)絡(luò)架構(gòu),實現(xiàn)了基于圖像強(qiáng)度的變分深度自編碼器

評論