利用深度學習“換臉”合成假視頻的技術發展之快令人驚嘆,也令人深感不安。但是,道高一尺魔高一丈,研究人員已經研究出一種新方法來檢測這些被操縱的換臉視頻的“跡象”:這是普通人都會注意到的一個缺陷:缺少眨眼。

紐約州立大學奧爾巴尼分校計算機科學系的研究人員最近發表了一篇題為“In Ictu Oculi:通過檢測眨眼來揭露AI產生的換臉假視頻”。論文詳細介紹了他們如何組合兩個神經網絡,從而更有效地揭露哪些視頻是AI合成的。這些視頻往往忽略了“自發的、無意識的生理活動,例如呼吸、脈搏和眼球運動”。

研究人員指出,人類靜止時的眨眼頻率平均為每分鐘17次;當一個人說話時,眨眼頻率增加到每分鐘26次,閱讀時則減少到每分鐘4.5次。研究人員補充說,這些區別值得注意,“因為視頻上正在說話的發言者,被拍攝時可能實際上正在閱讀。”因此,當視頻中某個正在說話的人完全不眨眼,很容易就能看出這段錄像是假的。

深度學習技術產生的假視頻(deepfake videos)中的主體不會眨眼,原因之一是:大多數提供給神經網絡的訓練數據集不包含閉眼的照片,因為人們在網上公開的照片通常都是睜眼的。這是必然的結果,因為創造deepfake視頻需要手機大量的個人照片,而這個過程可以通過開源的照片抓取工具從網絡上獲取公開照片。

之前的論文已經指出,缺乏眨眼是檢測deepfakes的一種方法,但奧爾巴尼大學的研究人員表示,他們的系統比之前提出的檢測方法更準確。之前的研究使用眼睛長寬比(EAR)或卷積神經網絡(CNN)分類器來檢測眼睛是睜開著還是閉著。新的研究里,研究人員將基于CNN的方法與遞歸神經網絡(RNN)結合起來,這種方法除了考慮單個視頻幀之外,還考慮以前的眼睛的狀態。

LRCN方法的概覽

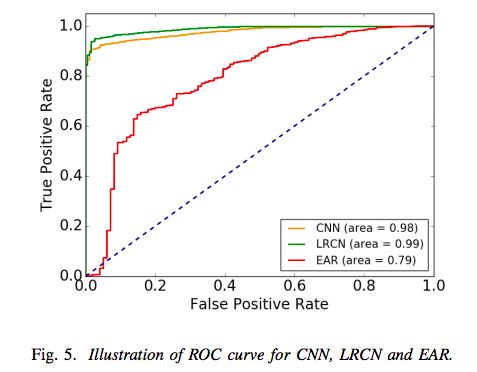

與單純的CNN模型不同,研究人員表示,他們的長期遞歸卷積網絡( Long-term Recurrent Convolutional Network ,LRCN)方法可以“有效地預測眼睛狀態,從而可以更加準確。”根據論文,這種方法的準確率為0.99,相比之下,CNN的準確率為0.98,而EAR的準確率為0.79。

LRCN和CNN、EAR方法的結果比較

至少,研究人員的發現表明,我們有辦法揭露機器學習技術創造出來的非常逼真假視頻。例如,一個叫做Deep Video Portraits的新系統能給視頻中的人物“換臉”,甚至可以再現臉部的動作、面部表情、說話口型和實現方向。

Deep Video Portraits

令人欣慰的是,研究人員正在尋找識別假視頻的方法,特別是因為這項技術可能被濫用,以及可能促進假新聞的傳播。但這些檢測方法是否會超過deepfake技術的發展速度,還有待觀察。

“在我個人看來,最重要的是,公眾必須意識到現代技術在視頻生成和編輯方面的有很大的能力,”斯坦福大學訪問助理教授Michael Zollhofer在一篇博客文章中寫道:“這將使他們更批判性地思考自己每天消費的視頻內容,尤其是在視頻內容沒有來源證明的情況下。”

-

神經網絡

+關注

關注

42文章

4779瀏覽量

101168 -

機器學習

+關注

關注

66文章

8438瀏覽量

133080 -

深度學習

+關注

關注

73文章

5513瀏覽量

121546

原文標題:反“換臉”魔高一丈:新方法識別假視頻正確率達99%

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

一種求解非線性約束優化全局最優的新方法

目前微通道面臨的限制,突破硅技術的一種新方法

一種精確測量儲能成本的新方法:LCUS

一種復制和粘貼URL的新方法

一種產生激光脈沖新方法

一種無透鏡成像的新方法

一種新方法來檢測這些被操縱的換臉視頻的“跡象”

一種新方法來檢測這些被操縱的換臉視頻的“跡象”

評論