數學最重要的魅力在于幫助我們提出解決問題的思路或途徑。

而機器學習在一定程度上正是數學和工程的完美結合,畢竟用數學里面的概率論、隨機分析等工具研究AI早已不是什么新鮮事情。例如機器學習的四個基本原則性的問題,即泛化性、穩定性、可計算性和可解釋性就可以用數學工程手段來解決。

在5月 9日的北京智源人工智能研究院主辦的“智源論壇——人工智能的數理基礎”系列報告中,北京?學的張志華教授對機器學習和數學工程的內在關系進行了闡述。在報告中,他提到:統計為求解問題提供了數據驅動的建模途徑;概率論、隨機分析、微分方程、微分流形等工具可以引入來研究 AI 的數學機理等等。

除此之外,張志華教授還回顧了機器學習發展的?個重要階段,以及重點強調機器學習和人工智能之間并不能畫等號,畢竟機器學習實際上是研究算法的學科,而人工智能志在模擬人的思維和行為。

機器學習發展現狀的認識

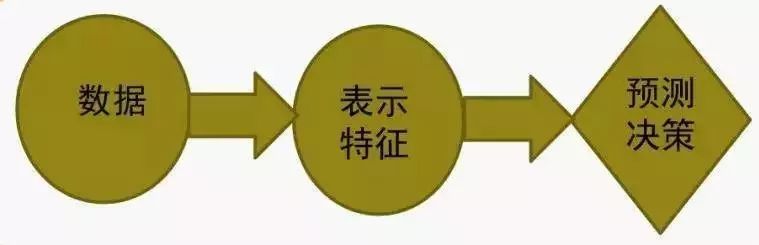

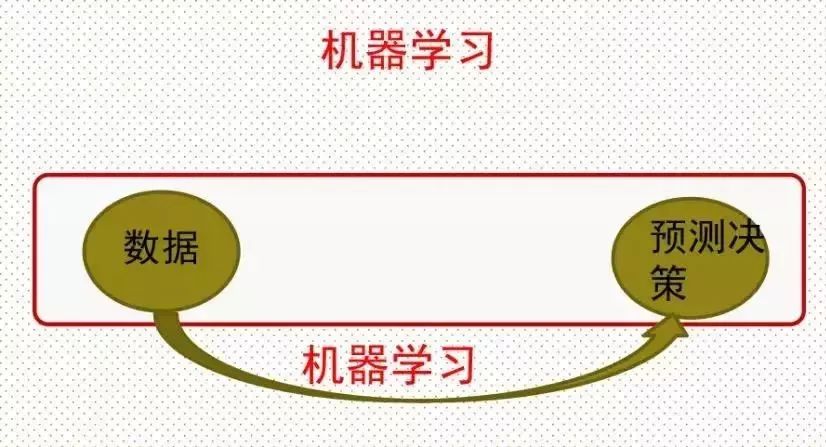

機器學習與人工智能有著本質上的不同,前者志不在模擬人的思維和行為,主要是想通過經驗和交互的方式改善性能,是基于規則的學習。機器學習實際上是研究算法的學科,算法是基于數據型算法,然后反饋到數據中去。 可以簡單地把機器學習的過程看作這樣一個思路,然后可以基于此看看機器學習發展的歷程:

傳統方法:基于規則學習

第一個歷程是基于規則的學習,它的目的就是為了規則,有規則它就可以做預測。但是重點不是怎么形成規則,而是數據到表示,即通過認知的手段,把人對數據的認識過程,用計算機記錄下來。從而成一種形式化的方式,自然而然就有一種規則和邏輯的方式去做預測。它主要代表有兩個,一個是專家系統,包括知識庫和推理基,其中重點就是知識庫。另外一個是句法模式識別,模式的目的也是怎么樣把一個對象通過一種形式化的方式表示出來。

但這一階段也暴露出一些問題,其一便是基于規則學習的方法雖然對于淺層推理比較有效,但遇上深層推理需求,如果形成規則過多,在其中搜索就容易出現前面的分享提到過的維數災難問題。

為了解決問題,一個用一個強大的非線性學習模型來弱化數據到表示過程的作用,基于這樣的理論,機器學習發展至第二個階段。

統計機器學習黃金發展的十年

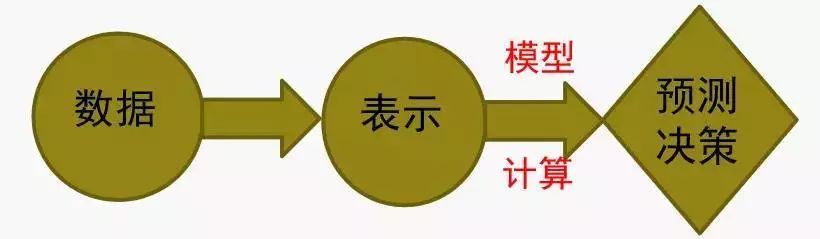

第二階段是90年代中期到2005年左右十年的時間。在這一階段為了解決維數災難,出現了一個數論:即基于規則的方式,環成一個非線性的一種模型,或者用計算的手段運作模型,然后反過來可以弱化數據到表示的過程。

這一階段的神經網絡(80 年代就已經出現神經網絡模型)則相對趨于比較低落的時期,表現平平,發展遇冷。主要原因在于時期的機器學習方法比神經網絡要更為簡單,性能也要更好,屬性性質相對完美,自然而然地就取代了神經網絡。

但隨著統計方法發展到一定階段,大家發現“數據到表示”這件事情還是繞不過去。而應對這一問題地一個簡單的思路就是通過學習的途徑來求解表示問題,從而弱化研究者對于領域背景高度掌握的要求,也就是通過一個自動化的方式來解決這一問題。

基于深度表示的學習

大模型+大數據+大計算使得這種思路變得可行,機器學習也進入了第三階段。AlexNet 網絡的提出在后來為問題帶來了突破性進展,很多做計算機視覺的人在網絡方面不停跟進,這些發展主要是基于視覺的。

那么在機器翻譯、自然語言處理,自然而然也想到深度學習既然可以解決視覺問題,當然就可以把深度學習拿到機器學習來,所以現在在機器學習里面它的主要的模型也是基于深度。雖然模型可能不是卷積神經網絡,但是核心確是LSTM這種東西。但是不管怎么樣,相對于機器學習,自然語言處理深度學習,在自然語言處理它的效果或者它的作用遠遠沒有那么好。

在上述時期,用深度學習它的目的還不是為了表示,主要是為了什么?還是為了非線性的擬合,在自然語言處理,個人理解目前為止還沒有找到一種非常有效的,像卷積神經網絡有效表示圖像的網絡,所以導致自然語言處理沒有像圖像那么強大。

那這整個過程,知道都是在一個有監督的方式里面去做的,本質上就是把數據到表示用一個模型和計算的方式做。而表示到預測、決策也是通過模型計算的,整個可以看到從數據到預測是端到端的優化學習過程。

深度學習目前現狀:無監督問題突出

深度學習發展到現在,主要講是有監督的學習,但是現在很多問題是無監督的,就是無監督的問題遠遠比有監督的問題要多,而且要復雜。那么一個簡單的思想就是要把無監督的問題要形成與有監督類似的學習的過程,有一個優化的過程,用機器學習的方法解決事情,在統計里面,現在假設X要生成它,那么如果X是連續的,可以假設X是高斯,但是如果X來自高斯假設很強,但是可以說X是來自什么?是一個高斯混合體,如果X是一個連續的向量,那它總是可以用一個高斯混合體去逼近它,是沒有任何問題的。

但是時候發現X是一個抽象的數學意識,并沒有具體的物理意義,那么自然神經網絡這些技術能不能對一個圖像進行生成了,對語言進行生成,而不是對數學意義上的X去生成。現在發展比如有一個生成對抗網絡,它就是解決這樣的問題,它的目的不是為了生成一個抽象數學意義上的X,是生成一個真正的圖像或者語言,那么它的框架實際上就是怎么樣形成一個優化問題。

強化學習目前的復興是因為深度學習

另一個發展方向是強化學習,強化學習是什么呢?它利用規則與環境交互或者獎賞,然后形成一個學習優化問題,形成一個優化問題。

對于強化學習,不是最近才發明出來的。其主要的數學手段是馬爾可夫決策過程,它通過馬爾可夫決策過程去描述問題,描述問題之后要去解問題,發現問題最優解,最后把它定成貝爾曼方程,那么解貝爾曼方程的話發現是可以用不動點定理來描述貝爾曼方程。那么有了不動點定理支撐,現在主要是有兩個思路,第一個思路是基于Value,也就是用Value迭代找到最優值。另外一種就是Polic迭代,因為本質上不是找Value,是找Polic,所以就直接在Polic方面去做迭代。

現在很多實際問題實際上對環境是不會已知的,也就是說對卷積概率是不會知道的。這時候發展就是一個所謂的Q-Learning,實際上Q-Learning定義了一個新的函數叫Q函數。那么在Q-Learning基礎上,就發展出來深度的Q網絡,目前現在主要做的比如像Polic的梯度方法,這是強化學習或者深度強化學習目前發展的一個主要結點。

機器學習的技術路線

機器學習有三個問題。一個是有監督、無監督和強化學習。原來認為機器學習是統計的分支,現在認為機器學習就是現代統計學。機器學習和統計還有微妙的關系,機器學習是分類問題,而統計是回歸問題,分類和回歸也沒有太本質的區別。

第二,機器學習往往會形成優化問題。剛才說要形成優化過程,它跟優化是什么區別?一個優化的學者,或者優化領域里面它純粹就關注找到最優值。但是對于機器學習的學者來說,最緊急的是要找到預測數據。

現在看來,現代的機器學習它主要成功就在于表示,就是深度學習是一個表示,它不是單純的是一個非線性模型,主要是一個非線性的表示。當然想到機器學習它的目的是預測,而預測是通過計算得出。

但是深度學習也遇到很多挑戰,第一個是需要大數據的要求,大家網絡是非常多,所以往往導致過參數的問題。另外就是在做表述是基于多層的表述,所以問題是高度的非凸化。

另外,現在機器學習要關注的重點問題有四個方面。第一個是可預測性、第二個可計算性、第三個是穩定性、第四個就是可解釋性。可能現在認為主要重點就是在穩定性和泛化性方面,因為覺得神經網絡沒有可解釋性。

最后,張志華教授就機器學習和數學工程之間的關系給出了這樣的闡述:

統計為求解問題提供了數據驅動的建模途徑;

概率論、隨機分析、微分方程、微分流形等工具可以引入來研究 AI 的數學機理;

無論從統計角度還是從數學角度來研究 AI,其實際性能最后都要通過計算呈現出來:

1.數值分析,即求解連續數學問題的算法;

2.離散算法,即求解離散結構問題的算法;

3.大規模計算架構

-

神經網絡

+關注

關注

42文章

4781瀏覽量

101176 -

機器學習

+關注

關注

66文章

8441瀏覽量

133087

原文標題:北大張志華:機器學習就是現代統計學

文章出處:【微信號:BigDataDigest,微信公眾號:大數據文摘】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

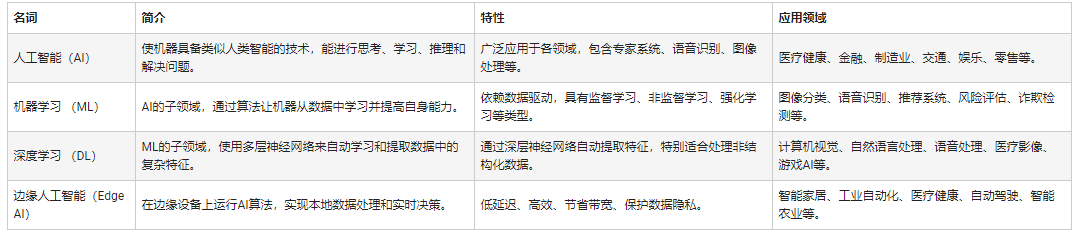

人工智能和機器學習以及Edge AI的概念與應用

如何選擇云原生機器學習平臺

自然語言處理與機器學習的關系 自然語言處理的基本概念及步驟

什么是機器學習?通過機器學習方法能解決哪些問題?

NPU與機器學習算法的關系

【「時間序列與機器學習」閱讀體驗】時間序列的信息提取

【《時間序列與機器學習》閱讀體驗】+ 時間序列的信息提取

【《時間序列與機器學習》閱讀體驗】+ 了解時間序列

南京理工大學數學與統計學院師生團隊一行蒞臨中科億海微參觀交流

機器學習就是現代統計學

機器學習就是現代統計學

評論