前面有一篇文章詳細(xì)說(shuō)明了如何在Jetson Nano上安裝YOLOv5,然后運(yùn)行,這里只需在導(dǎo)出的時(shí)候?qū)С鰁ngine模型文件支持。

2022-11-17 09:38:50 3411

3411 前面我們給大家介紹了基于LabVIEW+YOLOv3/YOLOv4的物體識(shí)別(對(duì)象檢測(cè)),今天接著上次的內(nèi)容再來(lái)看看YOLOv5。本次主要是和大家分享使用LabVIEW快速實(shí)現(xiàn)yolov5的物體識(shí)別

2023-03-13 16:01:07 1564

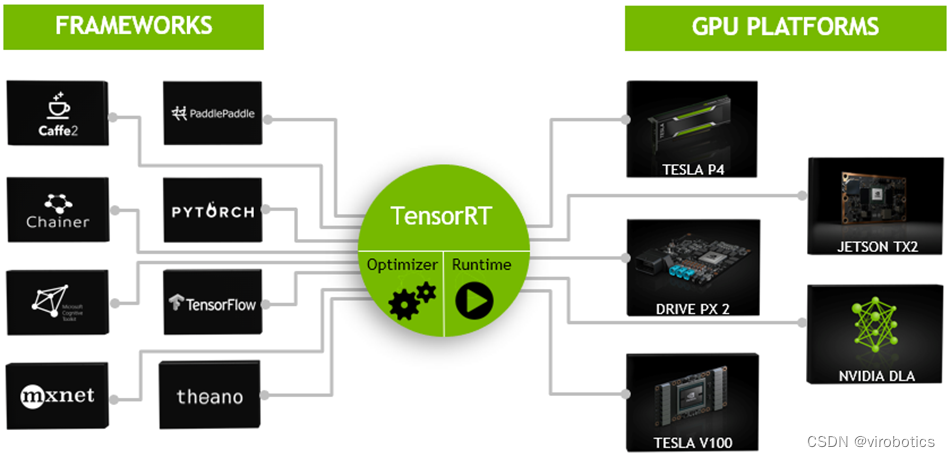

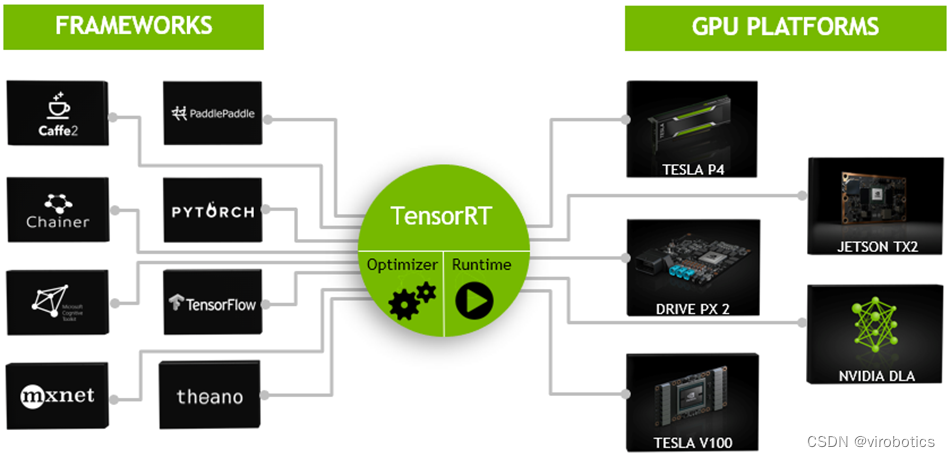

1564 今天我們就一起來(lái)看一下如何使用LabVIEW開放神經(jīng)網(wǎng)絡(luò)交互工具包實(shí)現(xiàn)TensorRT加速YOLOv5

2023-03-20 16:36:12 2101

2101

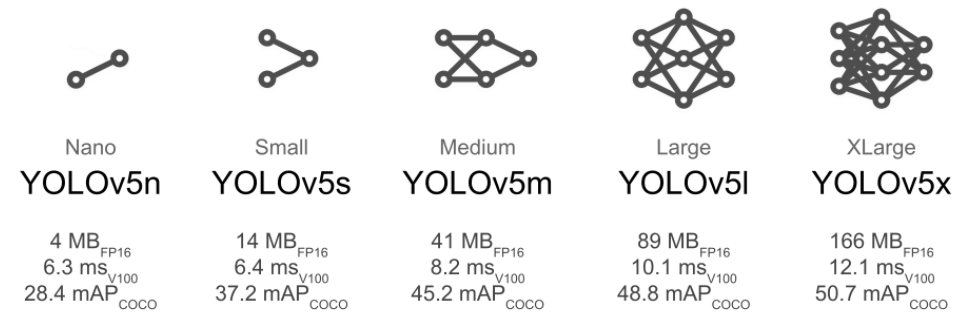

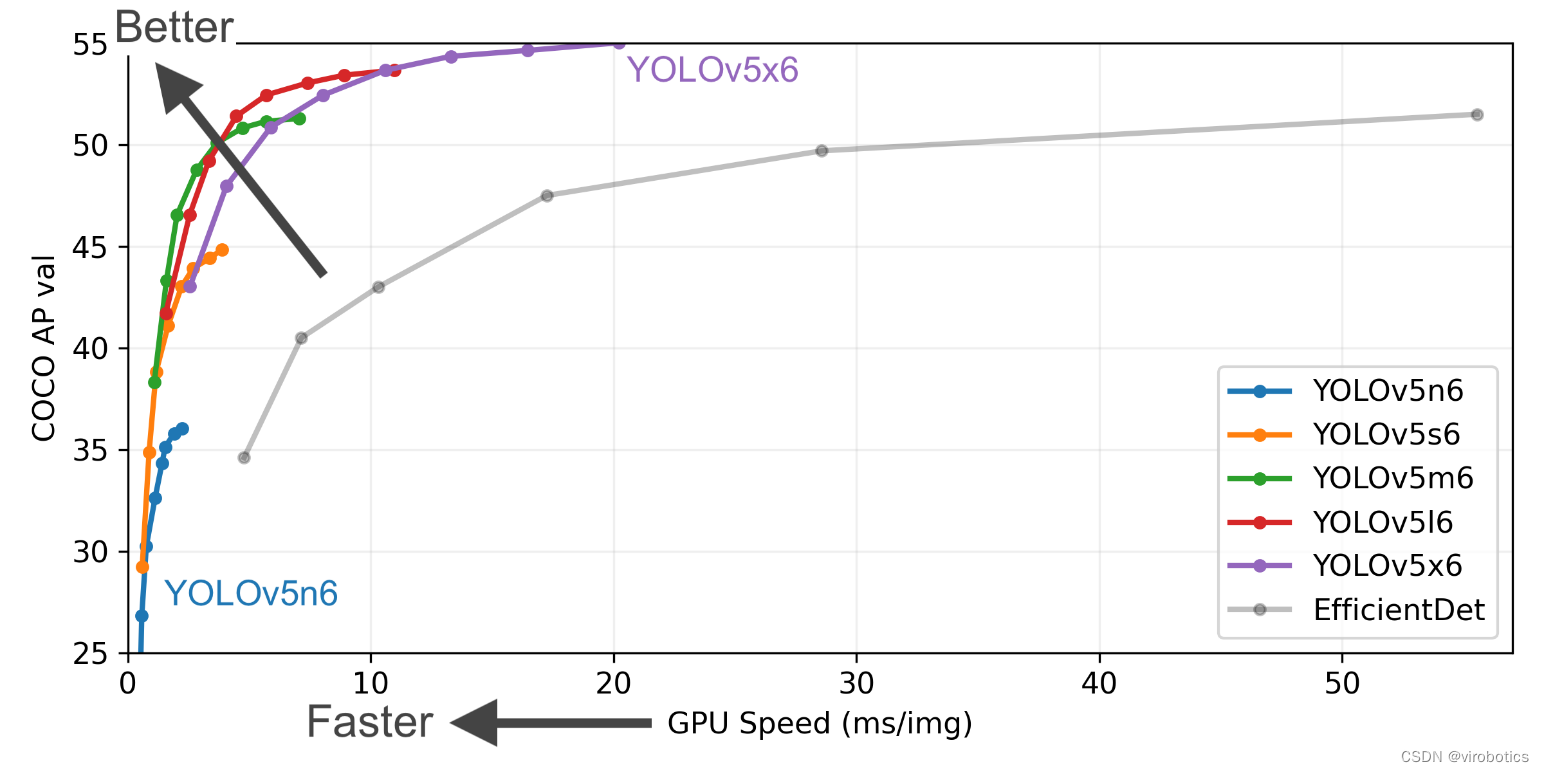

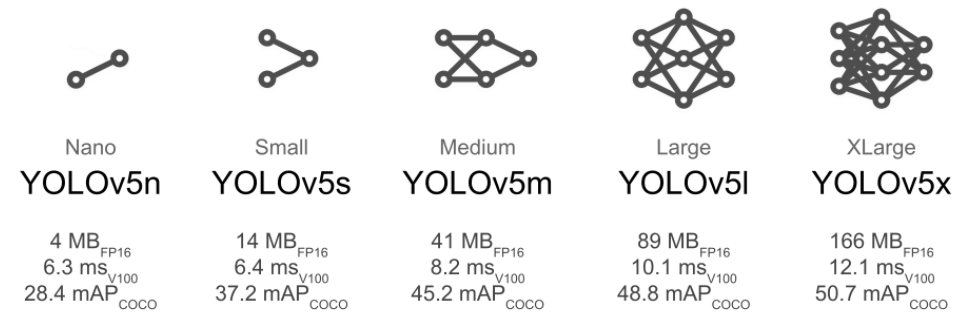

yolov5于2020年由glenn-jocher首次提出,直至今日yolov5仍然在不斷進(jìn)行升級(jí)迭代。 Yolov5有YOLOv5s、YOLOv5m、YOLOv5l、YOLOv5x四個(gè)版本。文件

2023-05-17 16:38:53 3582

3582

今天主要和大家分享在LabVIEW中使用純TensoRT工具包快速部署并實(shí)現(xiàn)yolov5的物體識(shí)別

2023-08-21 22:20:21 741

741

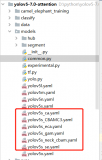

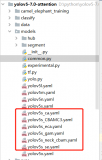

YOLOv5兼具速度和精度,工程化做的特別好,Git clone到本地即可在自己的數(shù)據(jù)集上實(shí)現(xiàn)目標(biāo)檢測(cè)任務(wù)的訓(xùn)練和推理,在產(chǎn)業(yè)界中應(yīng)用廣泛。開源社區(qū)對(duì)YOLOv5支持實(shí)例分割的呼聲高漲,YOLOv5在v7.0中正式官宣支持實(shí)例分割。

2023-12-21 10:17:33 912

912

):分類器把負(fù)例正確的分類-預(yù)測(cè)為負(fù)例(yolov5中沒(méi)有應(yīng)用到) yolov5中沒(méi)有應(yīng)用TN的原因: TN代表的是所有可能的未正確檢測(cè)到的邊界框。然而在yolo在目標(biāo)檢測(cè)任務(wù)中,每個(gè)網(wǎng)格會(huì)生成很多的預(yù)測(cè)

2022-11-21 16:40:45

1、YOLOv5 網(wǎng)絡(luò)結(jié)構(gòu)解析 YOLOv5針對(duì)不同大小(n, s, m, l, x)的網(wǎng)絡(luò)整體架構(gòu)都是一樣的,只不過(guò)會(huì)在每個(gè)子模塊中采用不同的深度和寬度, 分別應(yīng)對(duì)yaml文件中

2022-10-31 16:30:17

for Neuron Network is launched.

# Target: BM1684

#

# Net name: yolov5s

#

# Copyright

2023-09-15 06:23:37

yolov5-face的pt模型是怎樣轉(zhuǎn)為onnx模型的?有哪些轉(zhuǎn)換步驟?

2022-02-21 07:19:37

版本是230501

torch的版本是v1.8.0+cpu

下載yolov5官方的yolov5s.pt

執(zhí)行 python3 export.py --weights ./yolov5

2023-09-18 08:01:25

問(wèn)題描述:

1. yolov5模型pt轉(zhuǎn)bmodel可以識(shí)別出結(jié)果。(轉(zhuǎn)化成功,結(jié)果正確)

2. yolov5模型pt轉(zhuǎn)onnx轉(zhuǎn)bmodel可以無(wú)法識(shí)別出結(jié)果。(轉(zhuǎn)化成功,結(jié)果沒(méi)有)

配置:

1.

2023-09-15 07:30:45

使用自己訓(xùn)練的模型進(jìn)行轉(zhuǎn)換報(bào)錯(cuò),錯(cuò)誤如下:

root@docker-desktop:/workspace/yolov5-hat# python3 -m bmnetp --model=weights

2023-09-18 09:16:36

yolov5 訓(xùn)練的 tflite 模型進(jìn)行對(duì)象檢測(cè)不適用于 NNStreamer 2.2.0-r0。在之前的 NNStreamer 2.1.1 版本中,我曾經(jīng)獲取檢測(cè)框,而當(dāng)前版本顯示框架的標(biāo)簽

2023-05-17 12:44:23

第一個(gè)我是轉(zhuǎn)onnx時(shí) 想把權(quán)重文件變小點(diǎn) 就用了半精度 --half,則說(shuō)17版本不支持半精度 后面則是沒(méi)有縮小的單精度 但是顯示哪里溢出了···· 也不說(shuō)是哪里、、。。。 到底能不能部署yolov5這種東西啊?? 也沒(méi)看見幾個(gè)部署在這上面......................

2024-03-14 06:23:50

第一個(gè)我是轉(zhuǎn)onnx時(shí) 想把權(quán)重文件變小點(diǎn) 就用了半精度 --half,則說(shuō)17版本不支持半精度 后面則是沒(méi)有縮小的單精度 但是顯示哪里溢出了···· 也不說(shuō)是哪里、 到底能不能部署yolov5這種東西啊?? 也沒(méi)看見幾個(gè)部署在這上面......................

2023-08-08 07:55:25

model_deploy.py --mlir yolov5l.mlir --quantize INT8 --calibration_table yolov5l_cali_table --chip

2024-01-10 06:40:14

本人將yolov5s的pt模型轉(zhuǎn)為onnx模型(不包含detect層),再將onnx模型轉(zhuǎn)為量化的rknn模型,采用相同的圖片進(jìn)行的輸出對(duì)比,余弦相似度和輸出數(shù)值基本無(wú)偏差,但是將量化的rknn模型

2022-03-16 19:16:02

CV之YOLOv3:深度學(xué)習(xí)之計(jì)算機(jī)視覺(jué)神經(jīng)網(wǎng)絡(luò)Yolov3-5clessses訓(xùn)練自己的數(shù)據(jù)集全程記錄

2018-12-24 11:51:47

別人的錯(cuò)誤

cd /home

git clone https://github.com/ultralytics/yolov5.git

cd yolov5

pip3 install ultralytics

2023-10-17 21:24:09

問(wèn)題描述及復(fù)現(xiàn)步驟:【問(wèn)題描述】按照rknn sdk linux 1.3.0版本快速上手指南中的指導(dǎo),在ITX-3588J中實(shí)現(xiàn)yolov5的例程。(1)外接PC,通過(guò)adb方式,運(yùn)行python

2022-08-25 16:38:19

我把官方yolov5的demo輸入改成了rtsp視頻流,想測(cè)試多路的性能。一共打開了8路相機(jī),開始是正常的,運(yùn)行了一段時(shí)間后開始提示:RgaBlit(1387) RGA_BLIT fail

2022-08-26 16:38:26

./yolox_sail.arm video data/video/1080p_1.mp4 data/models/BM1684/yolox_s_fp32_1b.bmodel 10 0.3 0.5

2023-09-18 08:39:41

RKNN1 YOLOV5 DEMO及與RKNN2硬件對(duì)比

introduct

Rockchip 的 RKNN(Rockchip Neural Network) 是一款 AI 推理框架,能夠在

2023-05-31 21:49:42

非常方便。三、模型的轉(zhuǎn)換 這次的驗(yàn)證是把YOLOv5模型在rknn跑起來(lái)。YOLOv5的代碼是開源的,可以從github上克隆其源碼。YOLOv5更新了5個(gè)分支了,分別

2023-03-08 00:43:11

通過(guò)開發(fā)板上預(yù)制的ax_run_model 工具,測(cè)試模型速度和精度。

示例都是yolov5的,沒(méi)有yolov8,模型怎么運(yùn)行還需進(jìn)一步研究。

2023-11-20 12:19:32

ax_ppyoloe_obj365ax_scrfdax_yolov5_faceax_yolov7ax_yolox

ax_glpdepthax_pfldax_pp_person_attribute

2023-11-13 11:04:14

愛芯元智AX650N部署yolov5s 自定義模型

本博客將向你展示零基礎(chǔ)一步步的部署好自己的yolov5s模型(博主展示的是安全帽模型),利用yolov5 官方的代碼工具導(dǎo)出onnx模型,并通過(guò)

2023-11-16 19:34:46

繼上文開箱后,本文主要依托愛芯元智官方的實(shí)例,進(jìn)行官方YOLOV5模型的部署和測(cè)試。

一、環(huán)境搭建

由于8核A55的SoC,加上目前Debian OS的工具齊全,所以決定直接在板上編譯程序

2023-12-12 22:58:48

的時(shí)機(jī)(yolov5s 模型,輸入為 448x448 ~ 70ms)。 現(xiàn)在我正在嘗試使用 Yolov5(uint8 量化),但我嘗試使用不同的預(yù)訓(xùn)練模型獲得相同的行為,在 CPU 上進(jìn)行良好檢測(cè),在

2023-03-31 07:38:53

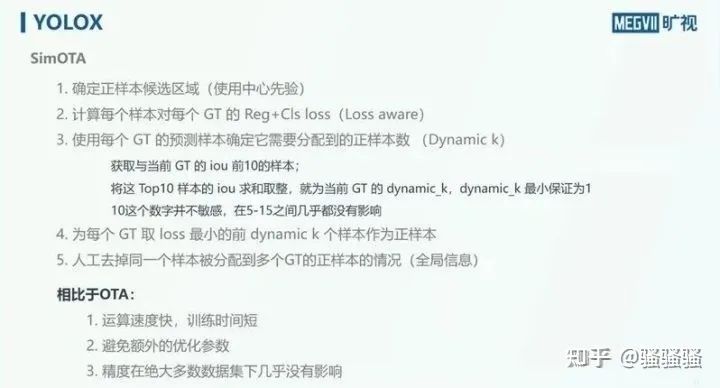

并應(yīng)用于邊界框回歸損失中,提高了 YOLOX 在 KITTI 數(shù)據(jù)集上的檢測(cè)精度,檢測(cè)出更多的遮擋目標(biāo);采用動(dòng)態(tài)錨框來(lái)優(yōu)化置信度標(biāo)簽分配,生成更準(zhǔn)確的標(biāo)簽值以優(yōu)化模型訓(xùn)練,最終得到檢測(cè)性能更好的模型

2023-03-06 13:55:27

你好:

按Milk-V Duo開發(fā)板實(shí)戰(zhàn)——基于YOLOv5的目標(biāo)檢測(cè) 安裝好yolov5環(huán)境,在執(zhí)行main.py的時(shí)候會(huì)出錯(cuò),能否幫忙看下

main.py:

import torch

2023-09-18 07:47:45

使用文檔“使用 YOLOv5 進(jìn)行對(duì)象檢測(cè)”我試圖從文檔第 10 頁(yè)訪問(wèn)以下鏈接(在 i.MX8MP 上部署 yolov5s 的步驟 - NXP 社區(qū))

...但是這樣做時(shí)會(huì)被拒絕訪問(wèn)。該文檔沒(méi)有說(shuō)明需要特殊許可才能下載 test.zip 文件。NXP 的人可以提供有關(guān)如何訪問(wèn)測(cè)試代碼的信息嗎?

2023-05-18 06:08:45

將 YOLOv5 ONNX 模型轉(zhuǎn)換為 IR 格式:python /opt/intel/openvino_2021/deployment_tools/model_optimizer/mo.py

2023-08-15 08:14:54

在Python>=3.7.0環(huán)境中安裝requirements.txt,包括PyTorch>=1.7。模型和數(shù)據(jù)集從最新的 YOLOv5版本自動(dòng)下載。簡(jiǎn)單示例此示例從

2022-07-22 16:02:42

導(dǎo)出rknn模型使用官方onnx模型使用yolov5官方倉(cāng)庫(kù)導(dǎo)出模型,該demo創(chuàng)建時(shí)yolov5的最新節(jié)點(diǎn)sha碼為

2022-08-19 17:05:51

求大佬分享RK3399運(yùn)行瑞芯微官方yolov5 C++代碼

2022-03-07 06:33:00

在cache的相關(guān)操作中,cache控制器需要根據(jù)需求做出許多不同的選擇。例如:分配策略是否需要將數(shù)據(jù)從主存中分配到cache中;替換策略組相聯(lián)cache中,所有的way都已經(jīng)有填充數(shù)據(jù)了,miss

2022-06-15 16:24:48

請(qǐng)問(wèn)從yolov5訓(xùn)練出的.pt文件怎么轉(zhuǎn)換為k210可以使用的.kmodel文件?謝謝大家了

2023-09-13 07:31:49

步數(shù)的課程,希望學(xué)員學(xué)習(xí)后能在實(shí)際工業(yè)項(xiàng)目中落地應(yīng)用。本次課程將重點(diǎn)講解《YOLOv5》篇,讓沒(méi)有任何深度學(xué)習(xí)基礎(chǔ)的小白學(xué)員,通過(guò)視頻課程能動(dòng)手配置好yolov5環(huán)境,能利用自己的數(shù)據(jù)集訓(xùn)練模型,能

2021-09-03 09:39:28

低軌星座通信系統(tǒng)信道分配策略—強(qiáng)占預(yù)留信道策略略

在基于時(shí)間信道預(yù)留算法的基礎(chǔ)上,提出了一種改進(jìn)的低軌星座通信系統(tǒng)

2009-05-14 18:48:39 586

586

時(shí)隙分配技術(shù)是VHF/UHF數(shù)據(jù)鏈中的一項(xiàng)關(guān)鍵技術(shù),通過(guò)它可以提高系統(tǒng)的通信效率。在目前VHF/UHF數(shù)據(jù)鏈的基礎(chǔ)上,提出了一種新的時(shí)隙分配高層算法:漸變分配策略,它主要是以固定分

2012-03-20 15:32:29 30

30 大樣本支持向量機(jī)分類策略研究_胡紅宇

2017-03-19 11:28:16 0

0 隨著生物信息學(xué)、基因表達(dá)譜微陣列、圖像識(shí)別等技術(shù)的發(fā)展,高維小樣本分類問(wèn)題成為數(shù)據(jù)挖掘(包括機(jī)器學(xué)習(xí)、模式識(shí)別)中的一項(xiàng)挑戰(zhàn)性任務(wù),容易引發(fā)維數(shù)災(zāi)難和過(guò)擬合問(wèn)題。針對(duì)這個(gè)問(wèn)題,特征選擇可以有效避免

2017-11-27 16:38:45 0

0 本文針對(duì)目前云數(shù)據(jù)中心主機(jī)服務(wù)器在空轉(zhuǎn)時(shí)間段對(duì)能源消耗巨大的問(wèn)題,建立了虛擬資源申請(qǐng)一分配模型,提出了一種虛擬資源分配的策略。該策略在滿足用戶需求前提下,對(duì)主機(jī)服務(wù)器最大化利用,以此來(lái)降低基礎(chǔ)設(shè)施

2017-12-08 10:15:39 0

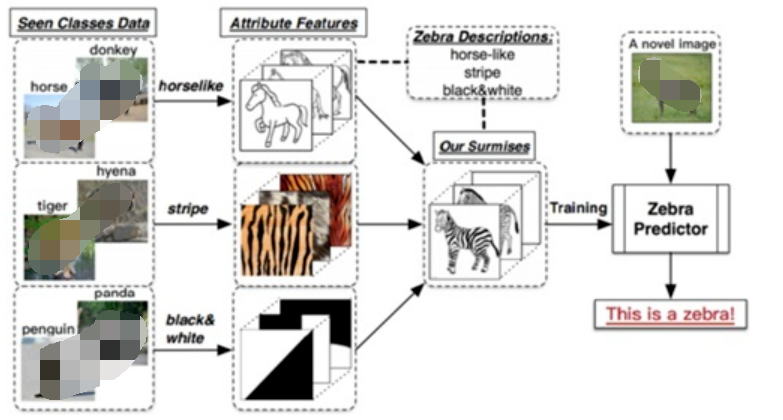

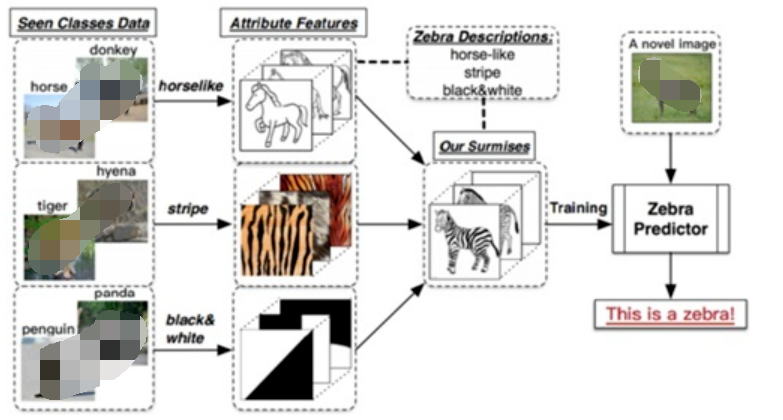

0 零樣本分類的目標(biāo)是對(duì)訓(xùn)練階段未出現(xiàn)過(guò)的類別的樣本進(jìn)行識(shí)別和分類,其主要思路是,借助類別語(yǔ)義信息,將可見類別的知識(shí)轉(zhuǎn)移到未見類別中.提出了一種直推式的字典學(xué)習(xí)方法,包含以下兩個(gè)步驟:首先,提出一個(gè)判別

2017-12-25 10:15:44 0

0 YoloV5期望你有兩個(gè)目錄,一個(gè)用于訓(xùn)練,一個(gè)用于驗(yàn)證。在這兩個(gè)目錄中,你需要另外兩個(gè)目錄,“Images”和“Labels”。Images包含實(shí)際的圖像,每個(gè)圖像的標(biāo)簽都應(yīng)該有一個(gè)帶有該圖像標(biāo)注的.txt文件,文本文件應(yīng)該有與其對(duì)應(yīng)的圖像相同的名稱。

2021-04-18 10:05:36 6115

6115

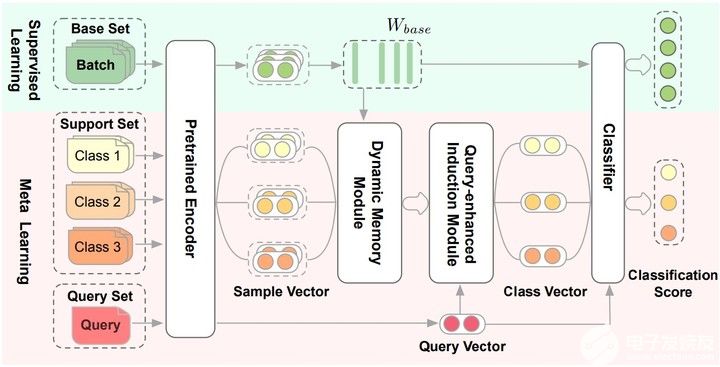

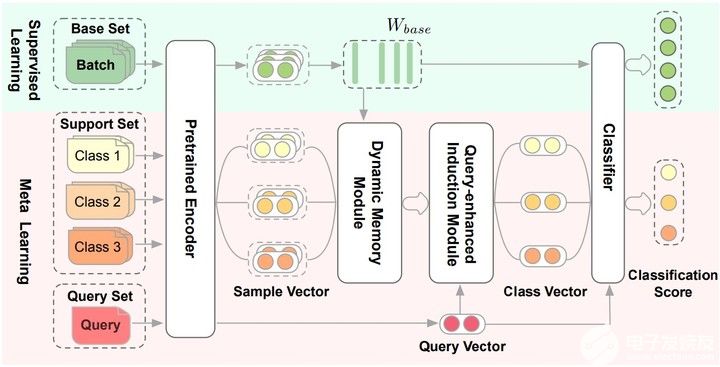

01 研究背景及動(dòng)機(jī) 近些年,元學(xué)習(xí)已經(jīng)成為解決小樣本問(wèn)題的主流技術(shù),并且取得不錯(cuò)的成果。然而,由于現(xiàn)有的元學(xué)習(xí)方法大多數(shù)集中在圖像分類上,而對(duì)文本分類上的關(guān)注比較少。與圖像不同,同一類別中文本具有

2021-05-19 15:54:15 4011

4011

論文提出Dynamic Memory Induction Networks (DMIN) 網(wǎng)絡(luò)處理小樣本文本分類。 兩階段的(two-stage)few-shot模型: 在監(jiān)督學(xué)習(xí)階段(綠色的部分

2021-09-27 17:46:08 1833

1833

本文轉(zhuǎn)自:知乎作者:djh一、環(huán)境準(zhǔn)備1.yolov5[鏈接]1、git clone 改模型。2、下載預(yù)編譯的模型,這里使用yolov5s2.ncnnReleases · Tenc...

2022-01-25 17:49:27 2

2 我記得大概是在去年七月份的時(shí)候我寫過(guò)一篇文章是介紹YOLOX+OpenVINO推理的,下載YOLOX的ONNX格式模型(github上可以下載)

2022-04-13 08:35:00 4798

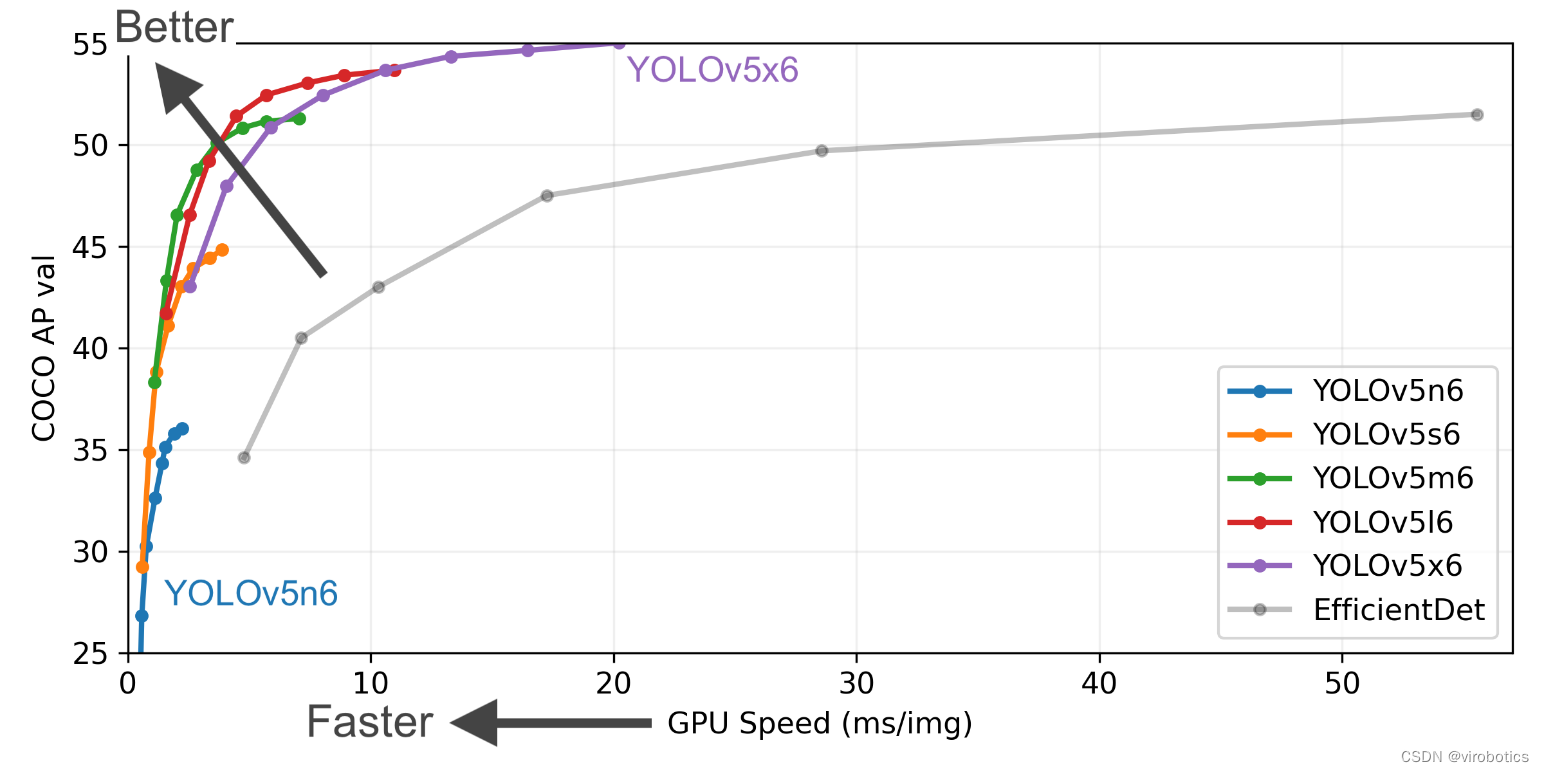

4798 曠視科技開源了內(nèi)部目標(biāo)檢測(cè)模型-YOLOX,性能與速度全面超越YOLOv5早期版本!

2022-04-16 23:00:27 2572

2572 ./oschina_soft/YOLOX.zip

2022-06-17 11:27:36 2

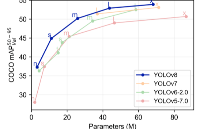

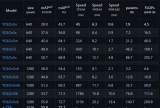

2 這里主要是對(duì)于YOLO系列經(jīng)典化模型的訓(xùn)練對(duì)比,主要是對(duì)于YOLOv5、YOLOv6、YOLOv7以及YOLOX的對(duì)比,部分模型還在訓(xùn)練之中,后續(xù)所有預(yù)訓(xùn)練權(quán)重均會(huì)放出,同時(shí)對(duì)應(yīng)的ONNX文件也會(huì)給出,方便大家部署應(yīng)用落地。

2022-07-31 11:47:48 1400

1400 最近小魚又整了一個(gè)開源庫(kù),結(jié)合YOLOV5訂閱圖像數(shù)據(jù)和相機(jī)參數(shù),直接給出一個(gè)可以給出識(shí)別物品的坐標(biāo)信息,方便進(jìn)行識(shí)別和抓取,目前適配完了2D相機(jī),下一步準(zhǔn)備適配3D相機(jī)。

2022-08-15 11:10:40 1990

1990 整個(gè)算法完全是以YOLOv5的框架進(jìn)行,主要包括的目標(biāo)檢測(cè)算法有:YOLOv3、YOLOv4、YOLOv5、YOLOv5-Lite、YOLOv6、YOLOv7、YOLOX以及YOLOX-Lite。

2022-08-16 10:24:27 555

555 并歸一化到0~1之間,這部分我寫了一個(gè)腳本來(lái)完成label標(biāo)簽的生成,把xml的標(biāo)注信息轉(zhuǎn)換為YOLOv5的labels文件,這樣就完成了數(shù)據(jù)集制作。最后需要?jiǎng)?chuàng)建一個(gè)dataset.ymal文件,放在與data文件夾同一層

2022-09-21 10:10:10 1036

1036 YOLOv5官方給出的YOLOv5在OpenCV上推理的程序相對(duì)來(lái)說(shuō)是比較通俗易懂的,條理清晰,有基本的封裝,直接可用!但是我也發(fā)現(xiàn),模型的推理時(shí)間跟前后處理的時(shí)間相差無(wú)幾,特別是當(dāng)視頻流有多個(gè)檢測(cè)到的對(duì)象時(shí)候,整個(gè)幀率會(huì)有明顯下降!官方推薦的參考示例代碼鏈接為:

2022-11-02 10:16:34 1242

1242 /Oneflow-Inc/one-yolov5/blob/734609fca9d844ac48749b132fb0a5777df34167/utils/metrics.py)中。這篇文章是《YOLOv5全面解析教程》四,目標(biāo)檢測(cè)模型精確度評(píng)估 的補(bǔ)充,希望能幫助到小伙伴們。

2022-11-21 15:27:29 1981

1981 (NITROS),其中包括針對(duì) NVIDIA GPU 和 Jetson 平臺(tái) 高度優(yōu)化的圖像處理和計(jì)算機(jī)視覺(jué)功能。 研討內(nèi)容 了解 NVIDIA Isaac ROS DNN推理管道,以及如何通過(guò) YOLOv5

2022-11-25 21:50:03 576

576 支持實(shí)例分割了,從此YOLOv5實(shí)現(xiàn)了圖像分類、對(duì)象檢測(cè)、實(shí)例分割三個(gè)支持,從訓(xùn)練到部署。

2022-11-30 15:55:47 2556

2556 本文將介紹在基于 OpenVINO 在英特爾獨(dú)立顯卡上部署 YOLOv5 實(shí)時(shí)實(shí)例分割模型的全流程,并提供完整范例代碼供讀者使用。

2022-12-20 11:32:14 2843

2843 本教程針對(duì)目標(biāo)檢測(cè)算法yolov5的訓(xùn)練和部署到EASY-EAI-Nano(RV1126)進(jìn)行說(shuō)明。

2023-01-05 18:00:32 2154

2154

rpn head的輸出是包括分類和回歸,分類是二分類,只區(qū)分前景和背景;回歸是僅僅對(duì)于前景樣本(正樣本)進(jìn)行基于anchor的變換回歸。rpn head的目的是提取roi,然后輸入到rcnn head部分進(jìn)行refine。

2023-01-06 14:44:27 818

818 下載并轉(zhuǎn)換YOLOv5預(yù)訓(xùn)練模型的詳細(xì)步驟,請(qǐng)參考:《基于OpenVINO?2022.2和蝰蛇峽谷優(yōu)化并部署YOLOv5模型》,本文所使用的OpenVINO是2022.3 LTS版。

2023-02-15 16:53:56 2071

2071 本次主要介紹在旭日x3的BPU中部署yolov5。首先在ubuntu20.04安裝yolov5,并運(yùn)行yolov5并使用pytoch的pt模型文件轉(zhuǎn)ONNX。

2023-04-26 14:20:39 479

479

本文以YOLOv5網(wǎng)絡(luò)模型為基礎(chǔ),提出一種改進(jìn)YOLOv5(YOLOv5-BC)深度學(xué)習(xí)滑坡災(zāi)害識(shí)別方法,將原有的PANet層替換為BiFPN結(jié)構(gòu),提高網(wǎng)絡(luò)多層特征融合能力

2023-05-17 17:50:37 859

859

5s基礎(chǔ)上實(shí)現(xiàn)五種視覺(jué)注意力模塊的改進(jìn),然后訓(xùn)練相同的輪次,橫向比較模型的精度。 YOLOv5添加注意模塊魔改 ?視覺(jué)注意力機(jī)制是一個(gè)好東西,即插即用,YOLOv5 7.0版本工程代碼簡(jiǎn)潔明了,代碼加入視覺(jué)注意力模塊支持異常方便,以SE注意力為例,只要三步即可完成: 1. 修改模型

2023-06-02 14:52:35 841

841

模型。支持模型遠(yuǎn)程加載與本地推理、當(dāng)前Pytorch Hub已經(jīng)對(duì)接到Torchvision、YOLOv5、YOLOv8、pytorchvideo等視覺(jué)框架。

2023-06-09 11:36:27 669

669

從上面可以看出,YOLOv8 主要參考了最近提出的諸如 YOLOX、YOLOv6、YOLOv7 和 PPYOLOE 等算法的相關(guān)設(shè)計(jì),本身的創(chuàng)新點(diǎn)不多,偏向工程實(shí)踐,主推的還是 ultralytics 這個(gè)框架本身。

2023-06-15 17:15:03 5468

5468

本教程針對(duì)目標(biāo)檢測(cè)算法yolov5的訓(xùn)練和部署到EASY-EAI-Nano(RV1126)進(jìn)行說(shuō)明,而數(shù)據(jù)標(biāo)注方法可以參考我們往期的文章《Labelimg的安裝與使用》。

2023-01-29 15:25:22 2421

2421

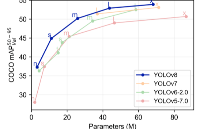

YOLO作為一種基于圖像全局信息進(jìn)行預(yù)測(cè)的目標(biāo)檢測(cè)系統(tǒng),始終保持著極高的迭代更新率,從YOLOv5到YOLOv8,本次升級(jí)主要包括結(jié)構(gòu)算法、命令行界面、PythonAPI等。具體到YOLOv8,它可

2023-02-28 11:16:02 1330

1330

搭建環(huán)境時(shí)由于版本的不同會(huì)遇各種問(wèn)題,下面我會(huì)提供我配置好的環(huán)境所需的包文件版本,文件位于壓縮包的requirements文件夾中的conda-yolov5_6-env.yaml。在Conda終端中創(chuàng)建新環(huán)境,執(zhí)行

2023-06-30 15:41:02 860

860

深度學(xué)習(xí)模型部署有OpenVINO、ONNXRUNTIME、TensorRT三個(gè)主流框架,均支持Python與C++的SDK使用。對(duì)YOLOv5~YOLOv8的系列模型,均可以通過(guò)C++推理實(shí)現(xiàn)模型

2023-08-06 11:39:17 1673

1673 YOLOv8是YOLO系列模型的最新王者,各種指標(biāo)全面超越現(xiàn)有對(duì)象檢測(cè)與實(shí)例分割模型,借鑒了YOLOv5、YOLOv6、YOLOX等模型的設(shè)計(jì)優(yōu)點(diǎn),全面提升改進(jìn)YOLOv5的模型結(jié)構(gòu)基礎(chǔ)上實(shí)現(xiàn)同時(shí)保持了YOLOv5工程化簡(jiǎn)潔易用的優(yōu)勢(shì)。

2023-08-10 11:35:39 643

643

很多人也想跟修改YOLOv5源碼一樣的方式去修改YOLOv8的源碼,但是在github上面卻發(fā)現(xiàn)找到的YOLOv8項(xiàng)目下面TAG分支是空的

2023-08-11 14:14:40 2324

2324

很多人也想跟修改YOLOv5源碼一樣的方式去修改YOLOv8的源碼,但是在github上面卻發(fā)現(xiàn)找到的YOLOv8項(xiàng)目下面TAG分支是空的,然后就直接從master/main下面把源碼克隆出來(lái)一通

2023-09-04 10:02:54 1036

1036

前面已經(jīng)講過(guò)了Yolov5模型目標(biāo)檢測(cè)和分類模型訓(xùn)練流程,這一篇講解一下yolov5模型結(jié)構(gòu),數(shù)據(jù)增強(qiáng),以及訓(xùn)練策略。

2023-09-11 11:15:21 843

843

網(wǎng)絡(luò)在初始錨框的基礎(chǔ)上 基于訓(xùn)練數(shù)據(jù) 輸出預(yù)測(cè)框,因此初始錨框也是比較重要的一部分。見配置文件*.yaml, yolov5預(yù)設(shè)了COCO數(shù)據(jù)集640×640圖像大小的錨定框的尺寸:

2023-09-12 17:08:39 334

334

零樣本分類的技術(shù)目前正處于高速發(fā)展時(shí)期, 所涉及的具體應(yīng)用已經(jīng)從最初的圖像分類任務(wù)擴(kuò)展到了其他計(jì)算機(jī)視覺(jué)任務(wù)乃至自然語(yǔ)言處理等多個(gè)相關(guān)領(lǐng)域。 對(duì)此, 本文將其稱為廣義零樣本分類。 相應(yīng)地, 我們將針對(duì)圖像分類任務(wù)的零樣本分類任務(wù)稱為狹義零樣本分類。

2023-09-22 11:10:25 793

793

自從YOLOv5更新成7.0版本,YOLOv8推出以后,OpenCV4.6以前的版本都無(wú)法再加載導(dǎo)出ONNX格式模型了,只有OpenCV4.7以上版本才可以支持最新版本YOLOv5與YOLOv8模型的推理部署。首先看一下最新版本的YOLOv5與YOLOv8的輸入與輸出格式。

2023-09-27 11:07:05 631

631

Yolov3是目標(biāo)檢測(cè)Yolo系列非常非常經(jīng)典的算法,不過(guò)很多同學(xué)拿到Yolov3或者Yolov4的cfg文件時(shí),并不知道如何直觀的可視化查看網(wǎng)絡(luò)結(jié)構(gòu)。

2024-01-11 10:42:13 159

159

我用QT C++寫了一個(gè)YOLOv5模型推理演示應(yīng)用。

2024-01-26 10:17:49 268

268

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論