最近幾個(gè)月,隨著ChatGPT的現(xiàn)象級(jí)表現(xiàn),大模型如雨后春筍般涌現(xiàn)。而模型推理是抽象的算法模型觸達(dá)具體的實(shí)際業(yè)務(wù)的最后一公里。 但是在這個(gè)環(huán)節(jié)中,仍然還有很多已經(jīng)是大家共識(shí)的痛點(diǎn)和訴求,比如: 任何

2023-05-18 14:35:17 2000

2000

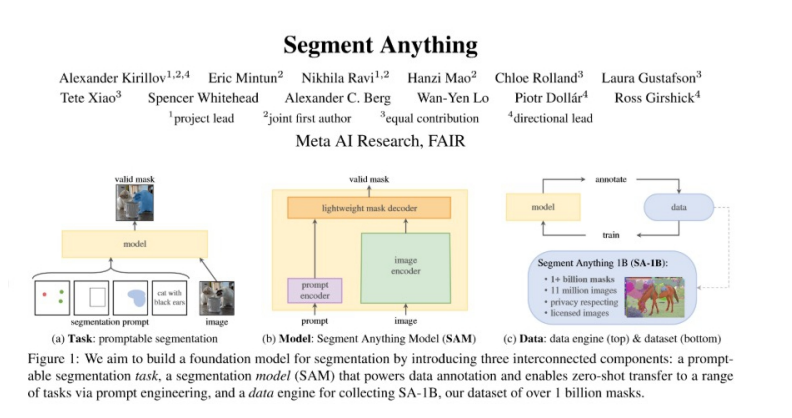

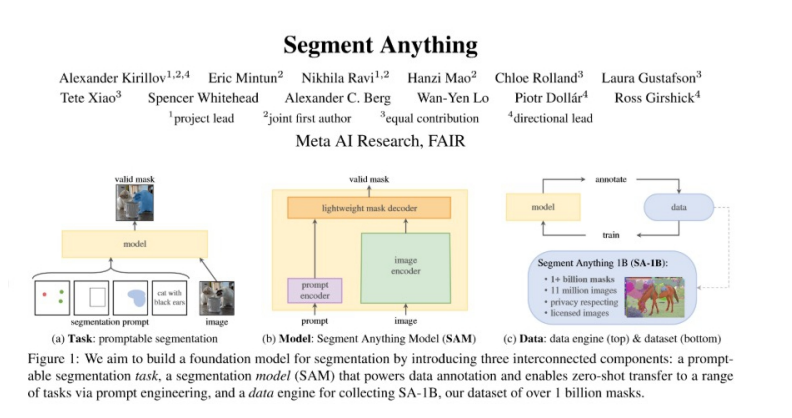

在一起,從而顯著提升模型的泛化能力。SAM 的設(shè)計(jì)初衷是簡(jiǎn)化圖像分割的過(guò)程,減少對(duì)專業(yè)建模知識(shí)的依賴,并降低大規(guī)模訓(xùn)練所需的計(jì)算資源。

2023-08-21 04:02:50 1293

1293

一、概述本文介紹了AscendCL模型推理相關(guān)知識(shí),介紹了AscendCL接口加載離線模型,為離線模型準(zhǔn)備數(shù)據(jù)結(jié)構(gòu)以及調(diào)用離線模型進(jìn)行推理的過(guò)程。簡(jiǎn)單來(lái)說(shuō),曻騰的AscendCL的推理工程可以問(wèn)為

2023-08-24 11:04:14

DLLite-Micro 是一個(gè)輕量級(jí)的 AI 推理框架,可以為 OpenHarmony OS 的輕量設(shè)備和小型設(shè)備提供深度模型的推理能力DLLite-Micro 向開(kāi)發(fā)者提供清晰、易上手的北向接口

2021-08-05 11:40:11

道。 本次實(shí)驗(yàn)快速圓滿完成,得益于NetBox操作簡(jiǎn)單、無(wú)需編譯的特性,能實(shí)現(xiàn)快速上手且精準(zhǔn)驗(yàn)證的體驗(yàn),助力科研高效發(fā)展。 NetBox 是一款基于FPGA的電力電子實(shí)時(shí)仿真產(chǎn)品。FPGA無(wú)需編譯,直接

2022-12-14 10:24:50

場(chǎng)景介紹

MindSpore Lite 是一款 AI 引擎,它提供了面向不同硬件設(shè)備 AI 模型推理的功能,目前已經(jīng)在圖像分類、目標(biāo)識(shí)別、人臉識(shí)別、文字識(shí)別等應(yīng)用中廣泛使用。

本文介紹

2023-12-14 11:41:13

首個(gè)獨(dú)立AI推理基準(zhǔn)測(cè)試 ——MLPerf Inference 0.5中取得第一名。由于推理一直是AI市場(chǎng)中最大、同時(shí)也是最具競(jìng)爭(zhēng)力的領(lǐng)域,業(yè)內(nèi)此前一直希望能夠有一套客觀的推理性能測(cè)試指標(biāo)。在參與

2019-11-08 19:44:51

k210可以采集傳感器的數(shù)據(jù)進(jìn)行模型的推理嗎?

2023-09-14 08:52:56

使用rknn的api讀取我的模型,進(jìn)行轉(zhuǎn)換api可以成功轉(zhuǎn)換出rknn模型,但遇到的問(wèn)題是:我使用測(cè)試數(shù)據(jù)調(diào)用rknn.inference進(jìn)行推理,每一次的輸出結(jié)果都為[array([nan, nan

2023-01-11 18:45:48

為開(kāi)發(fā)者提供一個(gè)簡(jiǎn)單且高效的開(kāi)發(fā)平臺(tái)。雖然LuckFox Pico作為入門(mén)級(jí)開(kāi)發(fā)板只有幾十塊錢(qián),但是它具有人工智能協(xié)處理器NPU,也可以實(shí)現(xiàn)人工智能的推理工作。瑞芯微 RV1103芯片采用了和RK3568

2023-11-11 16:51:53

設(shè)備的資源限制。此外,TinyML還依賴于優(yōu)化的推理引擎和針對(duì)嵌入式設(shè)備的硬件加速器,以實(shí)現(xiàn)高效的模型推理。

TinyML的應(yīng)用領(lǐng)域非常廣泛,包括智能傳感器、健康監(jiān)測(cè)、物聯(lián)網(wǎng)、智能音頻處理、自動(dòng)駕駛

2023-12-22 10:12:25

SAM3U處理器的內(nèi)部結(jié)構(gòu) 1.3.3 SAM3U系列MCU的優(yōu)點(diǎn) 1.3.4 SAM3 MCU的開(kāi)發(fā)工具第2章 CortexM3 處理器編程模型 2.1 寄存器組 2.1.1 通用寄存器

2014-03-13 11:00:26

/main/detail。ChatGLM3 的推理框架是基于最新的高效動(dòng)態(tài)推理和顯存優(yōu)化技術(shù)構(gòu)建的,在相同硬件、模型條件下,相較于目前最佳的開(kāi)源實(shí)現(xiàn),對(duì)比伯克利大學(xué)推出的 vLLM 以及 Hugging

2023-12-17 22:54:49

研的人工智能協(xié)處理器NPU,并且提供了RKNN-Toolkit。今天就介紹一下如何使用RKNN模型進(jìn)行推理應(yīng)用程序開(kāi)發(fā)。一、推理應(yīng)用程序的基本流程RKNN 是 瑞芯微(Rockchip) NPU平臺(tái)

2022-12-08 19:06:16

主要內(nèi)容本文提出了一種不依賴于棋盤(pán)格等輔助標(biāo)定物體,實(shí)現(xiàn)像素級(jí)相機(jī)和激光雷達(dá)自動(dòng)標(biāo)定的方法。方法直接從點(diǎn)云中提取3D邊特征,一避免遮擋問(wèn)題,并且使用了精確度更高的深度連續(xù)邊。文中首先指出:以下四種

2021-09-01 07:42:19

使用rk3588多npu推理模型,模型總推理時(shí)間還增加了,這怎么解釋

2023-11-05 18:22:42

關(guān)于 TinyMaixTinyMaix是面向單片機(jī)的超輕量級(jí)的神經(jīng)網(wǎng)絡(luò)推理庫(kù),即TinyML推理庫(kù),可以讓你在任意單片機(jī)上運(yùn)行輕量級(jí)深度學(xué)習(xí)模型~設(shè)計(jì)原則:易用性 > 移植性 &

2022-09-21 09:56:29

你好我使用 STM32CUBE-AI v5.1.2 ApplicationTemplate 將簡(jiǎn)單的 CNN 導(dǎo)入到 STM32L462RCT我發(fā)現(xiàn)壓縮模型對(duì)推理時(shí)間沒(méi)有影響。aiRun 程序在 8

2023-01-29 06:24:08

出色的 ML 推理性能。例如,其能夠以良好的功率表現(xiàn)執(zhí)行 MobileNet v2 等最先進(jìn)的移動(dòng)視覺(jué)模型,且 fps 可達(dá) 100 以上。這意味著你將能夠在符合節(jié)能與隱私保護(hù)要求的前提下,將快速 ML

2019-03-05 21:20:23

當(dāng)我為 TFLite 模型運(yùn)行基準(zhǔn)測(cè)試時(shí),有一個(gè)選項(xiàng) --nnapi=true我如何知道 GPU 和 NPU 何時(shí)進(jìn)行推理?謝謝

2023-03-20 06:10:30

使用 PyTorch 對(duì)具有非方形圖像的 YOLOv4 模型進(jìn)行了訓(xùn)練。

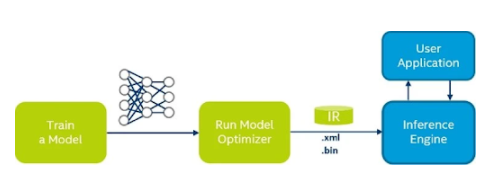

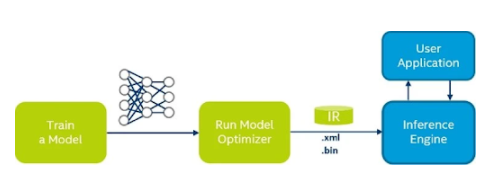

將 權(quán)重轉(zhuǎn)換為 ONNX 文件,然后轉(zhuǎn)換為中間表示 (IR)。

無(wú)法確定如何獲得更好的推理性能。

2023-08-15 06:58:00

如何實(shí)現(xiàn)具有RTD級(jí)精度且無(wú)需校準(zhǔn)快速溫度傳感器設(shè)計(jì)

2021-01-07 06:27:14

EPP技術(shù)和CPLD技術(shù)介紹應(yīng)用CPLD及EPP技術(shù)對(duì)CCD信號(hào)像素級(jí)的高速采集

2021-04-08 06:11:10

PyTorch Hub 加載預(yù)訓(xùn)練的 YOLOv5s 模型,model并傳遞圖像進(jìn)行推理。'yolov5s'是最輕最快的 YOLOv5 型號(hào)。有關(guān)所有可用模型的詳細(xì)信息,請(qǐng)參閱自述文件。詳細(xì)示例此示例

2022-07-22 16:02:42

rk1808 相同模型速度變慢: rknn_server 0.9.4 (2078225 build: 2019-03-07 20:07:28) librknn_runtime version

2022-04-21 11:36:29

生成兩個(gè) IR文件(相同的 .xml 文件,但不同的 .bin 文件)

具有不同重量的類似模型,以不同的 fps (27fps 和 6fps) 運(yùn)行

更多樣化的權(quán)重是否會(huì)影響 Myriad X 上的推理性能?

2023-08-15 07:00:25

:管理資源引擎的相關(guān)內(nèi)容。Engine:推理引擎,推理的主要功能都由它管理。PluginManager:管理框架調(diào)度器的配置與工具。插件:管理框架與推理模型的加載、卸載。AIInterpreter:手機(jī)

2022-03-25 11:15:36

摘要本文為系列博客tensorflow模型部署系列的一部分,用于實(shí)現(xiàn)通用模型的部署。本文主要實(shí)現(xiàn)用tflite接口調(diào)用tensorflow模型進(jìn)行推理。相關(guān)源碼見(jiàn)鏈接引言本文為系列博客

2021-12-22 06:51:18

研華公司近期新推出了一款經(jīng)濟(jì)高效的入門(mén)級(jí)系統(tǒng)平臺(tái)。研華ARK-1310擁有緊湊型、無(wú)風(fēng)扇的鋁制機(jī)箱外殼,可安裝在任何大型系統(tǒng)中,也可作為獨(dú)立平臺(tái)單獨(dú)應(yīng)用。ARK-1310小巧緊湊、堅(jiān)固耐用,因此非常適合各種惡劣環(huán)境應(yīng)用和自動(dòng)化控制應(yīng)用。

2019-07-23 06:21:45

請(qǐng)問(wèn)模型推理只用到了kpu嗎?可以cpu,kpu,fft異構(gòu)計(jì)算嗎?

2023-09-14 08:13:24

與采用舊 CPU 的推理相比,在新 CPU 上推斷的 INT8 模型的推理速度更快。

2023-08-15 08:28:42

鑒于模型推理的入侵檢測(cè)方法,需要在龐大的審計(jì)記錄空間中搜索巨量的攻擊腳本子集中的最優(yōu)值,對(duì)于這一NP類完全問(wèn)題,提出了應(yīng)用模擬退火算法。并建立了攻擊檢測(cè)的優(yōu)化問(wèn)

2008-11-18 00:18:36 6

6 數(shù)據(jù)庫(kù)推理問(wèn)題是數(shù)據(jù)庫(kù)安全研究的重要分支方向,推理通道的分析是解決推理問(wèn)題的基礎(chǔ)。傳統(tǒng)推理規(guī)則無(wú)法處理不完全符合函數(shù)依賴的數(shù)據(jù)關(guān)系,針對(duì)這一問(wèn)題,本文提出了弱

2009-12-25 14:58:04 16

16 首個(gè)32 GB microSDHC存儲(chǔ)卡問(wèn)世

SanDisk(閃迪)宣布,閃迪專為手機(jī)打造的的大容量、移動(dòng)式存儲(chǔ)卡 ——32 gigabyte (GB)1 閃迪 microSDHC存儲(chǔ)卡——現(xiàn)已上市。全新

2010-03-25 17:20:33 1027

1027 我國(guó)自主研發(fā)的高效彩色太陽(yáng)能電池在長(zhǎng)問(wèn)世

記者今日從市科技局獲悉,繼湖南制造的高效彩色雙玻太陽(yáng)能電池組件亮相上海世博會(huì)

2010-04-12 08:34:06 432

432 超像素詞包模型與SVM分類的圖像標(biāo)注_於敏

2017-03-19 19:03:46 1

1 針對(duì)CLINK算法在路由改變時(shí)擁塞鏈路推理性能下降的問(wèn)題,建立一種變結(jié)構(gòu)離散動(dòng)態(tài)貝葉斯網(wǎng)模型,通過(guò)引入馬爾可夫性及時(shí)齊性假設(shè)簡(jiǎn)化該模型,并基于簡(jiǎn)化模型提出一種IP網(wǎng)絡(luò)擁塞鏈路推理算法(VSDDB

2018-01-16 18:46:26 0

0 SAM Boot Assistant(SAM-BA)允許使用USB或UART主機(jī)進(jìn)行在系統(tǒng)編程(ISP),而無(wú)需任何外部編程接口。

2018-07-20 10:48:11 5195

5195 日前,歐司朗光電半導(dǎo)體和Joyson Safety Systems 公司為新款凱迪拉克CT6配備了一款創(chuàng)新的半自動(dòng)駕駛系統(tǒng)。這款系統(tǒng)名為“超級(jí)巡航”(Super Cruise),是業(yè)內(nèi)首個(gè)真正的在高速上實(shí)現(xiàn)“無(wú)需雙手”的駕駛技術(shù)。

2018-09-13 15:10:47 2811

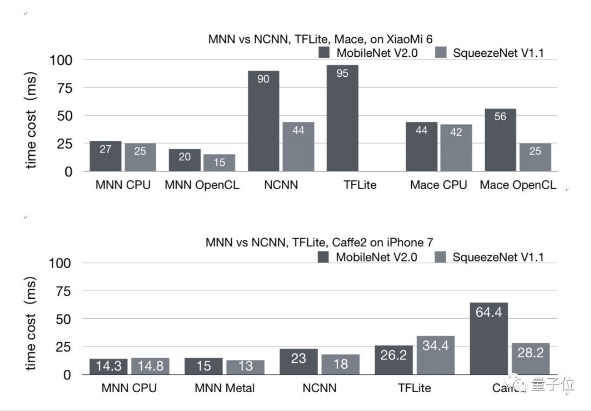

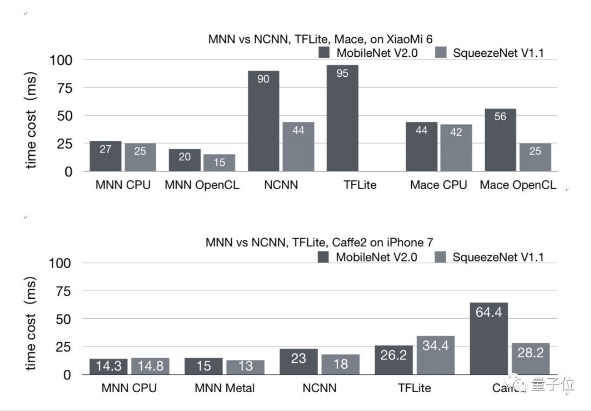

2811 阿里開(kāi)源首個(gè)移動(dòng)AI項(xiàng)目,淘寶同款推理引擎,這是阿里開(kāi)源的首個(gè)移動(dòng)AI項(xiàng)目,已經(jīng)用于阿里手機(jī)淘寶、手機(jī)天貓、優(yōu)酷等20多個(gè)應(yīng)用之中。覆蓋直播、短視頻、搜索推薦、商品圖像搜索、互動(dòng)營(yíng)銷、權(quán)益發(fā)放、安全風(fēng)控等場(chǎng)景。在IoT等移動(dòng)設(shè)備場(chǎng)景下,也有若干應(yīng)用。

2019-07-03 09:53:29 284

284

浪潮宣布開(kāi)源發(fā)布基于FPGA的高效AI計(jì)算框架TF2,這一框架的推理引擎采用全球首創(chuàng)的DNN移位計(jì)算技術(shù),結(jié)合多項(xiàng)最新優(yōu)化技術(shù),可實(shí)現(xiàn)通用深度學(xué)習(xí)模型基于FPGA芯片的高性能低延遲部署。

2019-09-09 14:17:53 932

932 浪潮宣布開(kāi)源發(fā)布基于FPGA的高效AI計(jì)算框架TF2,這一框架的推理引擎采用全球首創(chuàng)的DNN移位計(jì)算技術(shù),結(jié)合多項(xiàng)最新優(yōu)化技術(shù),可實(shí)現(xiàn)通用深度學(xué)習(xí)模型基于FPGA芯片的高性能低延遲部署,這也是全球首個(gè)包含從模型裁剪、壓縮、量化到通用模型實(shí)現(xiàn)等優(yōu)化算法的完整方案的FPGA上AI開(kāi)源框架。

2019-09-23 15:04:56 1799

1799 Adlik是LF AI中首個(gè)聚焦深度學(xué)習(xí)模型推理階段的項(xiàng)目,其宗旨是使深度學(xué)習(xí)模型能夠高效地運(yùn)行在多種部署環(huán)境下。

2019-10-11 09:15:53 1420

1420 來(lái)自中國(guó)航天科技集團(tuán)有限公司八院消息,近日,中國(guó)首個(gè)3.35米直徑火箭長(zhǎng)筒段貯箱在八院800所問(wèn)世。后續(xù),該技術(shù)將應(yīng)用于新一代運(yùn)載火箭中。

2021-02-27 09:38:08 1546

1546 分類問(wèn)題是數(shù)據(jù)挖掘和機(jī)器學(xué)習(xí)領(lǐng)域硏究的重點(diǎn)問(wèn)題,貝葉斯網(wǎng)絡(luò)模型因其簡(jiǎn)單髙效的特點(diǎn)而廣泛應(yīng)用于分類問(wèn)題。一依賴估測(cè)器(ODE)模型作為半監(jiān)督學(xué)習(xí)貝葉斯網(wǎng)絡(luò)模型中的經(jīng)典模型,受到研究人員的廣泛關(guān)注。現(xiàn)有

2021-03-17 15:05:10 12

12 本應(yīng)用筆記介紹將基于 SAM9x5 的設(shè)計(jì)移植到 SAM9X60 器件需進(jìn)行的硬件和軟件更改。SAM9X60 器件的性能優(yōu)于SAM9x5。

2021-03-30 16:26:31 2

2 數(shù)據(jù)中心網(wǎng)絡(luò)需要更加高效的推理模型提升流簇大小判斷的準(zhǔn)確性和敏感性。提岀了一種基于機(jī)器學(xué)習(xí)的流簇大小推理模型( Mlcoflow),利用極限學(xué)習(xí)杋(ELM)以最小訓(xùn)練誤差為求解目標(biāo)建立推理模型,并且使用不完全信息建模以提升敏感度。實(shí)驗(yàn)證

2021-04-02 11:38:16 34

34 基于像素級(jí)生成對(duì)抗網(wǎng)絡(luò)的圖像彩色化模型

2021-06-27 11:02:01 4

4 基于變量依賴關(guān)系模型的變量重要性度量綜述

2021-07-02 14:44:08 0

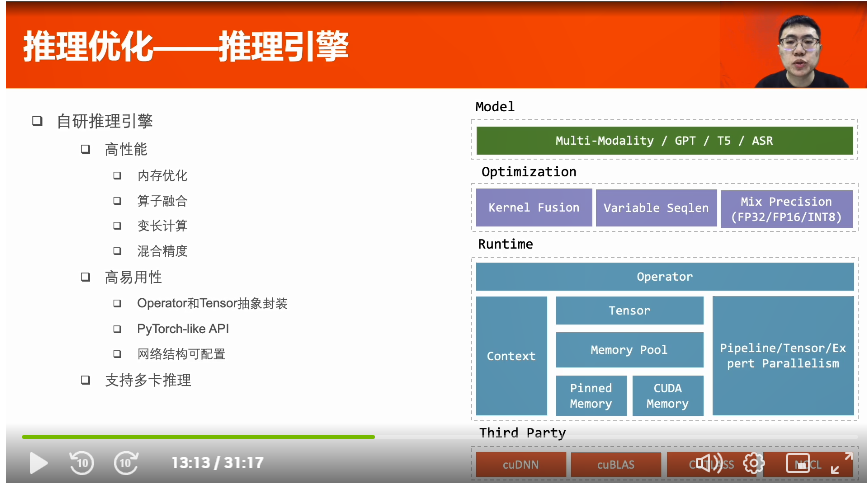

0 自然語(yǔ)言理解、匹配排序等等,這些模型的訓(xùn)練和推理都大量依賴于NVIDIA GPU,尤其在推理方面,NVIDIA GPU及相應(yīng)的解決方案都滿足了業(yè)務(wù)所需的延遲和吞吐要求。 微信搜索業(yè)務(wù)需要更高效平臺(tái) 微信搜索業(yè)務(wù)由多個(gè)子模塊構(gòu)成,包括查

2021-10-28 15:28:12 1551

1551 MegEngine「訓(xùn)練推理一體化」的獨(dú)特范式,通過(guò)靜態(tài)圖優(yōu)化保證模型精度與訓(xùn)練時(shí)一致,無(wú)縫導(dǎo)入推理側(cè),再借助工業(yè)驗(yàn)證的高效卷積優(yōu)化技術(shù)...

2022-02-07 10:59:49 0

0 的時(shí)延變長(zhǎng),GPU 使用效率不高。醫(yī)療影像推理的另一個(gè)需要考慮的問(wèn)題是如何實(shí)現(xiàn)高效的部署。我們往往需要部署多個(gè)醫(yī)療影像 AI 應(yīng)用,那么如何去調(diào)度多個(gè)模型,如何并發(fā)處理多個(gè)請(qǐng)求,并充分利用 GPU 資源成為挑戰(zhàn)。

2022-04-09 08:18:22 1042

1042 一個(gè)完整的醫(yī)療影像推理流程一般包含數(shù)據(jù)的前處理、AI 推理以及數(shù)據(jù)后處理這幾部分。

2022-04-10 15:06:09 2396

2396 “強(qiáng)悍的織女模型在京東探索研究院建設(shè)的全國(guó)首個(gè)基于 DGX SuperPOD 架構(gòu)的超大規(guī)模計(jì)算集群 “天琴α” 上完成訓(xùn)練,該集群具有全球領(lǐng)先的大規(guī)模分布式并行訓(xùn)練技術(shù),其近似線性加速比的數(shù)據(jù)、模型、流水線并行技術(shù)持續(xù)助力織女模型的高效訓(xùn)練。”

2022-04-13 15:13:11 783

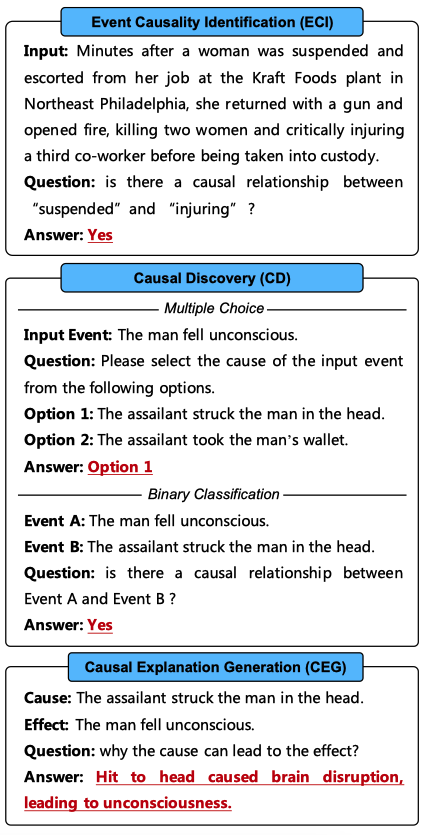

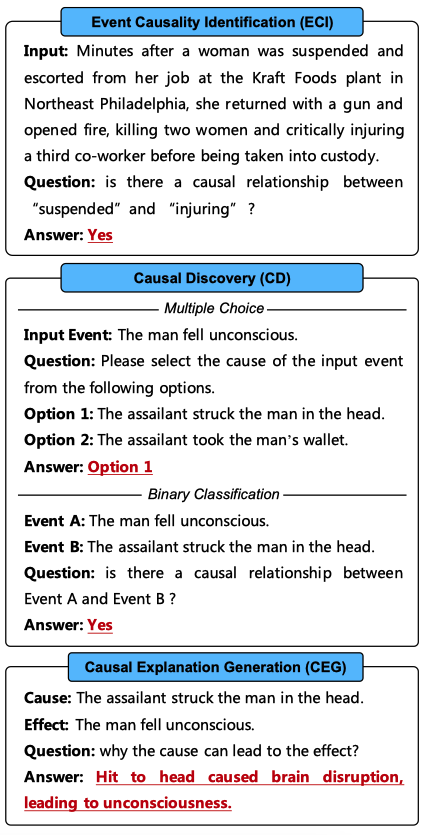

783 因果推理是人類的一項(xiàng)核心認(rèn)知能力。借助因果推理能力,人類得以理解已觀測(cè)到的各種現(xiàn)象,并預(yù)測(cè)將來(lái)可能發(fā)生的事件。然而,盡管當(dāng)下的各類因果推理模型已經(jīng)在現(xiàn)有的因果推理數(shù)據(jù)集上取得了令人印象深刻的性能,然而,這些模型與人類的因果推理能力相比仍存在顯著差距。

2022-05-16 16:21:26 1081

1081 NVIDIA Triton 推理服務(wù)器(以前稱為 TensorRT 推理服務(wù)器)是一款開(kāi)源軟件,可簡(jiǎn)化深度學(xué)習(xí)模型在生產(chǎn)環(huán)境中的部署。借助 Triton 推理服務(wù)器,Devops 和 MLops

2022-06-28 15:49:47 1293

1293 ??2022年7月25日,由科大訊飛承建的我國(guó)首個(gè)認(rèn)知智能全國(guó)重點(diǎn)實(shí)驗(yàn)室榮登科學(xué)常識(shí)推理挑戰(zhàn)賽OpenBookQA榜首,創(chuàng)新性提出X-Reasoner模型,以準(zhǔn)確率94.2%的絕對(duì)優(yōu)勢(shì)奪冠,常識(shí)推理

2022-07-25 23:00:28 488

488 推理引擎用于部署應(yīng)用程序。使用部署管理器,您可以通過(guò)將模型、IR 文件、應(yīng)用程序和相關(guān)依賴項(xiàng)組裝到目標(biāo)設(shè)備的運(yùn)行時(shí)包中來(lái)創(chuàng)建開(kāi)發(fā)包。

2022-08-16 11:27:29 439

439

螞蟻鏈 AIoT 團(tuán)隊(duì)與 NVIDIA 合作,將量化感知訓(xùn)練(QAT)技術(shù)應(yīng)用于深度學(xué)習(xí)模型性能優(yōu)化中,并通過(guò) NVIDIA TensorRT 高性能推理 SDK 進(jìn)行高效率部署, 通過(guò) INT8 推理, 吞吐量提升了 3 倍, 助力螞蟻鏈版權(quán) AI 平臺(tái)中的模型推理服務(wù)大幅降本增效。

2022-09-09 09:53:52 872

872 加速AI推理模型已成為一項(xiàng)基本任務(wù),因?yàn)槲覀冋鴦?chuàng)建更復(fù)雜,更高效的AI應(yīng)用程序邁進(jìn)。靈活和完整的AI輔助是在快速增長(zhǎng)的AI領(lǐng)域取得成功的關(guān)鍵組成部分。

2022-10-19 09:08:50 423

423 對(duì)您的 LED 進(jìn)行高效調(diào)光,無(wú)需檢測(cè)電阻器

2022-11-07 08:07:28 0

0 如果給語(yǔ)言模型生成一些 prompting,它還向人們展示了其解決復(fù)雜任務(wù)的能力。標(biāo)準(zhǔn) prompting 方法,即為使用少樣本的問(wèn)答對(duì)或零樣本的指令的一系列方法,已經(jīng)被證明不足以解決需要多個(gè)推理步驟的下游任務(wù)(Chowdhery 等,2022)。

2023-02-02 16:15:26 772

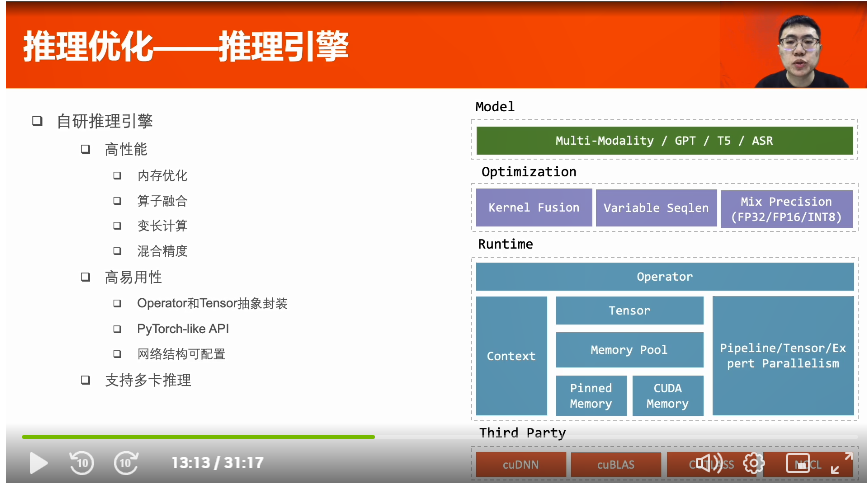

772 多卡推理--流水線并行:將模型和數(shù)據(jù)切分,以流水線形式計(jì)算,提高GPU利用率。模型切分策略:依照各部分的計(jì)算時(shí)間和參數(shù)量設(shè)計(jì)。

2023-03-23 18:17:33 1921

1921

在這些基礎(chǔ)模型中,Segment Anything Model(SAM)作為一個(gè)在大型視覺(jué)語(yǔ)料庫(kù)上訓(xùn)練的通用圖像分割模型取得了顯著的突破。事實(shí)證明,SAM在不同的場(chǎng)景下具有成功的分割能力,這使得它在圖像分割和計(jì)算機(jī)視覺(jué)的相關(guān)領(lǐng)域邁出了突破性的一步。

2023-04-20 10:13:37 1061

1061 SAM是一類處理圖像分割任務(wù)的通用模型。與以往只能處理某種特定類型圖片的圖像分割模型不同,SAM可以處理所有類型的圖像。

2023-05-20 09:30:45 1380

1380 SAM 是一個(gè)提示型模型,其在 1100 萬(wàn)張圖像上訓(xùn)練了超過(guò) 10 億個(gè)掩碼,實(shí)現(xiàn)了強(qiáng)大的零樣本泛化。許多研究人員認(rèn)為「這是 CV 的 GPT-3 時(shí)刻,因?yàn)?SAM 已經(jīng)學(xué)會(huì)了物體是什么的一般

2023-05-24 14:36:10 596

596

所以,這篇arXiv的論文提出了一個(gè)簡(jiǎn)單而有效的基于SAM大模型的視聽(tīng)定位和分割框架,即AV-SAM,它可以生成與音頻相對(duì)應(yīng)的發(fā)聲對(duì)象掩碼。具體而言,利用SAM中預(yù)先訓(xùn)練的圖像編碼器的視覺(jué)特征,把它和音頻特征逐像素視聽(tīng)融合來(lái)聚合跨模態(tài)表示

2023-05-24 16:00:02 500

500

的有這么強(qiáng)大嗎?讓我們一起通過(guò)本文了解詳情! SAM 是一個(gè)由 Meta AI 實(shí)驗(yàn)室推出的強(qiáng)大人工智能圖像分割應(yīng)用,可以自動(dòng)識(shí)別哪些圖像像素屬于一個(gè)對(duì)象,并且對(duì)圖像中各個(gè)對(duì)象進(jìn)行自動(dòng)風(fēng)格處理,可廣泛用于分析科學(xué)圖像、編輯照片等。 SAM 的完整應(yīng)用由一個(gè)圖片編碼器模型(encoder)

2023-06-12 10:46:56 2622

2622

今日,Meta 推出了首個(gè)基于 LeCun 世界模型概念的 AI 模型。該模型名為圖像聯(lián)合嵌入預(yù)測(cè)架構(gòu)(Image Joint Embedding Predictive Architecture, I-JEPA),它通過(guò)創(chuàng)建外部世界的內(nèi)部模型來(lái)學(xué)習(xí), 比較圖像的抽象表示(而不是比較像素本身)。

2023-06-15 15:47:34 201

201

分割任何模型 (Segment Anything Model - SAM) 是一種突破性的圖像分割模型,可實(shí)現(xiàn)具有實(shí)時(shí)性能的快速分割。

2023-06-18 11:42:53 1027

1027

大家好,YOLOv8 框架本身提供的API函數(shù)是可以兩行代碼實(shí)現(xiàn) YOLOv8 模型推理,這次我把這段代碼封裝成了一個(gè)類,只有40行代碼左右,可以同時(shí)支持YOLOv8對(duì)象檢測(cè)、實(shí)例分割、姿態(tài)評(píng)估模型的GPU與CPU上推理演示。

2023-06-18 11:50:44 1891

1891

? 因果推理是人類智力的標(biāo)志之一。因果關(guān)系NLP領(lǐng)域近年來(lái)引起了人們的極大興趣,但其主要依賴于從常識(shí)知識(shí)中發(fā)現(xiàn)因果關(guān)系。本研究提出了一個(gè)基準(zhǔn)數(shù)據(jù)集(CORR2CAUSE)來(lái)測(cè)試大語(yǔ)言模型(LLM

2023-06-20 15:39:05 1223

1223

導(dǎo)讀 本文提出一種"解耦蒸餾"方案對(duì)SAM的ViT-H解碼器進(jìn)行蒸餾,同時(shí)所得輕量級(jí)編碼器可與SAM的解碼器"無(wú)縫兼容"?。在推理速度方面,MobileSAM處理一張圖像僅需10ms

2023-06-30 10:59:08 673

673

比Meta的「分割一切模型」(SAM)更快的圖像分割工具,來(lái)了! 最近中科院團(tuán)隊(duì)開(kāi)源了FastSAM模型,能以 50倍的速度 達(dá)到與原始SAM相近的效果,并實(shí)現(xiàn)25FPS的實(shí)時(shí)推理。 該成果

2023-07-03 17:06:08 630

630

使用集成模型在 NVIDIA Triton 推理服務(wù)器上為 ML 模型管道提供服務(wù)

2023-07-05 16:30:34 1082

1082

深度學(xué)習(xí)模型部署有OpenVINO、ONNXRUNTIME、TensorRT三個(gè)主流框架,均支持Python與C++的SDK使用。對(duì)YOLOv5~YOLOv8的系列模型,均可以通過(guò)C++推理實(shí)現(xiàn)模型

2023-08-06 11:39:17 1677

1677 IEEE高級(jí)會(huì)員、天津理工大學(xué)教授、AR/VR技術(shù)專家羅訓(xùn)對(duì)記者表示,SAM是視覺(jué)領(lǐng)域的通用大模型,很多報(bào)道中把它比喻成視覺(jué)領(lǐng)域的ChatG-PT,SAM和ChatGPT的支撐技術(shù)和應(yīng)用場(chǎng)景都是不同的,但是在通用性這一點(diǎn)上,它們都是當(dāng)前技術(shù)發(fā)展趨勢(shì)的代表者。

2023-08-23 16:32:19 529

529 在 MLC-LLM 部署RWKV World系列模型實(shí)戰(zhàn)(3B模型Mac M2解碼可達(dá)26tokens/s) 中提到要使用mlc-llm部署模型首先需要一個(gè)編譯過(guò)程,將原始的基于Realx搭建的模型

2023-09-26 12:25:55 383

383

vLLM是一個(gè)開(kāi)源的大模型推理加速框架,通過(guò)PagedAttention高效地管理attention中緩存的張量,實(shí)現(xiàn)了比HuggingFace Transformers高14-24倍的吞吐量。

2023-10-10 15:09:58 1556

1556

背景介紹TPU-MLIR編譯器可以將機(jī)器學(xué)習(xí)模型轉(zhuǎn)換成算能芯片上運(yùn)行的bmodel模型。由于浮點(diǎn)數(shù)的計(jì)算需要消耗更多的計(jì)算資源和存儲(chǔ)空間,實(shí)際應(yīng)用中往往采用量化后的模型(也稱定點(diǎn)模型)進(jìn)行推理。相比

2023-10-10 10:17:42 484

484

昆侖芯科技公眾號(hào)全新欄目“用芯指南”重磅推出!面向AI行業(yè)技術(shù)從業(yè)者,系列好文將提供手把手的昆侖芯產(chǎn)品使用指南。第一期圍繞昆侖芯自研效能工具——昆侖芯Anyinfer展開(kāi),這是一款基于昆侖芯AI加速卡的高效模型推理部署框架。種種行業(yè)痛點(diǎn),昆侖芯Anyinfer輕松搞定。

2023-10-17 11:16:43 799

799

近日,位于江寧高新區(qū)的江蘇運(yùn)動(dòng)健康研究院傳來(lái)好消息,在東南大學(xué)生物科學(xué)與醫(yī)學(xué)工程學(xué)院院長(zhǎng)、江蘇運(yùn)動(dòng)健康研究院院長(zhǎng)顧忠澤教授團(tuán)隊(duì)與華為公司的強(qiáng)強(qiáng)聯(lián)合下,全球首個(gè)人體器官芯片醫(yī)藥大模型近日在江寧問(wèn)世

2023-10-20 08:43:41 261

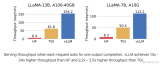

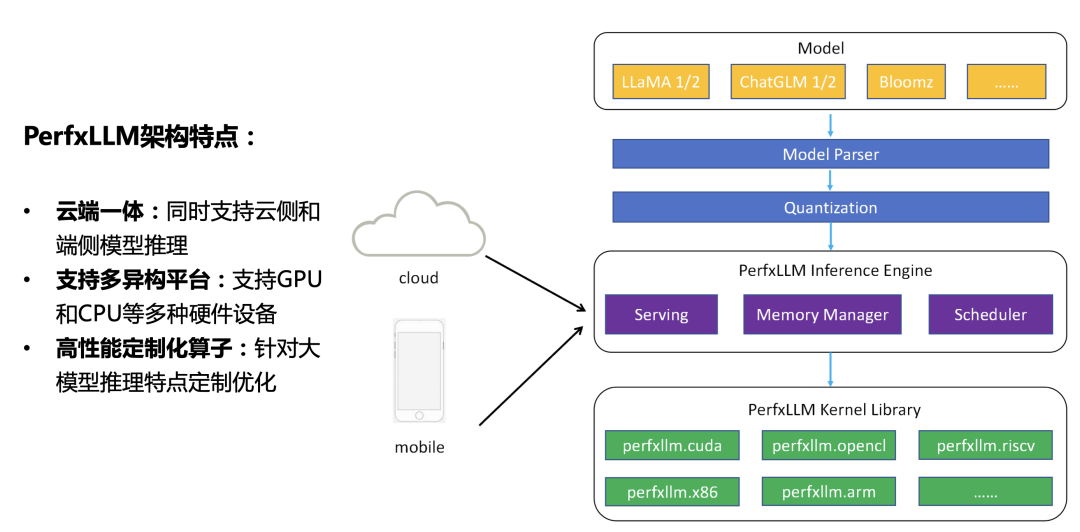

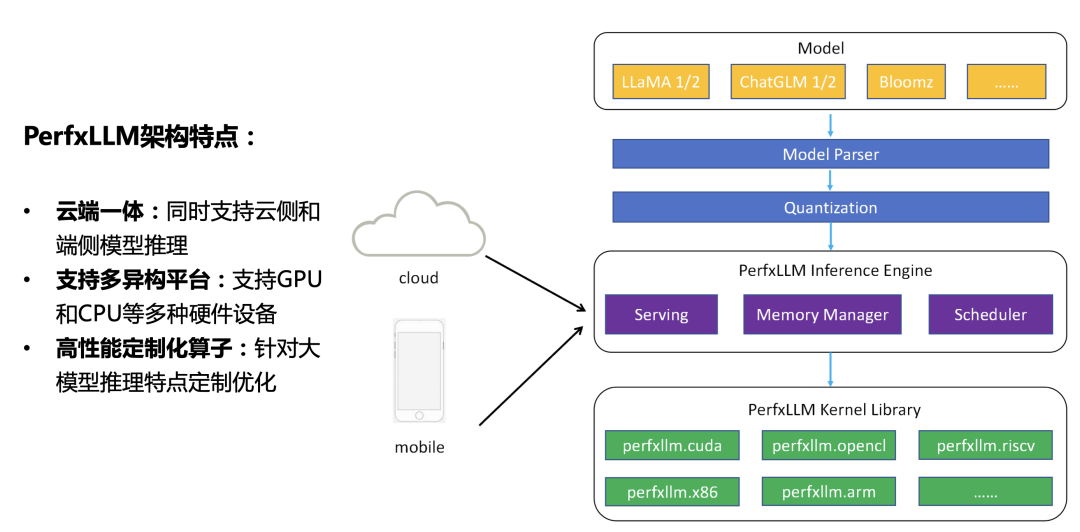

261 要的巨額開(kāi)銷也引發(fā)了相關(guān)研究者的關(guān)注。如何高效地進(jìn)行推理,并盡可能地減少成本,從而促進(jìn)大模型應(yīng)用的落地成為了目前的關(guān)鍵問(wèn)題。 于是,澎峰科技研發(fā)了一款 大模型推理引擎—PerfXLLM ,并且已經(jīng)在 高通的 驍龍8Gen2 平臺(tái)實(shí)現(xiàn)了應(yīng)用 。接下來(lái)將分為四個(gè)部分進(jìn)行介紹,第一部分將介

2023-11-25 15:35:01 383

383

工具包中的LLM Runtime為諸多模型顯著降低時(shí)延,且首個(gè)token和下一個(gè)token的推理速度分別提升多達(dá)40倍和2.68倍,還能滿足更多場(chǎng)景應(yīng)用需求。 英特爾 ?Extension

2023-12-01 20:40:03 552

552

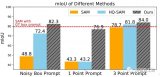

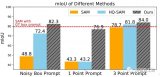

SAM、HQ-SAM、Stable-SAM在提供次優(yōu)提示時(shí)的性能比較,Stable-SAM明顯優(yōu)于其他算法。這里也推薦工坊推出的新課程《如何將深度學(xué)習(xí)模型部署到實(shí)際工程中?

2023-12-29 14:35:14 252

252

因果推理能力對(duì)于許多自然語(yǔ)言處理(NLP)應(yīng)用至關(guān)重要。最近的因果推理系統(tǒng)主要基于經(jīng)過(guò)微調(diào)的預(yù)訓(xùn)練語(yǔ)言模型(PLMs),如BERT [1] 和RoBERTa [2]。

2024-01-03 09:55:37 420

420

萬(wàn)興科技近日正式發(fā)布了國(guó)內(nèi)首個(gè)音視頻多媒體大模型——萬(wàn)興“天幕”,并宣布大模型研發(fā)中心將正式落戶馬欄山。

2024-02-04 11:42:03 785

785 Groq推出了大模型推理芯片,以每秒500tokens的速度引起轟動(dòng),超越了傳統(tǒng)GPU和谷歌TPU。

2024-02-26 10:24:46 289

289

人工智能推理的重要性日益凸顯,高效運(yùn)行端側(cè)大模型及AI軟件背后的核心技術(shù)正是推理。不久的未來(lái),全球芯片制造商的主要市場(chǎng)將全面轉(zhuǎn)向人工智能推理領(lǐng)域。

2024-02-29 16:46:08 557

557

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論